My Java Guide(Legacy)

服务端,All in Boom!

—— 2024年10月7日深夜

—————————————

线性表

1 | class SqList { |

反转数组

1 | public void reverseSqList(int[] arr) { |

反转链表

反转一个单链表。

1 | public ListNode reverseLinkList(ListNode head) { |

合并两个数组

合并两个有序数组为一个有序数组。

1 | public void merge(int[] nums1, int m, int[] nums2, int n) { |

合并两个链表

1 | /** |

拆分两个数组

1 | public static void splitArray(int[] inputArray) { |

拆分两个链表

1 | /** |

TopK

1 | // 最小堆法 |

数组和列表之间的转换

1 | //数组转列表 |

栈、队列

用栈实现队列

1 | public class QueueWithTwoStacks { |

用数组实现循环队列

1 | public class CircularQueue { |

有效的括号

判断字符串中的括号是否有效配对。例如[]{()()}}。

1 | public boolean isValid(String s) { |

最小栈

设计一个可以获取最小元素的栈。

1 | class MinStack { |

二叉树

二叉树结构

1 | class TreeNode { |

前序|中序|后序、层次遍历

实现二叉树的前序、中序、后序、层次遍历。

1 | // 前序遍历 (根-左-右) |

1 | // 中序遍历 (左-根-右) |

1 | // 后序遍历 (左-右-根) |

1 | // 层次遍历 |

查找、插入、删除、更新

1 | // 查找 |

1 | // 插入新节点 |

1 | // 删除节点 |

1 | // 更新 |

翻转二叉树

1 | //翻转二叉树 |

判断路径总和

判断二叉树中是否存在一条路径,其路径和等于给定的数值。

1 | public boolean hasPathSum(TreeNode root, int sum) { |

判断镜像二叉树

判断一个二叉树是否是它的镜像。

1 | public boolean isSymmetric(TreeNode root) { |

哈夫曼树

哈夫曼编码原理

哈夫曼树结构

1 | class HuffmanNode<T> extends BinaryNode<T> implements Comparable<HuffmanNode<T>> { |

构建哈夫曼树

1 | // 处理字符串 |

哈夫曼编码、解码

1 | // 编码 |

1 | // 解码 |

计算带权路径长度、压缩率

1 | public static int calculateWPL(HuffmanNode<Character> node, int depth) { |

1 | public static int calculateOriginalSize(String str) { |

搜索算法

广度优先搜索

深度优先搜索

1 | public class 搜索算法_DFS_BFS { |

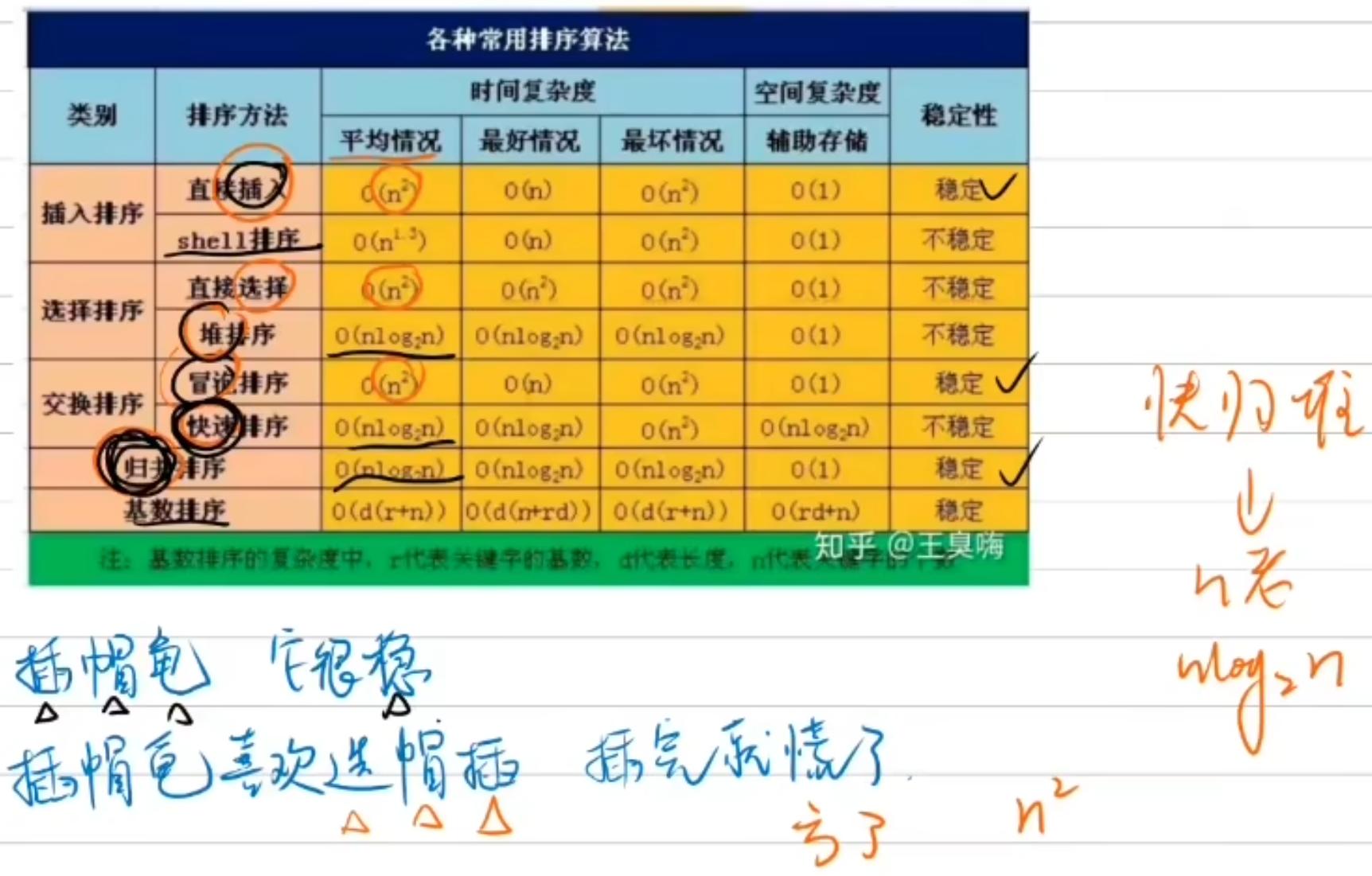

排序算法

交换算法

1 | /** |

插入类排序

1 | /**********************插入类排序**********************/ |

在插入排序时,使用二分查找找到插入的位置,从而减少比较次数(但仍然需要线性时间插入元素)。

1 | /** |

选择类排序

1 | /**********************选择类排序**********************/ |

在选择最小元素时,记录最小元素的索引,并在每次找到更小元素时更新索引。

1 | /** |

1 | /** |

交换类排序

1 | /**********************交换类排序**********************/ |

1 | /** |

1 | //快速排序:先选择一个基准(哨兵值)然后分成两部分递归,如此往复 |

1 | /** |

归并类排序

1 | /**********************归并类排序**********************/ |

1 | /** |

分布类排序

1 | /**********************分布类排序**********************/ |

1 | // 主函数,执行基数排序 |

二分查找

1 | public static int binSearch(int[] arr, int low, int high, int item) { |

—————————————

数据淘汰算法

LRU 算法(最近最少使用)

设计一个数据结构,实现最近最少使用缓存。

通过哈希表和双向链表实现。哈希表提供 O(1) 的查找时间,双向链表维护访问顺序。

1 | // 直接继承法,继承LinkedHashMap,只需要重写get和put、修改淘汰规则即可 |

LFU 算法(频率最少使用)

设计一个数据结构,实现最不经常使用缓存。

LFU 缓存需要同时记录使用频率和访问时间,通过哈希表和最小堆实现。

1 | class LFUCache { |

多线程并发题

多线程交替打印数字

两个线程交替打印数字,一个线程打印奇数,另一个线程打印偶数,直到100。

使用synchronized实现

1 | class PrintOddEven { |

使用ReentrantLock实现

1 | import java.util.concurrent.locks.Condition; |

使用Semaphore实现

1 | import java.util.concurrent.Semaphore; |

多线程按顺序打印ABC

三个线程按顺序打印ABC,重复10次。

1 | public class 线程交替打印字母_PrintABC { |

模拟死锁

1 | class DeadLockDemo2 { |

模拟消息队列

使用阻塞队列实现生产者消费者问题。

1 | import java.util.concurrent.ArrayBlockingQueue; |

哲学家进餐问题

使用信号量解决哲学家进餐问题。

1 | class Philosopher implements Runnable { |

使用CyclicBarrier实现多线程任务

使用CyclicBarrier实现多个线程分段执行任务,每个线程打印自己的任务完成后,等待其他线程到达,然后继续下一段任务。

1 | import java.util.concurrent.BrokenBarrierException; |

使用CountDownLatch实现任务协调

使用CountDownLatch等待多个线程完成任务后再继续主线程执行。

1 | import java.util.concurrent.CountDownLatch; |

使用Exchanger实现线程间数据交换

使用Exchanger实现两个线程交换数据。

1 | import java.util.concurrent.Exchanger; |

拓展:实现和指定的线程交换数据

1 | class ExchangerRegistry { |

—————————————

数学相关

两数之和

在数组中找到两个数,使它们的和等于给定的数。

1 | public int[] twoSum(int[] nums, int target) { |

两数之和 II

在一个排序列表中找到两个数,使它们的和等于给定的数。

1 | public int[] twoSum(int[] numbers, int target) { |

快乐数

判断一个数是否为快乐数,即反复将每个位的数字平方求和,最终会得到1。

1 | public boolean isHappy(int n) { |

罗马数字转整数

将罗马数字转换为整数。

1 | public int romanToInt(String s) { |

整数反转

给你一个32位的有符号的int类型的数字,将数字上的每一位进行反转。

1 | public int reverseInt(int x) { |

滑动窗口、动归

爬楼梯

1 | public int climbStairs(int n) { |

1 | public int lengthOfLIS(int[] nums) { |

能否组成顺子

1 | class Shunzi{ |

最长公共前缀

找到字符串数组中的最长公共前缀。

1 | // 解法一:startsWith匹配 |

最长递增子串的长度

递增子串:每个相邻的数字之差为1,例如”1,2,3,4,5”

1 | public static int lengthOfCSQ(int[] nums) { |

最长递增子序列的长度

递增子序列:不考虑前后数字是否相邻,只要是递增的就行,例如”1,…,4,9,…,10,…,17”

1 | public int lengthOfNCSQ(int[] nums) { |

最大子数组和

1 | class MaxSubArray{ |

最大连续子数组和

1 | class MaxContinuousSubArray { |

旋转数组

给定一个数组,将数组中的元素向右移动 k 个位置。

1 | public void rotate(int[] nums, int k) { |

搜索旋转排序数组

在旋转排序数组中查找一个特定的元素。

1 | public int search(int[] nums, int target) { |

是否是回文数

判断一个整数是否是回文数,即正读和反读都一样。

1 | public boolean isPalindrome(int x) { |

回文串判断

1 | private static String getString(){ |

[最长回文子串](5. 最长回文子串 - 力扣(LeetCode))

1 | public static String longestPalindrome(String s) { |

最长回文子串的长度

1 | public static int longestPalindromeLength(String s) { |

最长回文子序列的长度

1 | public static int longestPalindromeSubseqLength(String s) { |

无重复字符的最长子串

示例 1:

1 | 输入: s = "abcabcbb" |

示例 2:

1 | 输入: s = "bbbbb" |

示例 3:

1 | 输入: s = "pwwkew" |

1 | public int lengthOfLongestSubstring(String s) { |

寻找两个正序数组的中位数(暴力版)

1 | public double findMedianSortedArrays(int[] nums1, int[] nums2) { |

#————————————–

#操作系统

用户态和内核态

指处理器运行在不同权限级别的两种模式。这两种模式的设计目的是为了提高系统的安全性,并且防止用户程序错误地影响到整个系统的稳定性和数据的安全性。

用户态(User Mode)

用户态是指普通应用程序运行时所在的模式。在这种模式下,应用程序只能访问受限制的系统资源和服务。用户态程序不能直接访问硬件或执行某些特权指令,这样可以防止由于程序错误或恶意行为而导致系统崩溃或数据损坏。

在用户态下运行的应用程序包括但不限于:

- 文档编辑器

- 游戏

- 浏览器

- 办公软件

- 大部分用户级服务

内核态(Kernel Mode)

内核态是指操作系统内核运行时所在的模式。在内核态下,程序拥有完全的系统访问权限,可以执行任何指令,直接访问硬件资源。这种模式下的代码通常是经过严格审查的,因为任何错误都可能导致系统不稳定甚至崩溃。

在内核态下运行的组件包括:

- 文件系统驱动

- 设备驱动

- 网络协议栈

- 进程调度器

- 内存管理模块

用户态和内核态之间的转换

用户态下的应用程序需要调用操作系统提供的系统调用(System Call)来请求内核提供的服务,例如读写文件、分配内存、创建进程等。当应用程序发起一个系统调用时,CPU会从用户态切换到内核态,操作系统内核处理完请求后再从内核态切换回用户态。这种转换涉及到:

- 保护上下文:保存用户态的寄存器状态和程序计数器。

- 执行系统调用处理程序:操作系统内核中的代码负责处理系统调用。

- 恢复上下文:完成系统调用后,恢复用户态的寄存器状态和程序计数器。

进程的调度算法

| 调度算法 | 描述 | 优点 | 缺点 |

|---|---|---|---|

| 先来先服务(First-Come, First-Served, FCFS) | 按照进程到达的先后顺序进行调度 | 实现简单,易于理解 | 可能导致长进程饿死短进程(长作业优先),响应时间较长 |

| 短作业优先(Shortest Job First, SJF) | 总是选择预计执行时间最短的进程来执行 | 可以最小化平均等待时间 | 需要知道进程的确切执行时间,实现复杂,且可能不公平对待长进程 |

| 最短剩余时间优先(Shortest Remaining Time First, SRTF) | 总是选择剩余执行时间最短的进程来执行 | 可以动态调整,更好地适应实际情况 | 需要实时更新剩余时间,实现较为复杂 |

| 时间片轮转(Round Robin, RR) | 给每个就绪队列中的进程分配一个固定的时间片(时间量子),并在时间片结束后强制切换到下一个进程 | 简单公平,适用于交互式系统 | 时间片的选择至关重要,否则可能会影响响应时间和吞吐量 |

| 优先级调度(Priority Scheduling) | 根据进程的优先级来调度,优先级高的进程优先执行 | 可以根据进程的重要性灵活调度 | 可能造成饥饿(starvation),即低优先级的进程永远得不到执行的机会 |

……还有很多,不列举了

进程间的通信方式

进程间通信(IPC)主要包括以下几种方式:

- 管道(Pipe)是最古老的进程间通信机制之一,所有的 UNIX 系统都支持这种机制。管道实质上是内核维护的一块内存缓冲区。Linux 系统中通过

pipe()函数创建管道,这会生成两个文件描述符,分别对应管道的读端和写端。无名管道仅限于具有亲缘关系的进程间通信。 - 命名管道(FIFO) 命名管道(Named Pipe 或 FIFO 文件)克服了无名管道只能用于亲缘进程通信的限制。命名管道提供了一个路径名与之关联,作为文件系统中的一个 FIFO 文件存在。任何能够访问该路径的进程,即便与创建该 FIFO 的进程无关,也可以通过该 FIFO 进行通信。

- 信号 信号是进程间通信的另一种古老方式,作为一种异步通知机制,它可以在一个进程中产生中断,使进程能够响应某些事件。信号可以看作是软件层次上的中断机制,用于处理突发事件。

- 消息队列 消息队列是一个链表结构,其中包含具有特定格式和优先级的消息。具有写权限的进程可以按规则向消息队列中添加消息,而具有读权限的进程可以从队列中读取消息。消息队列是随内核持续存在的。

- 共享内存 共享内存允许多个进程共享同一块物理内存区域。这种机制允许进程直接在共享内存中进行数据交换,不需要内核的干预,因此速度较快。

- 内存映射 内存映射技术将磁盘文件的数据映射到内存,用户可以通过修改内存中的内容来间接修改磁盘文件。

- 信号量 信号用于解决进程或线程间的同步问题。对信号量的操作包括 P 操作(减 1)和 V 操作(加 1),用于控制进程或线程的互斥访问。

- Socket Socket 是网络中不同主机上应用程序之间进行双向通信的端点的抽象。它为应用层提供了使用网络协议进行数据交换的机制,主要用于网络中不同主机上的进程间通信。

什么是软中断、什么是硬中断?

| 中断类型 | 描述 | 特点 | 例子 |

|---|---|---|---|

| 硬中断 | 由硬件设备引发的中断信号 | 外部来源:由外部硬件设备引发。 硬件触发:通常由设备通过 IRQ 线向 CPU 发送中断信号。 实时性:通常要求立即响应。 硬件驱动程序处理:中断处理程序通常由硬件驱动程序编写。 |

键盘中断:按下键盘按键。 网络中断:网络适配器接收到数据包。 定时器中断:定时器硬件定时发送中断信号。 |

| 软中断 | 由软件指令或内核代码触发的中断信号 | 内部来源:由软件指令或内核代码触发。 软件触发:通过特定的指令或函数调用触发。 灵活性:可以根据需要随时触发。 内核处理:通常由内核中的中断处理程序处理。 |

系统调用:应用程序调用系统服务。 时间片到期:时间片结束时触发。 异常处理:如页错误、除零错误等。 |

什么是分段、什么是分页?

| 特点 | 分段(Segmentation) | 分页(Paging) |

|---|---|---|

| 逻辑划分 | 将逻辑地址空间划分为多个逻辑段,每个段代表程序的一部分。 | 将逻辑地址空间划分为固定大小的页面。 |

| 大小 | 段的大小可以是动态变化的,每个段可以有不同的大小。 | 页面的大小是固定的,通常是 4KB 或更大。 |

| 映射 | 段可以映射到物理内存中的连续或非连续区域。 | 页面映射到物理内存中的连续或非连续区域。 |

| 保护 | 每个段可以单独保护和管理,有利于实现访问控制和保护。 | 页面级别的保护,但通常不如分段灵活。 |

| 缺点 | 实现复杂,可能导致内存碎片。 | 可能导致内存碎片,但通常较少。 |

| 应用场景 | 适合需要逻辑分段的应用程序,如操作系统内核、数据库管理系统等。 | 适合大多数应用程序,特别是需要虚拟内存支持的应用程序。 |

| 代表性系统 | Unix、早期的 Windows 操作系统。 | Linux、现代 Windows 操作系统。 |

什么是 Channel?

在计算机科学和软件开发中,“Channel”(通道)是一个广泛使用的术语,它在不同的上下文中可以有不同的含义。这里我们将讨论几种常见的“Channel”的定义及其用途:

1. 操作系统中的 Channel

在操作系统中,“Channel”通常指的是用于在进程之间进行通信的一种机制。它可以看作是一种高级的 IPC(Inter-Process Communication)机制,用于在进程之间传递数据。

特点:

- 通信媒介:Channel 作为进程间通信的媒介,可以实现数据的发送和接收。

- 同步:通常 Channel 机制会包含同步机制,确保数据的正确传递。

例子:

- 管道(Pipe):在 Unix/Linux 系统中,管道是一种典型的 Channel,用于连接两个进程,使一个进程的输出成为另一个进程的输入。

- 命名管道(Named Pipe/FIFO):与管道类似,但可以在不同的进程或用户之间共享,通过文件名来标识。

2. 并发编程中的 Channel

在并发编程中,Channel 是一种用于通信和同步的基本原语,特别是在函数式编程语言和并发模型(如 Go 语言的 goroutines)中。

特点:

- 数据传递:Channel 用于在并发执行的线程或协程之间传递数据。

- 同步机制:Channel 提供了一种同步方式,确保数据的有序传递和一致性。

- 阻塞行为:Channel 可以是阻塞的或非阻塞的,具体取决于是否有数据可以接收或发送。

例子:

- Go 语言的 Channel:Go 语言中的 Channel 是用于 goroutine 之间通信的基本机制,可以传递任意类型的数据。

- Haskell 的 TChan:Haskell 中的

TChan是一种用于线程间通信的 Channel。

3. 网络通信中的 Channel

在网络通信中,“Channel”通常指的是一种逻辑上的连接或通信路径,用于传输数据。

特点:

- 逻辑连接:在网络层面上,Channel 可以指一条逻辑上的连接,如 TCP 连接。

- 数据传输:Channel 用于在网络节点之间传输数据包。

例子:

- TCP 连接:TCP 连接可以视为一种 Channel,用于在客户端和服务器之间建立稳定的双向通信路径。

- WebSocket:WebSocket 是一种全双工的通信协议,可以在客户端和服务器之间建立持久的 Channel。

4. 应用程序中的 Channel

在某些应用程序中,Channel 也可以指一种用于组织和管理数据流的方式。

特点:

- 数据组织:Channel 可以用于组织不同类型的数据流。

- 逻辑隔离:不同的 Channel 可以用于隔离不同类型的数据传输。

例子:

- 多媒体播放器中的音频/视频 Channel:在多媒体播放器中,音频和视频数据流可以被视为不同的 Channel。

- 消息队列中的 Topic:在消息队列系统(如 Apache Kafka)中,Topic 可以被视为一种 Channel,用于组织不同类型的消息。

- Buffer:用于缓存数据,提高 I/O 效率。

- Selector:用于监控多个文件描述符的状态,实现多路复用。

- Reactor:结合 Selector 和事件驱动的设计模式,用于处理并发 I/O 操作。

- Select、Poll、Epoll:三种不同的文件描述符监控机制,分别适用于不同场景。

什么是 Buffer?

Buffer通常指用于临时存储数据的内存区域。在计算机科学中,Buffer 主要用于缓存数据,以便进行批量处理或提高数据传输效率。

作用:

- 数据缓存:临时存储数据,以减少 I/O 操作次数。

- 流量控制:在数据传输过程中,用于平滑数据流,防止数据丢失。

- 同步:在多线程或多进程环境中,Buffer 用于同步数据。

例子:

- 网络编程中的 Buffer:在网络编程中,接收的数据通常先存储在一个 Buffer 中,然后再进行处理。

- 文件系统中的 Buffer:在文件系统中,读取或写入的数据通常先存储在 Buffer 中,以减少磁盘 I/O 操作。

什么是 Selector?

Selector是一种用于监控多个文件描述符(File Descriptor)状态的技术,通常用于网络编程中的多路复用(Multiplexing)。

作用:

- 多路复用:同时监控多个文件描述符的状态,如读写就绪状态。

- 非阻塞:当没有数据可读或可写时,不会阻塞当前线程。

- 效率:相比于传统的阻塞 I/O,使用 Selector 可以大大提高 I/O 效率。

例子:

- Java NIO 中的 Selector:在 Java 的 NIO(New IO)框架中,

Selector用于监控多个SocketChannel的状态。 - POSIX 系统中的 Select 和 Poll:在 POSIX 系统中,

select()和poll()是常用的 Selector 实现。

什么是 Reactor?

Reactor是一种设计模式,用于处理并发 I/O 操作。它结合了 Selector 和事件驱动的设计思想,通常用于构建高性能的网络服务器。

作用:

- 事件驱动:监听并处理多个 I/O 事件。

- 非阻塞:当没有 I/O 事件发生时,不会阻塞当前线程。

- 可扩展性:通过事件循环处理 I/O 事件,易于扩展和维护。

例子:

- Reactor 模式:在高性能服务器中,Reactor 模式常用于处理大量的并发连接。

- 事件驱动框架:如 libevent、libuv 等,提供了基于 Reactor 模式的设计框架。

Select、Poll、Epoll 之间有什么区别?

Select:select() 是一个用于监控多个文件描述符的系统调用。

- 支持的文件描述符数量有限(通常为 FD_SETSIZE)。

- 可以同时监控读、写和异常状态。

- 在 Linux 中,

select()的效率较低,因为需要遍历所有的文件描述符。

适用场景:适合文件描述符较少的场景。

Poll:poll() 是 select() 的改进版本,同样用于监控多个文件描述符的状态。

- 不受文件描述符数量限制。

- 每个文件描述符的状态信息保存在

pollfd结构中。 - 效率高于

select(),因为不需要遍历所有文件描述符。

适用场景:适合文件描述符较多的场景。

Epoll:epoll() 是 Linux 内核提供的一个高效的文件描述符监控机制。

- 使用事件驱动的方式,只有状态改变的文件描述符才会被激活。

- 支持动态添加和删除监控对象。

- 效率最高,因为只关心状态发生变化的文件描述符。

适用场景:适合高性能网络服务器,尤其是需要处理大量并发连接的场景。

—————————————

计算机网络

模型

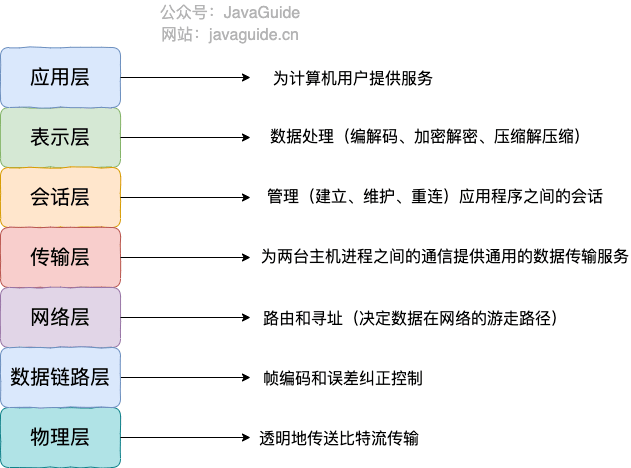

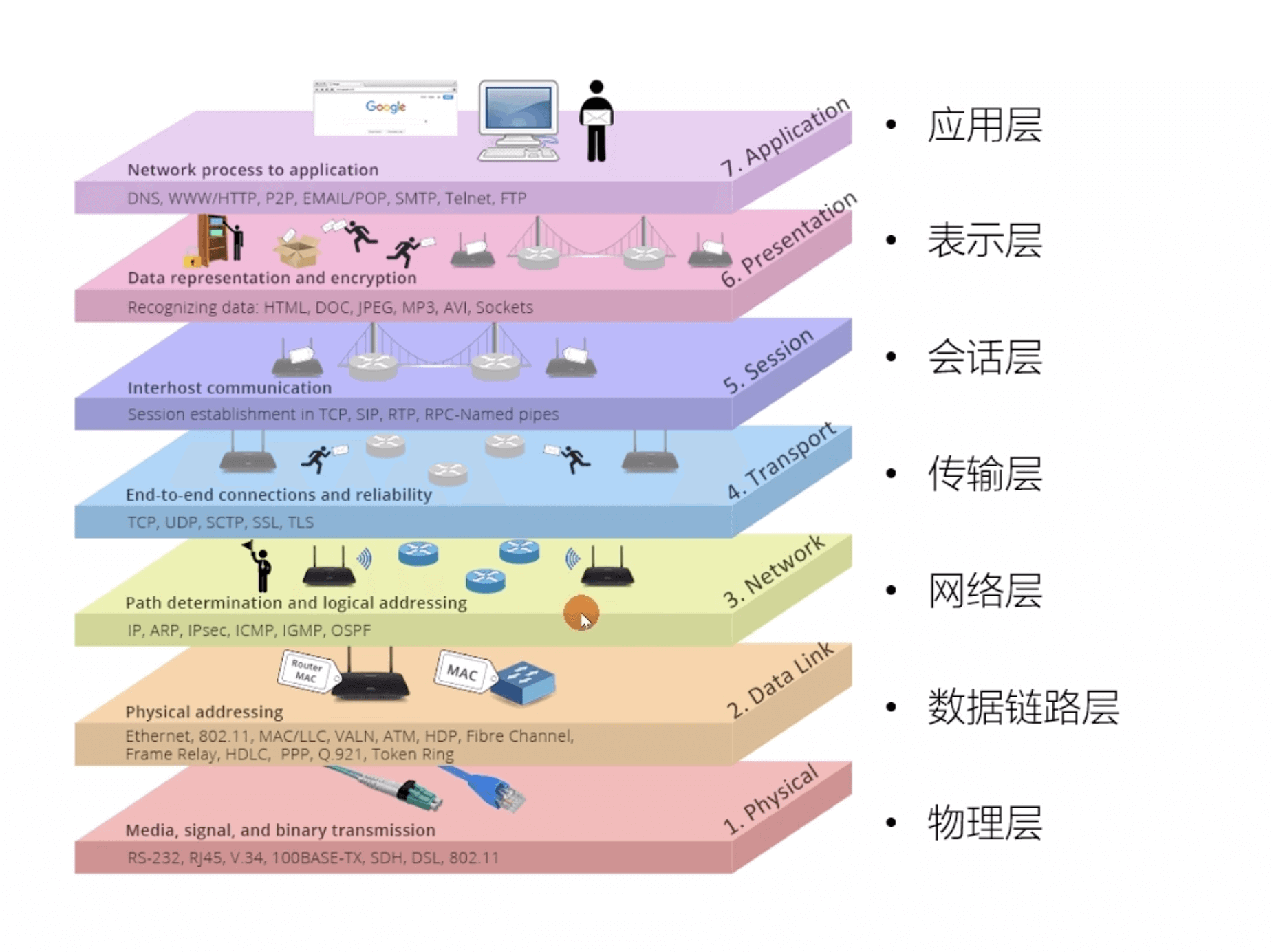

OSI 七层模型

OSI 七层模型 是国际标准化组织提出的一个网络分层模型,其大体结构以及每一层提供的功能如下图所示:

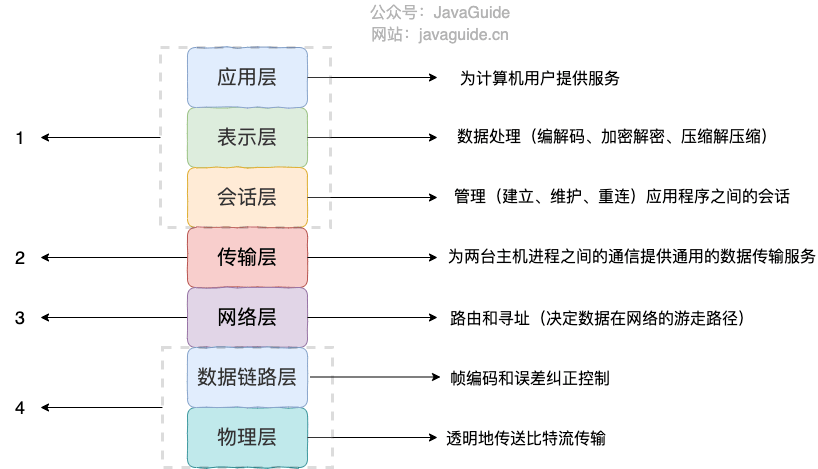

TCP/IP 四层模型

TCP/IP 四层模型 是目前被广泛采用的一种模型,我们可以将 TCP / IP 模型看作是 OSI 七层模型的精简版本,由以下 4 层组成:

- 应用层

- 传输层

- 网络层

- 网络接口层

需要注意的是,我们并不能将 TCP/IP 四层模型 和 OSI 七层模型完全精确地匹配起来,不过可以简单将两者对应起来,如下图所示:

协议

常见网络协议汇总

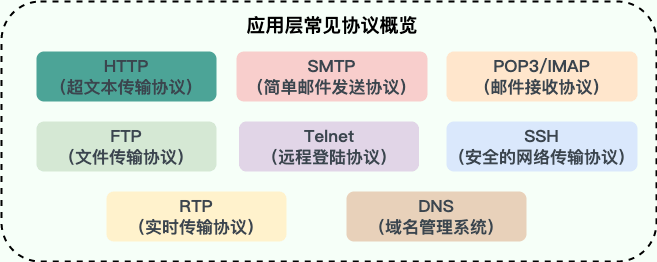

1. 应用层有哪些常见的协议?

- HTTP(Hypertext Transfer Protocol,超文本传输协议):基于 TCP 协议,是一种用于传输超文本和多媒体内容的协议,主要是为 Web 浏览器与 Web 服务器之间的通信而设计的。当我们使用浏览器浏览网页的时候,我们网页就是通过 HTTP 请求进行加载的。

- SMTP(Simple Mail Transfer Protocol,简单邮件发送协议):基于 TCP 协议,是一种用于发送电子邮件的协议。注意 :SMTP 协议只负责邮件的发送,而不是接收。要从邮件服务器接收邮件,需要使用 POP3 或 IMAP 协议。

- POP3/IMAP(邮件接收协议):基于 TCP 协议,两者都是负责邮件接收的协议。IMAP 协议是比 POP3 更新的协议,它在功能和性能上都更加强大。IMAP 支持邮件搜索、标记、分类、归档等高级功能,而且可以在多个设备之间同步邮件状态。几乎所有现代电子邮件客户端和服务器都支持 IMAP。

- FTP(File Transfer Protocol,文件传输协议) : 基于 TCP 协议,是一种用于在计算机之间传输文件的协议,可以屏蔽操作系统和文件存储方式。注意 ⚠️:FTP 是一种不安全的协议,因为它在传输过程中不会对数据进行加密。建议在传输敏感数据时使用更安全的协议,如 SFTP。

- Telnet(远程登陆协议):基于 TCP 协议,用于通过一个终端登陆到其他服务器。Telnet 协议的最大缺点之一是所有数据(包括用户名和密码)均以明文形式发送,这有潜在的安全风险。这就是为什么如今很少使用 Telnet,而是使用一种称为 SSH 的非常安全的网络传输协议的主要原因。

- SSH(Secure Shell Protocol,安全的网络传输协议):基于 TCP 协议,通过加密和认证机制实现安全的访问和文件传输等业务

- RTP(Real-time Transport Protocol,实时传输协议):通常基于 UDP 协议,但也支持 TCP 协议。它提供了端到端的实时传输数据的功能,但不包含资源预留存、不保证实时传输质量,这些功能由 WebRTC 实现。

- DNS(Domain Name System,域名管理系统): 基于 UDP 协议,用于解决域名和 IP 地址的映射问题。

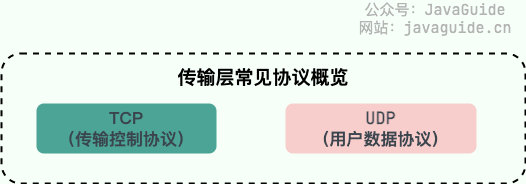

2. 传输层有哪些常见的协议?

- TCP(Transmission Control Protocol,传输控制协议 ):提供 面向连接 的,可靠 的数据传输服务。

- UDP(User Datagram Protocol,用户数据协议):提供 无连接 的,尽最大努力 的数据传输服务(不保证数据传输的可靠性),简单高效。

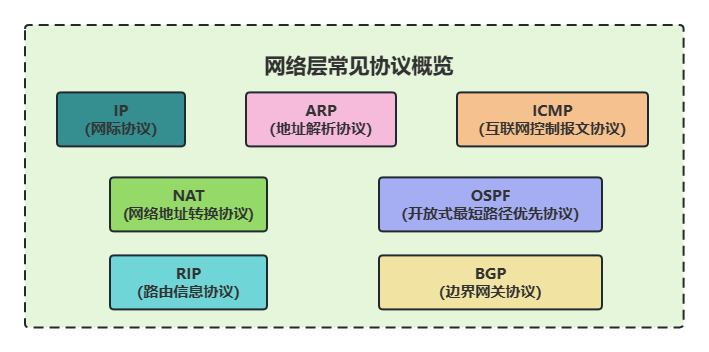

3. 网络层有哪些常见的协议?

- IP(Internet Protocol,网际协议):TCP/IP 协议中最重要的协议之一,属于网络层的协议,主要作用是定义数据包的格式、对数据包进行路由和寻址,以便它们可以跨网络传播并到达正确的目的地。目前 IP 协议主要分为两种,一种是过去的 IPv4,另一种是较新的 IPv6,目前这两种协议都在使用,但后者已经被提议来取代前者。

- ARP(Address Resolution Protocol,地址解析协议):ARP 协议解决的是网络层地址和链路层地址之间的转换问题。因为一个 IP 数据报在物理上传输的过程中,总是需要知道下一跳(物理上的下一个目的地)该去往何处,但 IP 地址属于逻辑地址,而 MAC 地址才是物理地址,ARP 协议解决了 IP 地址转 MAC 地址的一些问题。

- ICMP(Internet Control Message Protocol,互联网控制报文协议):一种用于传输网络状态和错误消息的协议,常用于网络诊断和故障排除。例如,Ping 工具就使用了 ICMP 协议来测试网络连通性。

- NAT(Network Address Translation,网络地址转换协议):NAT 协议的应用场景如同它的名称——网络地址转换,应用于内部网到外部网的地址转换过程中。具体地说,在一个小的子网(局域网,LAN)内,各主机使用的是同一个 LAN 下的 IP 地址,但在该 LAN 以外,在广域网(WAN)中,需要一个统一的 IP 地址来标识该 LAN 在整个 Internet 上的位置。

- OSPF(Open Shortest Path First,开放式最短路径优先) ):一种内部网关协议(Interior Gateway Protocol,IGP),也是广泛使用的一种动态路由协议,基于链路状态算法,考虑了链路的带宽、延迟等因素来选择最佳路径。

- RIP(Routing Information Protocol,路由信息协议):一种内部网关协议(Interior Gateway Protocol,IGP),也是一种动态路由协议,基于距离向量算法,使用固定的跳数作为度量标准,选择跳数最少的路径作为最佳路径。

- BGP(Border Gateway Protocol,边界网关协议):一种用来在路由选择域之间交换网络层可达性信息(Network Layer Reachability Information,NLRI)的路由选择协议,具有高度的灵活性和可扩展性。

TCP 与 UDP 的区别

- 是否面向连接:UDP 在传送数据之前不需要先建立连接。而 TCP 提供面向连接的服务,在传送数据之前必须先建立连接,数据传送结束后要释放连接。

- 是否是可靠传输:远地主机在收到 UDP 报文后,不需要给出任何确认,并且不保证数据不丢失,不保证是否顺序到达。TCP 提供可靠的传输服务,TCP 在传递数据之前,会有三次握手来建立连接,而且在数据传递时,有确认、窗口、重传、拥塞控制机制。通过 TCP 连接传输的数据,无差错、不丢失、不重复、并且按序到达。

- 是否有状态:这个和上面的“是否可靠传输”相对应。TCP 传输是有状态的,这个有状态说的是 TCP 会去记录自己发送消息的状态比如消息是否发送了、是否被接收了等等。为此 ,TCP 需要维持复杂的连接状态表。而 UDP 是无状态服务,简单来说就是不管发出去之后的事情了(这很渣男!)。

- 传输效率:由于使用 TCP 进行传输的时候多了连接、确认、重传等机制,所以 TCP 的传输效率要比 UDP 低很多。

- 传输形式:TCP 是面向字节流的,UDP 是面向报文的。

- 首部开销:TCP 首部开销(20 ~ 60 字节)比 UDP 首部开销(8 字节)要大。

- 是否提供广播或多播服务:TCP 只支持点对点通信,UDP 支持一对一、一对多、多对一、多对多;

- ……

我把上面总结的内容通过表格形式展示出来了!确定不点个赞嘛?

| TCP | UDP | |

|---|---|---|

| 是否面向连接 | 是 | 否 |

| 是否可靠 | 是 | 否 |

| 是否有状态 | 是 | 否 |

| 传输效率 | 较慢 | 较快 |

| 传输形式 | 字节流 | 数据报文段 |

| 首部开销 | 20 ~ 60 bytes | 8 bytes |

| 是否提供广播或多播服务 | 否 | 是 |

TCP 和 UDP 的选择

- UDP 一般用于即时通信,比如:语音、 视频、直播等等。这些场景对传输数据的准确性要求不是特别高,比如你看视频即使少个一两帧,实际给人的感觉区别也不大。

- TCP 用于对传输准确性要求特别高的场景,比如文件传输、发送和接收邮件、远程登录等等。

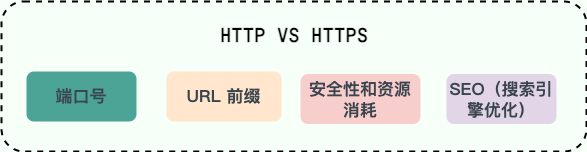

HTTP 和 HTTPS 的区别

- 端口号:HTTP 默认是 80,HTTPS 默认是 443。

- URL 前缀:HTTP 的 URL 前缀是

http://,HTTPS 的 URL 前缀是https://。 - 安全性和资源消耗:HTTP 协议运行在 TCP 之上,所有传输的内容都是明文,客户端和服务器端都无法验证对方的身份。HTTPS 是运行在 SSL/TLS 之上的 HTTP 协议,SSL/TLS 运行在 TCP 之上。所有传输的内容都经过加密,加密采用对称加密,但对称加密的密钥用服务器方的证书进行了非对称加密。所以说,HTTP 安全性没有 HTTPS 高,但是 HTTPS 比 HTTP 耗费更多服务器资源。

- SEO(搜索引擎优化):搜索引擎通常会更青睐使用 HTTPS 协议的网站,因为 HTTPS 能够提供更高的安全性和用户隐私保护。使用 HTTPS 协议的网站在搜索结果中可能会被优先显示,从而对 SEO 产生影响。

URI 和 URL 的区别

- URI(Uniform Resource Identifier) 是统一资源标志符,可以唯一标识一个资源。

- URL(Uniform Resource Locator) 是统一资源定位符,可以提供该资源的路径。它是一种具体的 URI,即 URL 可以用来标识一个资源,而且还指明了如何 locate 这个资源。

URI 的作用像身份证号一样,URL 的作用更像家庭住址一样。URL 是一种具体的 URI,它不仅唯一标识资源,而且还提供了定位该资源的信息。

什么是 WebSocket?

WebSocket 是一种基于 TCP 连接的全双工通信协议,即客户端和服务器可以同时发送和接收数据。

WebSocket 协议在 2008 年诞生,2011 年成为国际标准,几乎所有主流较新版本的浏览器都支持该协议。不过,WebSocket 不只能在基于浏览器的应用程序中使用,很多编程语言、框架和服务器都提供了 WebSocket 支持。

WebSocket 协议本质上是应用层的协议,用于弥补 HTTP 协议在持久通信能力上的不足。客户端和服务器仅需一次握手,两者之间就直接可以创建持久性的连接,并进行双向数据传输。

WebSocket 和 HTTP 的区别

WebSocket 和 HTTP 两者都是基于 TCP 的应用层协议,都可以在网络中传输数据。

下面是二者的主要区别:

- WebSocket 是一种双向实时通信协议,而 HTTP 是一种单向通信协议。并且,HTTP 协议下的通信只能由客户端发起,服务器无法主动通知客户端。

- WebSocket 使用 ws:// 或 wss://(使用 SSL/TLS 加密后的协议,类似于 HTTP 和 HTTPS 的关系) 作为协议前缀,HTTP 使用 http:// 或 https:// 作为协议前缀。

- WebSocket 可以支持扩展,用户可以扩展协议,实现部分自定义的子协议,如支持压缩、加密等。

- WebSocket 通信数据格式比较轻量,用于协议控制的数据包头部相对较小,网络开销小,而 HTTP 通信每次都要携带完整的头部,网络开销较大(HTTP/2.0 使用二进制帧进行数据传输,还支持头部压缩,减少了网络开销)。

TCP/IP 协议

常见的 HTTP 状态码

信息响应类(1xx):请求已被接受,需要客户端继续操作。

重定向类(3xx):需要客户端采取进一步的动作来完成请求。

成功类(2xx):请求已经被成功处理。

- 200 OK:请求已成功,返回请求的数据。

- 204 无内容:服务器成功处理了请求,但没有返回任何内容。

客户端错误类(4xx):请求包含语法错误或无法完成请求。

- 400 错误请求:服务器不能理解请求报文。

- 401 未授权:请求要求用户的身份认证。

- 403 禁止:服务器理解请求客户端的请求,但是拒绝执行此请求。

服务器错误类(5xx):服务器发生错误,无法完成请求。

- 500 内部服务器错误:服务器遇到未知错误。

- 501 未实现:服务器不支持请求的功能。

- 502 坏网关:作为网关或代理工作的服务器从上游服务器收到了无效响应。

- 503 服务不可用:服务器暂时过载或维护。

- 504 网关超时:作为网关或代理工作的服务器没有及时从上游服务器收到请求。

- 505 HTTP 版本不受支持:服务器不支持请求中所用的 HTTP 协议版本。

三次握手的过程

- SYN(同步序列编号,Synchronize):

- 客户端发送一个 SYN 包给服务器端,表示请求建立连接。这个包中包含了一个初始化的序号(Sequence Number),用于后续的数据传输。

- SYN-ACK(同步-确认,Synchronize-Acknowledge):

- 服务器端接收到 SYN 包之后,会发送一个 SYN-ACK 包作为应答。这个包中包含了一个自己的初始化序号,并且还包含了一个确认序号(Acknowledgment Number),这个确认序号是对客户端发出的 SYN 包的序号加一的确认。

- ACK(确认,Acknowledge):

- 客户端接收到服务器的 SYN-ACK 包后,会发送一个 ACK 包作为确认,这个包仅仅包含确认序号,确认序号是对服务器发出的 SYN-ACK 包的序号加一的确认。这样就完成了三次握手的过程,连接建立完成。

1 | Client Server |

四次挥手的过程

- FIN(结束标志,Finish):

- 假设客户端想要关闭连接,它会发送一个 FIN 段到服务器,这个 FIN 段表明客户端已经没有更多的数据要发送了。该 FIN 段包含客户端的序列号 Seq = X。

- ACK(确认标志,Acknowledge):

- 服务器接收到客户端的 FIN 段后,会发送一个 ACK 段作为响应。这个 ACK 段确认了它已经收到了客户端的 FIN 段,并且确认了客户端的序列号 Seq = X + 1。此时,服务器可能仍然有未发送完的数据,所以这个 ACK 段可能还包含了一些待发送的数据。该 ACK 段包含服务器的序列号 Seq = Y 和确认号 Ack = X + 1。

- FIN(结束标志,Finish):

- 当服务器完成了所有数据的发送后,它也会发送一个 FIN 段到客户端,表明服务器也没有更多的数据要发送了。这个 FIN 段包含服务器的序列号 Seq = Z。

- ACK(确认标志,Acknowledge):

- 客户端接收到服务器的 FIN 段后,同样发送一个 ACK 段作为确认,表明它已经收到了服务器的 FIN 段,并且确认了服务器的序列号 Seq = Z + 1。此时,连接就可以正式关闭了。

1 | Client Server |

断开连接

在标准的TCP/IP协议栈中,终止一个TCP连接主要是通过四次挥手来完成的。然而,在某些特殊情况下,还有其他的机制可以导致TCP连接的中断:

- RST(复位)包:发送一个带有RST标志的TCP段可以立即终止一个TCP连接。这种方式通常用于异常情况,如主机崩溃后重启或检测到恶意流量时。使用RST包断开会丢失未确认的数据,并且不会等待已发送的数据被接收。

- 超时:如果一段长时间内没有任何数据传输活动,TCP连接可能会因为超时而自动关闭。这种机制是为了防止死链的存在。

- 操作系统强制关闭:在某些情况下,操作系统可以直接关闭TCP连接,例如当系统检测到连接的一端已经不可达时。

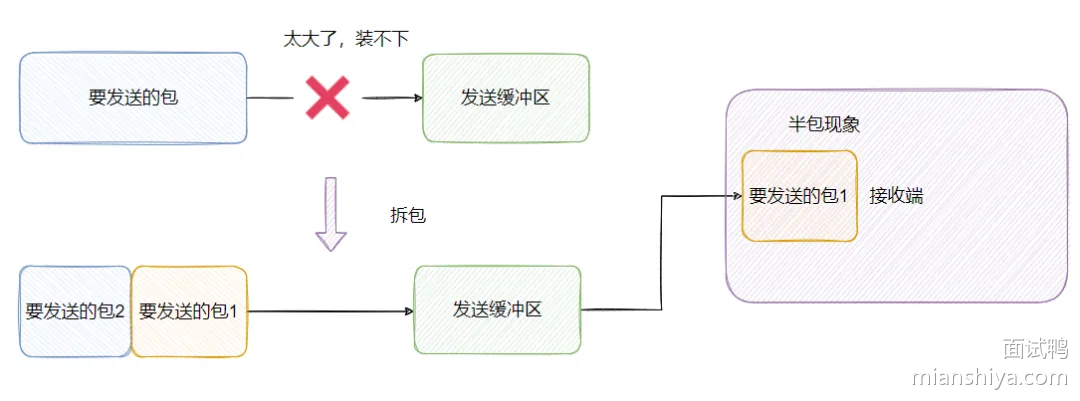

粘包、拆包

粘包(Packet Clumping):指的是多个数据包在TCP层被合并成一个大的数据包进行发送,导致接收方无法区分这些数据包的边界。这通常发生在TCP的拥塞控制算法工作时,或者当发送方连续发送小的数据包而接收方在一个接收缓冲区中接收到的数据量超过了单个数据包的大小时。

发生原因:

- 发送方连续发送多个小的数据段,但接收方一次只收到了一个数据段。

- 这些数据段在TCP层被合并成了一个较大的数据段进行传输。

解决方案:

- 在发送数据时添加定长的包头。

- 使用特殊的分隔符来标识每个消息的边界。

- 使用固定长度的消息格式。

拆包(Packet Fragmentation):指的是一个较大的数据包在传输过程中被分割成几个更小的数据包进行发送,导致接收方接收到多个数据段,这些数据段原本属于同一个消息。

发生原因:

- 当一个数据包的大小超过了一定限制(如MTU,最大传输单元),路由器或网络设备可能会将其分割成几个较小的数据包进行传输。

- 接收方会收到这些被分割的数据包,并需要重组它们以恢复原始的消息。

解决方案:

- 通常情况下,TCP协议本身会处理这些被分割的数据包的重组,不需要应用层做额外的工作。

- 如果频繁出现拆包问题,可以考虑调整发送的数据包大小,使其不超过网络的最大传输单元(MTU)。

滑动窗口

主要作用:

- 流量控制:滑动窗口使得接收方可以控制发送方发送数据的速度,从而避免因发送速度过快而导致接收方无法及时处理数据。

- 提高带宽利用率:通过动态调整窗口大小,可以根据网络状况和接收方的能力最大化带宽的使用效率。

- 减少数据重传:通过有效的流量控制,减少因接收方缓冲区满而造成的丢包,从而减少不必要的数据重传。

- 改善延迟和吞吐量:滑动窗口机制有助于平衡延迟和吞吐量之间的关系,使得在网络条件变化时仍能保持较好的性能。

工作原理:

滑动窗口的核心思想是维护一个滑动的窗口范围,发送方和接收方通过TCP报文中的序号和确认号来协商这个窗口的大小和位置。

- 窗口大小:TCP头部中的“窗口大小”字段指明了接收方希望接收的数据量,即接收方缓冲区还能接受多少字节的数据。

- 序号和确认号:TCP报文中的序号用来标识数据的第一个字节的编号,而确认号则是指接收方期望接收的下一个字节的序号。

- 发送方的行为:发送方根据接收方提供的窗口大小发送数据,并且不能超出这个窗口的范围。一旦发送的数据达到了窗口的上限,发送方就需要等待接收方的确认或窗口更新后再继续发送。

- 接收方的行为:接收方接收到数据后,会根据接收到的数据量更新窗口大小,并通过ACK(确认)报文告诉发送方最新的窗口大小。

拥塞控制的步骤

TCP拥塞控制是为了防止过多的数据注入到网络中,从而引起网络拥塞的一种机制。TCP拥塞控制主要包括以下几个步骤或阶段:

1)慢启动(Slow Start)

慢启动阶段的目标是迅速增大拥塞窗口(Congestion Window, cwnd),同时避免过多地增加网络负载。在这个阶段,发送方会逐步增加发送的分组数量,直到达到某个阈值(ssthresh,slow start threshold)。

- 初始状态:当一个新的TCP连接建立时,或者网络中发生严重拥塞后重新开始传输时,cwnd通常被初始化为一个MSS(最大段大小)。

- 指数增长:每经过一个往返时间(Round Trip Time, RTT),cwnd就会翻倍。也就是说,发送方每次接收到一个ACK都会增加一个MSS的发送量。

2)拥塞避免(Congestion Avoidance)

当cwnd达到ssthresh时,进入拥塞避免阶段。这个阶段的目的是更加平缓地增加cwnd,以避免网络拥塞。

- 线性增长:每经过一个RTT,cwnd增加一个MSS的大小。也就是说,发送方每次接收到一个ACK时,并不会像慢启动那样翻倍增加,而是按部就班地增加。

- 目标:逐步增大cwnd,同时监控网络状况,避免拥塞。

3)快重传(Fast Retransmit)

快重传是一种加速重传丢失分组的机制。它允许发送方在没有等到重传计时器到期的情况下就重传丢失的数据。

- 触发条件:当发送方收到三个重复的ACK(意味着接收方已经接收到后面的分组,但中间的一个或几个分组丢失了),它就会立即重传丢失的分组,而不是等待计时器超时。

- 结果:这可以更快地恢复丢失的数据,减少传输延迟。

4)快恢复(Fast Recovery)

快恢复是在快重传之后的一个阶段,其目的是快速恢复到正常传输状态。

- 降低阈值:当快重传触发时,ssthresh会被减半(通常是设置为当前cwnd的一半),然后cwnd设置为ssthresh。

- 试探性增长:随后,发送方试探性地增大cwnd。每收到一个丢失分组的ACK,cwnd增加一个MSS。如果接收到足够多的ACK,则认为网络状况良好,可以回到拥塞避免阶段。

Token、Session、Cookie

都用于维护客户端和服务器之间用户认证和会话管理,其区别如下:

Cookie

| 优点 | 缺点 |

|---|---|

| 简单易实现:存储在客户端(静态文件、数据库查询结果) | 安全风险:有被串改风险 |

| 本地缓存:读取速度快,不占用服务器存储 | 容量限制:4KB |

| 可用限制:用户可能禁用 |

Session

| 优点 | 缺点 |

|---|---|

| 安全性高:存储在服务器端,不容易被恶意篡改和伪造 | 占用服务器资源 |

| 容量大:可以保存对象、大量的数据 | 扩展性差(分布式集群) |

| 依然需要依赖cookie跨域限制 |

Session怎么提高效率?

Session持久化:将session信息存储在持久化存储中,如数据库、文件系统或NoSQL存储中,这样可以避免将所有session信息存储在内存中,从而减少内存的使用量。

Session复制:将session信息从一台服务器复制到另一台服务器上,这样可以实现负载均衡,并将会话信息在多个服务器之间共享。

Session失效策略:设置合理的session失效策略,例如根据用户活动时间、最大不活动时间等来决定session的失效时间,可以减少无用的session信息。

集群:使用集群环境来分散请求和负载,这样可以使应用程序在多个服务器上运行,从而提高应用程序的性能和可扩展性。

总之,为了提高会话管理的效率,需要使用合理的持久化和集群技术,并设置合理的会话失效策略,以避免会话信息的无限增长。

Token

| 优点 | 缺点 |

|---|---|

| 无状态性:服务器无需存储,提升可扩展性和性能 | 存储安全:客户端丢失或泄露Token可能导致安全问题 |

| 安全性:通过签名保证数据的完整性和来源的可靠性 | 传输负载:Token较多信息,会增加HTTP请求的大小 |

| 自包含性:Token自身包含用户信息和过期时间等,减少对服务器的查询 |

JWT Token

JWT 的组成

JWT 由三部分组成,每一部分由点号(.)分隔:

- Header(头部)

- Payload(载荷)

- Signature(签名)

Header(头部):头部包含关于 JWT 的元数据,通常是一个 JSON 对象,编码为 Base64URL 字符串。头部包含的信息可能包括使用的签名算法(如 HMAC 使用 SHA-256 或 RSA 使用 SHA-256)以及令牌类型(通常是 “JWT”)。示例:

1 | { |

Payload(载荷):载荷是存储 JWT 数据的地方。这也是一个 JSON 对象,编码为 Base64URL 字符串。载荷包含了一系列声明(Claims),声明可以是标准的也可以是自定义的。一些常用的声明包括 iss(发行者)、exp(过期时间)、sub(主题)等。例如:

1 | { |

Signature(签名):签名部分是用来验证 JWT 的发送方确实是谁他们声称是的人,并且确保载荷没有被篡改。为了创建签名,需要使用 Header 中指定的算法(如 HMAC 使用 SHA-256)对 Header 和 Payload 进行加密,并加上一个密钥(Secret)。密钥通常是只有发行者和接收者知道的秘密。接收方通过使用相同的密钥和算法解密签名,来验证令牌的真实性。示例签名:

1 | eyJhbGciOiJIUzI1NiIsInR5cCI6IkpXVCJ9.eyJzdWIiOiIxMjM0NTY3ODkwIiwibmFtZSI6IkpvaG4gRG9lIiwiaWF0IjoxNTE2MjM5MDIyfQ.SflKxwRJSMeKKF2QT4fwpMeJf36POk6yJV_adQssw5c |

JWT 的优点

- 无状态:JWT 是自包含的,因此不需要在服务器上保存会话状态,这使得 JWT 成为构建无状态、可扩展的应用程序的理想选择。

- 易于跨域使用:由于 JWT 可以通过 HTTP header 或者 POST 参数携带,所以非常适合跨域资源共享(CORS)。

- 轻量级:JWT 是紧凑的,可以减少网络传输的开销。

JWT 的局限性

- 过期管理:JWT 一旦签发,就不能撤销。如果令牌被盗或滥用,唯一的办法是让它过期或者在服务器端维护一个黑名单列表。

- 安全性依赖于密钥管理:JWT 的安全性依赖于密钥的安全性。如果密钥泄露,任何人都可以伪造 JWT。

JWT 的使用场景

JWT 通常用于身份验证和授权。在用户登录成功后,服务器会生成一个 JWT 并返回给客户端。客户端在后续的请求中将 JWT 放入 HTTP header(通常是 Authorization 头),这样服务器就可以验证用户的权限。

总的来说,JWT 是一种强大的工具,可以帮助开发者构建安全、高效的应用程序,特别是在微服务架构和分布式系统中。然而,使用 JWT 也需要谨慎处理安全性和过期管理等问题。

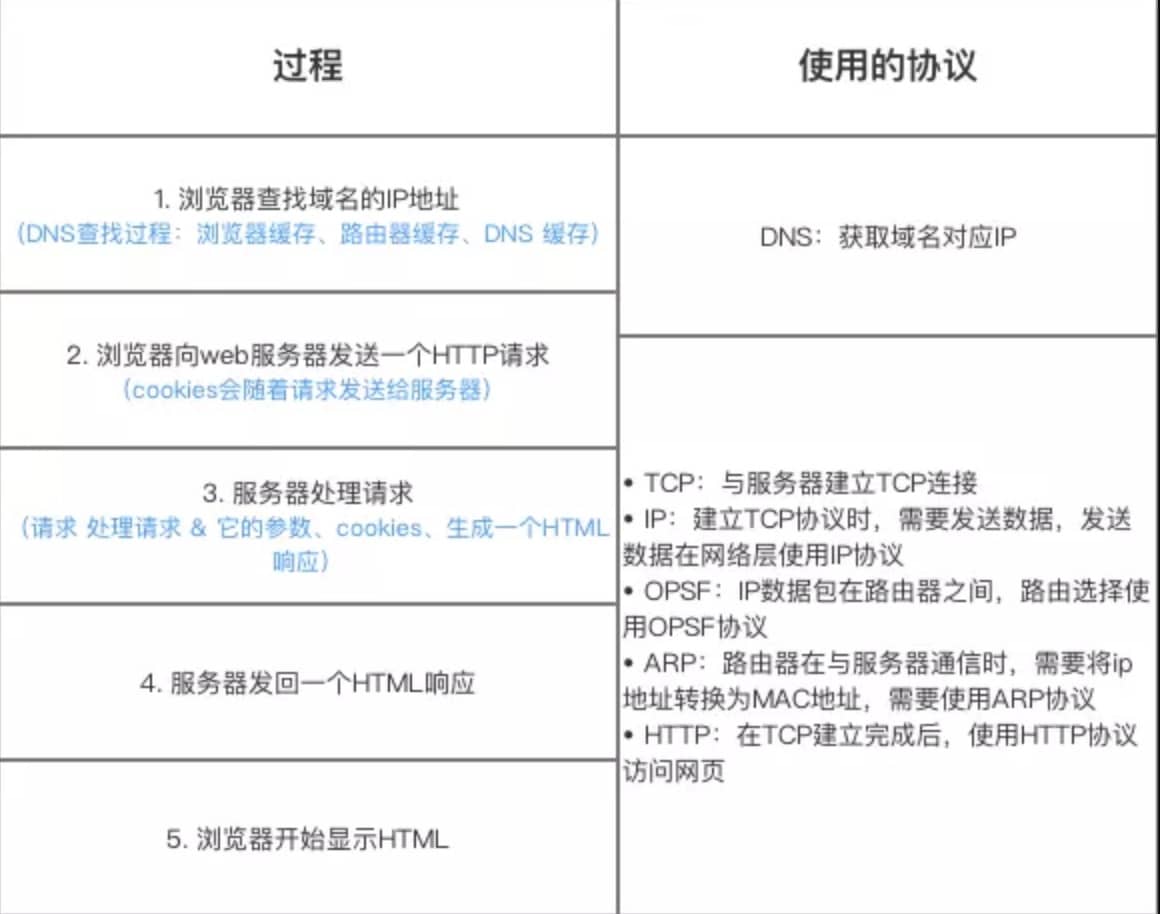

从输入 URL 到页面展示到底发生了什么?

总体来说分为以下几个步骤:

- 用户输入网址:在浏览器中输入指定网页的 URL。

- DNS 解析:浏览器通过 DNS 协议,获取域名对应的 IP 地址。

- 建立 TCP 连接:浏览器根据 IP 地址和端口号,向目标服务器发起一个 TCP 连接请求。

- 建立 SSL/TLS 加密连接:如果网站使用 HTTPS 协议,那么双方要交换密钥,建立会话密钥,使用密钥进行加密通信。

- 发送 HTTP 请求:浏览器在 TCP 连接上,向服务器发送一个 HTTP 请求报文,请求获取网页的内容。

- 服务器处理请求并响应:服务器收到 HTTP 请求报文后,处理请求,并返回 HTTP 响应报文给浏览器。

- 浏览器解析响应:浏览器收到 HTTP 响应报文后,解析响应体中的 HTML 代码,渲染网页的结构和样式,同时根据 HTML 中的其他资源的 URL(如图片、CSS、JS 等),再次发起 HTTP 请求,获取这些资源的内容,直到网页完全加载显示。

- 中断连接:浏览器在不需要和服务器通信时,可以主动关闭 TCP 连接,或者等待服务器的关闭请求。

HTTP 协议中 GET 和 POST 的区别

- GET:请求参数在 URL 中,用于获取数据。

- POST:请求参数在请求体中,用于修改数据。

—————————————

设计模式

为什么要用设计模式?

设计模式是一套被预先定义好的解决方案,用于解决软件设计中常见问题,以提高代码的可重用性、可读性和可维护性。

使用设计模式的原因是为了使软件设计更加规范、模块化,从而提升代码的质量,使得软件更容易理解、维护和扩展。

设计模式分类

23种设计模式通常分为三大类,分别是:

- 创建型模式(Creational Patterns)

- 结构型模式(Structural Patterns)

- 行为型模式(Behavioral Patterns)

创建型模式(Creational Patterns)

创建型模式关注对象的创建机制,将对象的创建与使用分离开来,以便让系统更加灵活地决定创建哪个对象。创建型模式可以将对象创建的责任封装起来,从而使系统更加独立于具体的对象创建、组合和表示。

创建型模式包括但不限于:

- 单例模式(Singleton):确保一个类只有一个实例,并提供一个访问它的全局访问点。

- 工厂方法模式(Factory Method):定义一个创建产品对象的接口,让子类决定实例化哪一个类。

- 抽象工厂模式(Abstract Factory):提供一个创建一系列相关或依赖对象的接口,而无需指定它们具体的类。

- 建造者模式(Builder):将一个复杂对象的构建与其表示相分离,使得同样的构建过程可以创建不同的表示。

- 原型模式(Prototype):用原型实例指定创建对象的种类,并通过复制这些原型创建新的对象。

结构型模式(Structural Patterns)

结构型模式关注如何组合类或对象来形成更大的结构。这些模式可以让你的代码更加灵活地组合对象,以便创建出更加复杂的结构。

结构型模式包括但不限于:

- 适配器模式(Adapter):将一个类的接口转换成客户希望的另外一个接口。

- 装饰器模式(Decorator):动态地给一个对象添加一些额外的职责。

- 代理模式(Proxy):为其他对象提供一种代理以控制对这个对象的访问。

- 外观模式(Facade):为子系统中的一组接口提供一个一致的界面。

- 桥接模式(Bridge):将抽象部分与它的实现部分分离,使它们都可以独立地变化。

- 组合模式(Composite):将对象组合成树形结构以表示“部分-整体”的层次结构。

- 享元模式(Flyweight):运用共享技术有效地支持大量细粒度的对象。

行为型模式(Behavioral Patterns)

行为型模式关注对象之间的通信以及职责分配机制。它们描述了对象之间应该如何相互作用以及如何分配职责。

行为型模式包括但不限于:

- 策略模式(Strategy):定义一系列的算法,把它们一个个封装起来,并且使它们可相互替换。

- 模板方法模式(Template Method):定义一个操作中的算法骨架,而将一些步骤延迟到子类中。

- 观察者模式(Observer):定义对象间的一种一对多的依赖关系,当一个对象的状态发生改变时,所有依赖于它的对象都得到通知并被自动更新。

- 迭代器模式(Iterator):提供一种方法访问一个容器对象中各个元素,而又不需暴露该对象的内部细节。

- 责任链模式(Chain of Responsibility):使多个对象都有机会处理请求,从而避免请求的发送者和接收者之间的耦合关系。

- 命令模式(Command):将一个请求封装为一个对象,从而使你可用不同的请求来参数化客户端。

- 备忘录模式(Memento):在不破坏封装性的前提下,捕获一个对象的内部状态,并在该对象之外保存这个状态。

- 状态模式(State):允许一个对象在其内部状态改变时改变它的行为。

- 访问者模式(Visitor):表示一个作用于某对象结构中的各元素的操作。

- 中介者模式(Mediator):用一个中介对象来封装一系列的对象交互。

- 解释器模式(Interpreter):给定一个语言,定义它的文法的一种表示,并定义一个解释器,这个解释器使用该表示来解释语言中的句子。

单例模式

分类:

- 饿汉式单例模式

- 懒汉式单例模式

- 线程安全的懒汉式单例模式

单例模式(Singleton Pattern) 是最简单的创建型设计模式。它的目的是确保一个类只有一个实例存在,并且提供一个全局访问点。

单例模式最重要的特点 是构造函数私有,从而避免外界直接使用构造函数直接实例化该类的对象。

单例模式的优点:

- 在一个对象需要频繁地销毁、创建,而销毁、创建性能又无法优化时,单例模式的优势尤为明显。

- 在一个对象的产生需要较多资源时,如读取配置、产生其他依赖对象时,则可以通过在启动时直接产生一个单例对象,然后用永久驻留内存的方式来解决。

- 单例模式可以避免对资源的多重占用,因为只有一个实例,避免了对一个共享资源的并发操作。

- 单例模式可以在系统设置全局的访问点,优化和共享资源访问。

单例模式的缺点:

- 单例模式无法创建子类,扩展困难,若要扩展,除了修改代码基本上没有第二种途径可以实现。

- 单例模式对测试不利。在并行开发环境中,如果采用单例模式的类没有完成,是不能进行测试的。

- 单例模式与单一职责原则有冲突。一个类应该只实现一个逻辑,而不关心它是否是单例的,是不是要用单例模式取决于环境。

单例模式在 Java 中通常有两种表现形式:

饿汉式单例模式

- 类加载时就进行对象实例化。

1 | public class Singleton { |

懒汉式单例模式(线程安全)

- 第一次引用类时才进行对象实例化。

- 线程安全问题:如果线程 A 和 B 同时调用此方法,会出现执行

if (instance == null)语句时都为真的情况,导致创建两个对象。为解决这一问题,可以使用synchronized关键字对静态方法getInstance()进行同步。

1 | public class Singleton2 { |

比较:饿汉式单例类的速度和反应时间要优于懒汉式单例类,但资源利用率不如懒汉式单例类。

工厂模式

分类:

- 简单工厂模式

- 工厂方法模式

- 抽象工厂模式

工厂模式(Factory Pattern) 是一种创建型设计模式,其主要目的是封装对象创建的细节,使得创建过程更加灵活。工厂模式可以分为三种类型:简单工厂模式、工厂方法模式和抽象工厂模式。

简单工厂模式 实际上并不是严格意义上的设计模式,而是一种编程习惯。它通过定义一个工厂类来创建不同类型的对象,这些对象通常具有共同的父类或接口。

工厂方法模式 是简单工厂模式的进一步发展。在工厂方法模式中,我们不再提供一个统一的工厂类来创建所有的对象,而是针对不同的对象提供不同的工厂。每个对象都有一个与之对应的工厂,工厂方法模式让一个类的实例化延迟到其子类。

抽象工厂模式 是工厂方法模式的进一步深化。在这个模式中,工厂类不仅可以创建一个对象,而是可以创建一组相关或相互依赖的对象。这是与工厂方法模式最大的不同点。抽象工厂模式提供一个创建一系列相关或相互依赖对象的接口,而无需指定它们具体的类。

简单工厂模式

简单工厂模式并不严格属于设计模式,而更多是一种编程习惯。其特点是定义一个工厂类,根据传入的参数不同返回不同的实例。这些实例通常具有共同的父类或接口。

示例代码:

1 | public interface Shape { |

1 | public class CircleShape implements Shape { |

1 | public class RectShape implements Shape { |

1 | public class TriangleShape implements Shape { |

1 | public class ShapeFactory { |

工厂方法模式

工厂方法模式定义了一个创建产品对象的工厂接口,将实际创建工作推迟到子类中。它具有良好的封装性和扩展性,可以降低模块间的耦合度。

示例代码:

1 | public interface Car { |

1 | public interface CarFactory { |

1 | public class Audi implements Car { |

1 | public class Auto implements Car { |

1 | public class AudiFactory implements CarFactory { |

1 | public class AutoFactory implements CarFactory { |

1 | public class ClientDemo { |

抽象工厂模式

抽象工厂模式为创建一组相关或相互依赖的对象提供一个接口,而无需指定它们的具体类。它适用于需要一组对象共同完成某种功能的场景。

示例代码:

1 | interface OperationController { |

策略模式

策略模式(Strategy Pattern) 是一种行为设计模式,它使你能在运行时改变对象的行为。策略模式定义了一系列算法,并将每一个算法封装起来,使它们可以互相替换。

策略模式允许在运行时改变算法的行为。它定义了包含算法族的接口,并且将算法的责任委托给一个子类。

1 | // 定义策略类型枚举类 |

1 | // 定义策略接口 |

1 | // 策略实现类 A |

1 | // 配置类,注入Bean |

1 | // 使用策略模式 |

责任链模式

责任链模式(Chain of Responsibility Pattern)能够将请求沿着处理者的链进行发送。收到请求后,每个处理者均可对请求进行处理,或将其传递给链上的下一个处理者。

假设我们有一个系统,需要处理不同级别的日志消息(debug、info、warning、error)。

1 | // 抽象处理者类 |

模板方法模式

模板方法模式(Template Method Pattern)定义了一些基本步骤,并让子类实现某些步骤。它允许子类重写某些步骤而不改变整个算法。

假设我们需要设计一个游戏框架,其中包含一些固定的流程,但每个游戏的具体实现不同。

1 | abstract class Game { |

观察者模式

观察者模式(Observer Pattern)允许对象在状态发生变化时通知多个观察者对象,而无需使对象知道观察者是谁。

假设我们有一个天气预报系统,需要实时更新天气信息,并通知不同的观察者(如用户界面、天气API等)。

1 | interface Observer { |

适配器模式

适配器模式(Adapter Pattern) 是一种结构型设计模式,它能让不兼容的接口协同工作。适配器模式充当了两个不同接口之间的桥梁。

适配器模式让两个没有关联的接口能够一起工作。适配器通过包装一个类的方法来实现所需的目标接口。

1 | // 目标接口 |

装饰器模式

装饰器模式(Decorator Pattern) 是一种结构型设计模式,它允许向部分对象添加新的功能,同时不会影响其他对象的功能。装饰器模式可以动态地给一个对象添加一些额外的责任。

装饰器模式允许你给对象动态地添加职责,而无需修改对象本身的结构。它是继承关系的一个替代方案。

1 | // 组件接口 |

—————————————

Netty

网络通信的过程

服务端是怎么接收客户端的消息的?服务端是如何感知到数据的?

服务器使用非阻塞I/O(NIO)来接收客户端的消息。具体过程如下:

- 接收连接: 服务器通过

ServerSocketChannel监听特定端口,并接受来自客户端的连接请求,创建SocketChannel。 - 读取数据: 服务器在处理客户端连接时,会调用

SocketChannel.read()方法读取客户端发送的数据。此方法会将数据填充到一个ByteBuffer中。 - 感知数据到达: 服务器在循环中持续读取数据,直到没有更多数据可读。如果

read()方法返回的字节数大于0,说明有数据到达。 - 解析数据: 服务器在读取数据后,将数据进行解码。

- 循环处理: 服务器会继续循环,等待并处理后续消息,直到客户端关闭连接。

这种方式使得服务器能够有效地处理多个客户端的连接和消息,同时能够感知数据的到达。

常见的I/O 模型

- 阻塞I/O(Blocking I/O):每个I/O操作都需要等待,效率较低。

- 非阻塞I/O(Non-blocking I/O):调用I/O操作后立即返回,可以通过轮询来检查操作是否完成。

- 多路复用(Multiplexing I/O):使用

select、poll、epoll等机制,同时监视多个I/O操作,适合高并发场景。 - 异步I/O(Asynchronous I/O):操作完成时会通知应用程序,避免了轮询。

NIO和BIO的区别

NIO(New IO)和BIO(Blocking IO)是Java编程语言中用于处理输入输出(IO)操作的两种不同机制,它们之间存在一些显著的区别。

工作原理:

BIO:这是一种同步阻塞式IO。服务器实现模式为“一个连接一个线程”,即当客户端发送请求时,服务器端需要启动一个线程进行处理。如果连接不进行任何操作,会造成不必要的线程开销。虽然可以通过线程池机制改善这个问题,但在高并发环境下,BIO的性能可能会受到影响,因为每个连接都需要创建一个线程,而且线程切换开销较大。

NIO:这是一种同步非阻塞式IO。服务器实现模式为“一个请求一个线程”,即客户端发送的连接请求都会注册到多路复用器(采用事件驱动思想实现)上,多路复用器轮询I/O请求时才启动一个线程进行处理。NIO在处理IO操作时,会把资源先操作至内存缓冲区,然后询问是否IO操作就绪。如果就绪,则进行IO操作;否则,进行下一步操作,并不断轮询是否IO操作就绪。

资源利用:

- BIO:由于每个连接都需要创建一个线程,因此在高并发环境下可能会导致大量线程的创建和管理,这会增加系统开销。

- NIO:通过单线程处理多个通道(Channel)的方式,减少了线程的数量,从而降低了系统开销。此外,NIO使用缓冲区(Buffer)进行数据的读写,提高了IO的处理效率。

应用场景:

BIO:适合一些简单的、低频的、短连接的通信场景,例如HTTP请求。

NIO:适用于高并发、长连接、大量数据读写的场景,如文件传输、分布式计算等。

讲讲Java NIO

- 背景与目的

- NIO是为了弥补传统同步阻塞IO模型中的不足而设计的。它提供了更快的、基于块的数据处理方式。

- 核心概念

- Buffer(缓冲区):Buffer是NIO的核心组件之一,它是一个可以直接访问的数组,用于存储不同数据类型的数据。所有数据都会先经过Buffer来处理,无论是读取还是写入。

- Channel(通道):Channel是另一个关键组件,它允许数据从一个地方传输到另一个地方。与传统的流(Stream)不同,Channel是双向的,支持同时进行读写操作。

- Selector(选择器/多路复用器):Selector负责监听一个或多个Channel,并通知应用程序有关Channel的状态变化,如是否准备好进行读或写操作等。

- 工作流程

- 当应用程序需要读取数据时,数据首先被读取到Buffer中。

- 写入数据时,数据是从Buffer写入到Channel。

- Selector用于监控多个Channel的状态,并且当Channel准备好了相应的操作时,Selector会通知应用程序。

- 通过Selector返回的SelectionKey,可以获取就绪状态的Channel,并执行相应的IO操作。

- 优势

- NIO相比传统的IO模型更加高效,因为它允许单个线程管理多个Channel连接,从而提高了并发处理能力。

*讲讲Netty,它解决了什么问题?

- Netty是一个高性能、异步的事件驱动的网络应用框架,主要用于构建快速、可扩展的网络服务器和客户端。它简化了网络编程的复杂性,如处理TCP连接、数据传输、协议解析等,使开发者能够更专注于业务逻辑。

- Netty是一个高性能、异步事件驱动的网络应用程序框架,用于快速开发可靠的协议服务器和客户端。它基于Java NIO(非阻塞IO),提供了丰富的API来简化网络编程的复杂性。Netty可以用于开发多种协议的服务端和客户端,如HTTP、WebSocket、SMTP等,也可以用来开发自定义的二进制协议。

- Netty是一个基于NIO模型的高性能网络通信框架,它是对NIO网络通信的封装,我们可以利用这样一些封装好的api去快速开发一个网络程序。

- Netty在NIO的基础上做了很多优化,比如零拷贝机制、高性能无锁队列、内存池,因此性能比NIO更高。

- Netty可以支持多种的通信协议,例如:Http、WebSocket等,并且针对一些通信问题,Netty也内置了一些策略,例如拆包、粘包,所以在使用过程中会比较方便。

Netty 的应用场景

- 高性能网络服务器(如游戏服务器、即时通讯工具)

- 微服务架构中的服务通信

- WebSocket服务器

- 数据传输层(如RPC框架)

*为什么要使用Netty?Netty的特点

Netty相比与直接使用JDK自带的api更简单,因为它具有这样一些特点:

- 统一的api,支持多种传输类型、比如阻塞、非阻塞,以及epoll、poll等模型

- 可以使用非常少的代码去实现多线程Reactor模型,以及主从多线程Reactor模型

- 自带编解码器,解决了TCP粘包拆包的问题

- 自带各种通信协议

- 相比JDK自带的NIO,有更高的吞吐量、更低的延迟、更低的资源消耗、更低的内存复制

- 安全性较好,有完整的 SSL/TLS 的支持

- 经历了各种大的项目的考验,社区活跃度高,例如:Dubbo、Zookeeper、RocketMQ

*Netty可以做什么事情?

我们之所以要使用Netty,核心的点是要去解决服务器如何去承载更多的用户同时访问的问题,传统的BIO模型由于阻塞的特性使得在高并发的环境种很难去支持更高的吞吐量,尽管用NIO的多路复用模型可以在阻塞方面进行优化,但是它的api使用较为复杂,而Netty是基于NIO的封装,提供了成熟简单易用的api,降低了使用成本和学习成本,本质上来说Netty和NIO所扮演的角色是相同的,都是是去为了提升服务端的吞吐量,让用户获得更好的产品体验。

Netty的核心组件

Netty有三层结构构成的,分别是:

网络通信层,有三个核心组件:

Bootstrap负责客户端启动,并且去连接远程的Netty ServerServerBootStrap负责服务端的监听,用来监听指定的一个端口Channel负责网络通信的一个载体——事件调度器。

事件调度层,有两个核心角色:

EventLoopGroup本质上是一个线程池,主要去负责接收IO请求,并分发给对应的EventLoop去执行处理请求EventLoop是相对于线程池里面的一个具体线程

事件调度层的工作流程

- 初始化:在 Netty 应用启动时,首先创建

EventLoopGroup,然后根据需要创建EventLoop。 - 注册:当客户端或服务端建立连接时,会创建一个

Channel,并将该Channel注册到EventLoop上。 - 事件处理:一旦

Channel上有事件发生(如读写事件),相应的EventLoop就会被唤醒,并处理这些事件。 - 任务执行:除了处理 I/O 事件外,

EventLoop还可以执行用户提交的任务,如定时任务、异步任务等。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19EventLoopGroup bossGroup = new NioEventLoopGroup(); // (1) 负责接受传入的连接请求

EventLoopGroup workerGroup = new NioEventLoopGroup(); // (2) 负责处理已经被接受的连接上的 I/O 操作

try {

ServerBootstrap b = new ServerBootstrap();

b.group(bossGroup, workerGroup) // (3) 将 `bossGroup` 和 `workerGroup` 绑定到 `ServerBootstrap`

.channel(NioServerSocketChannel.class) // (4) 指定使用的 `Channel` 类型

.childHandler(new ChannelInitializer<SocketChannel>() { // (5) 设置一个 `ChannelInitializer`,用于初始化 `Channel` 的 `Pipeline`

public void initChannel(SocketChannel ch) throws Exception {

ch.pipeline().addLast(new EchoServerHandler());

}

});

ChannelFuture f = b.bind(port).sync(); // (6) 绑定并开始监听端口

f.channel().closeFuture().sync(); // (7) 等待 `ServerChannel` 关闭

} finally {

bossGroup.shutdownGracefully(); // (8) 关闭 `EventLoopGroup`,释放所有资源

workerGroup.shutdownGracefully(); // (9) 关闭 `EventLoop`,释放所有资源

}服务编排层,有三个核心组件:

ChannelPipeline负责处理多个ChannelHandler,他会把多个Channelhandler的过成一个链,去形成一个PipelineChannelHandler主要是针对10数据的一个处理器,数据接收后,就通过指定的一个上Handler进行处理ChannelHandlerContext是用来去保存ChannelHandler的一个上下文信息的。

Reactor 线程模型、其原理和作用

Reactor线程模型是基于事件驱动的模型,主要分为三个角色:

- Reactor:负责监视I/O事件并分发事件。

- Handler:处理具体的业务逻辑。

- Worker:执行I/O操作。可以使用多个Worker线程处理具体的请求,提高并发性能。

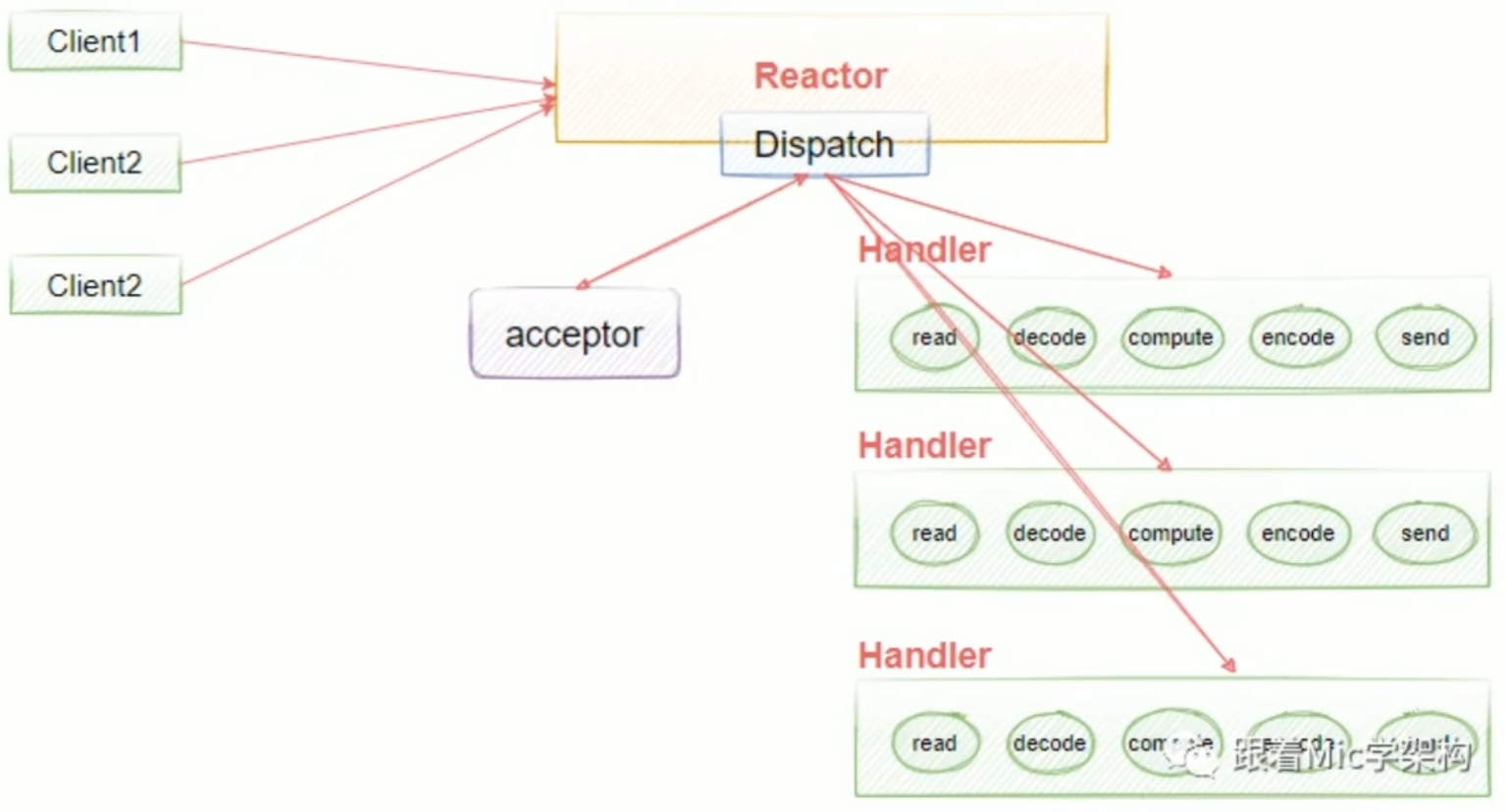

Netty提供了三种Reactor模型的支持:

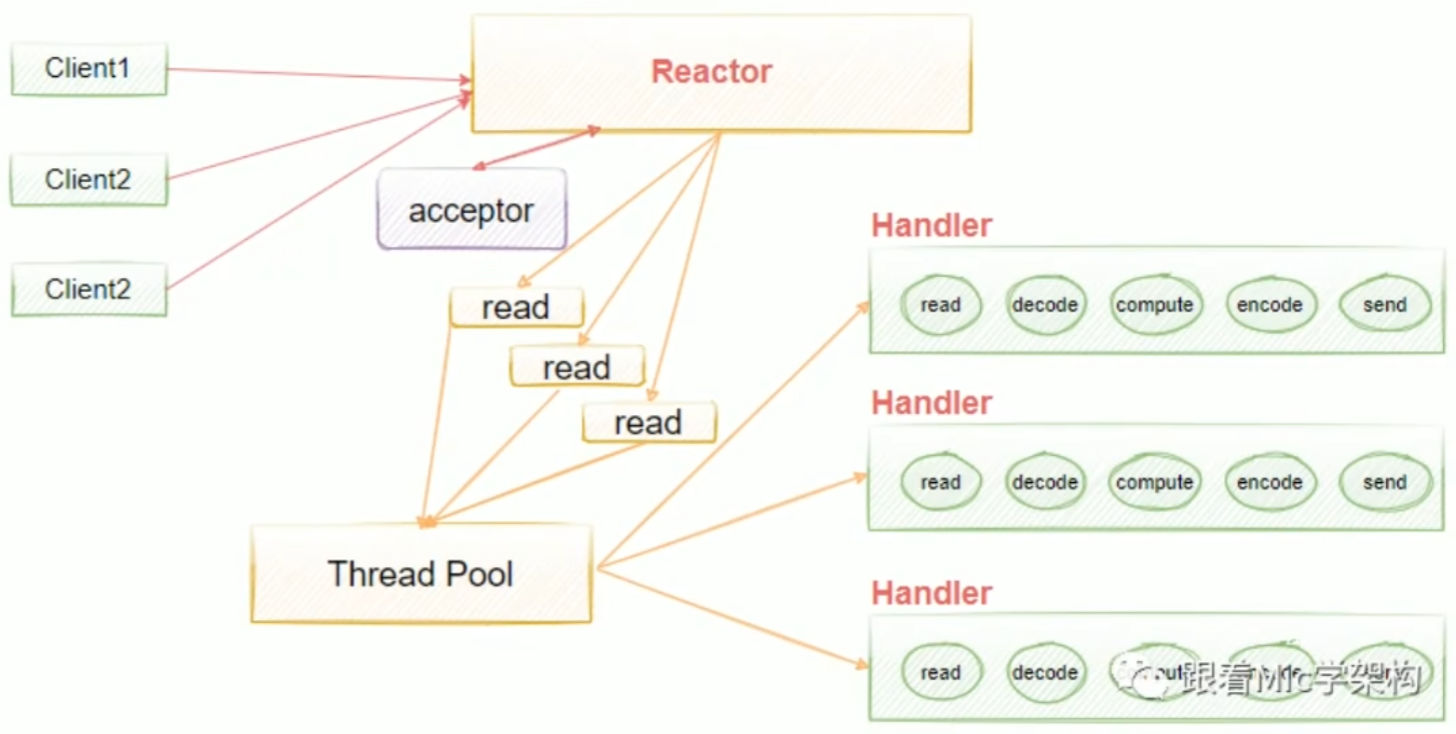

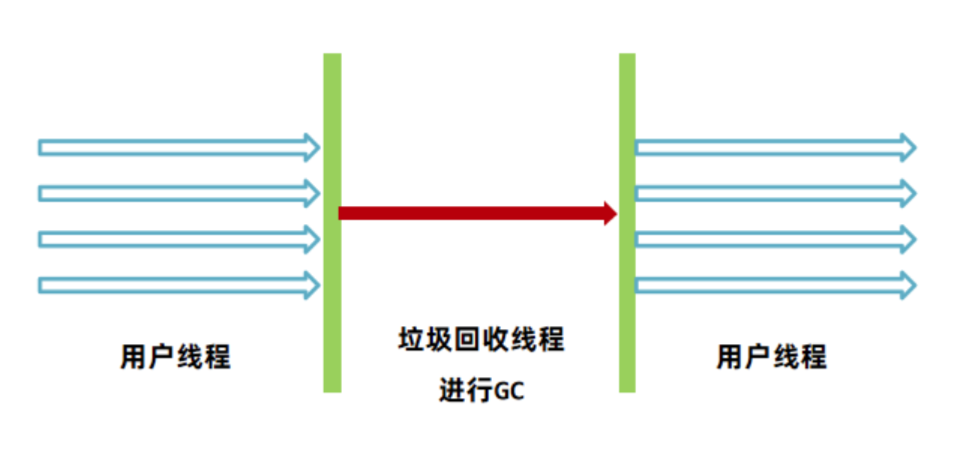

单线程单Reactor模型。单线程单Reactor模型也有缺点:如果其中一个Handler的出现阻塞,就会导致后续的客户端无法被处理,因为它们是同一个线程,所以就导致无法接受新的请求。为了解决这个问题,就提出了使用多线程的方式,也就是说在业务处理的时候加入线程池去异步处理,这样就可以解决handlers阻塞的一个问题。

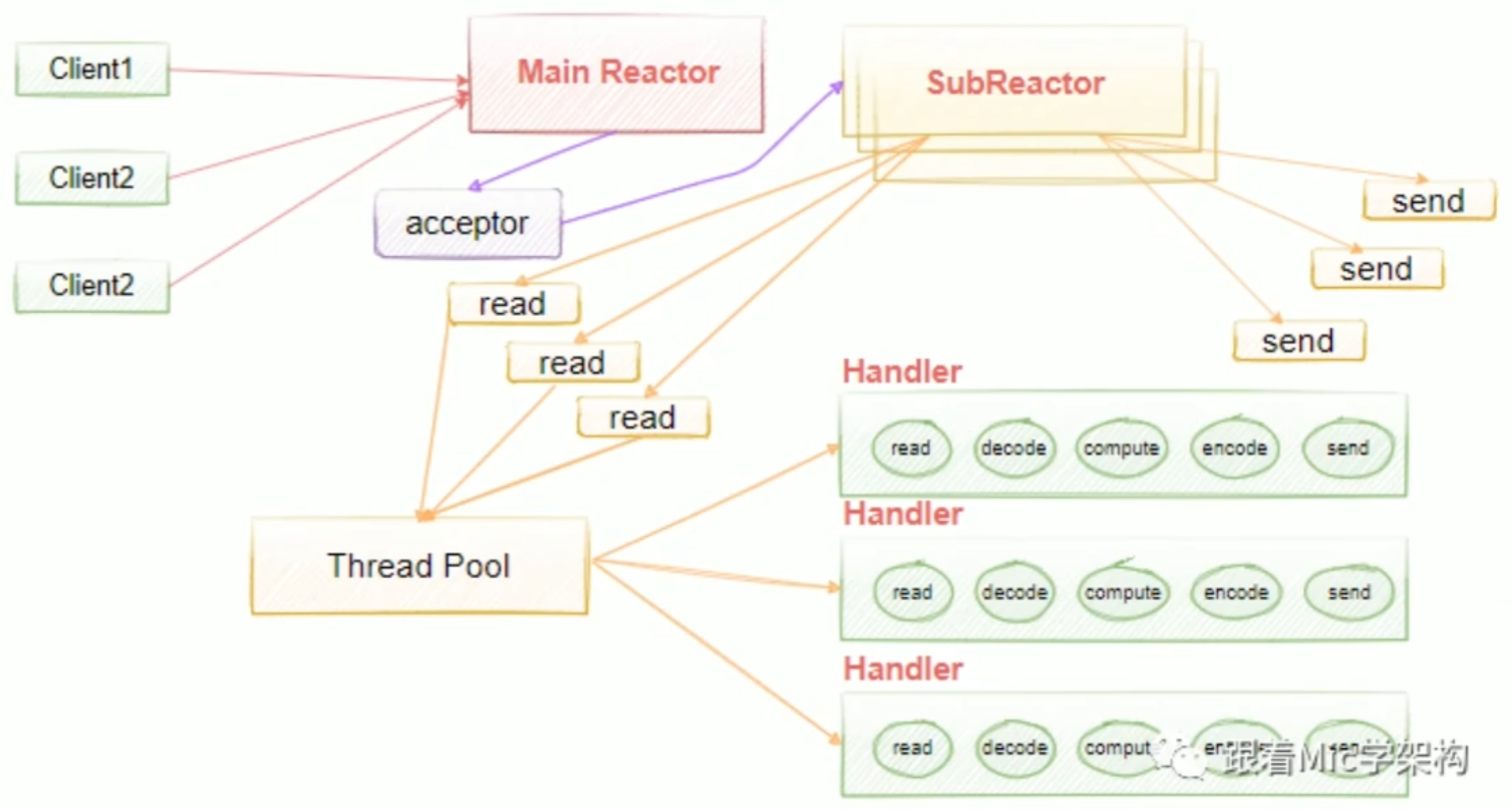

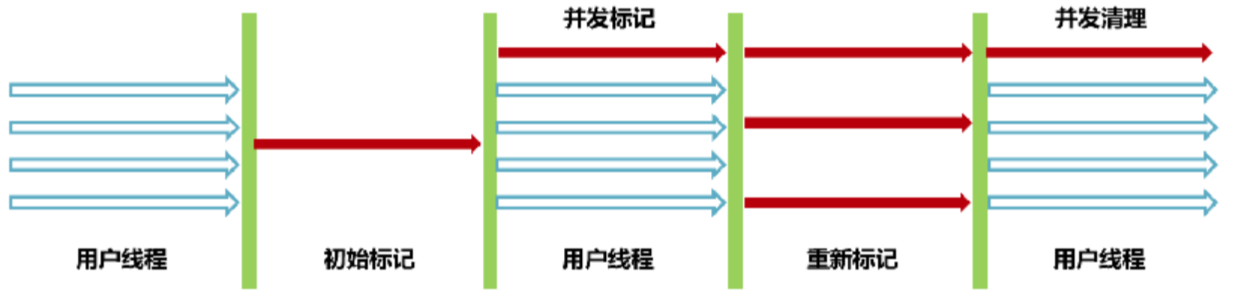

多线程单Reactor模型。为了解决单线程中handlers阻塞的问题,我们引入了线程池去异步处理,这意味着我们把Reactor和handlers放在不同的线程里面去处理。在多线程单Reactor模型中,所有的IO操作都是由一个Reactor来完成的,这导致单个Reactor会存在一个性能瓶颈,对于小容量的场景影响不是很大,但是对于高并发的一些场景来说,很容易会因为单个Reactor线程的性能瓶颈,导致整个吞吐量会受到影响,所以当这个线程超过负载之后,处理的速度变慢,就会导致大量的客户端连接超时,超时之后往往会进行重发,这反而加重了这个线程的一个负载,最终会导致大量的消息积压和处理的超时,成为整个系统的一个性能瓶颈,所以我们还可以进行进一步的优化,也就是引入多线程多Reactor模型。

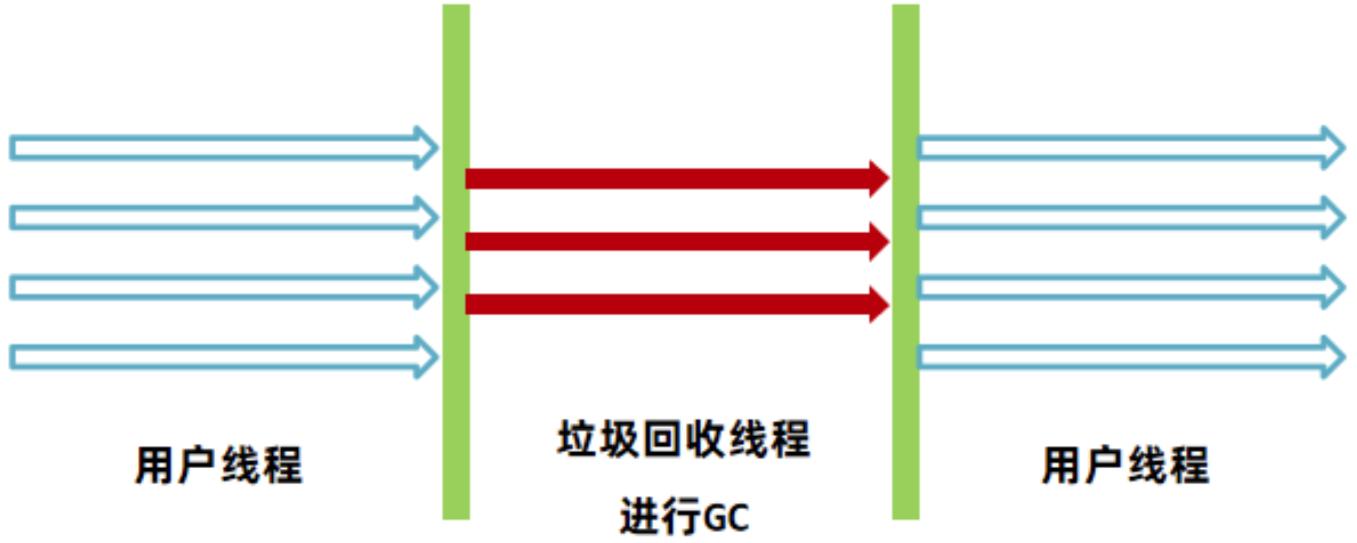

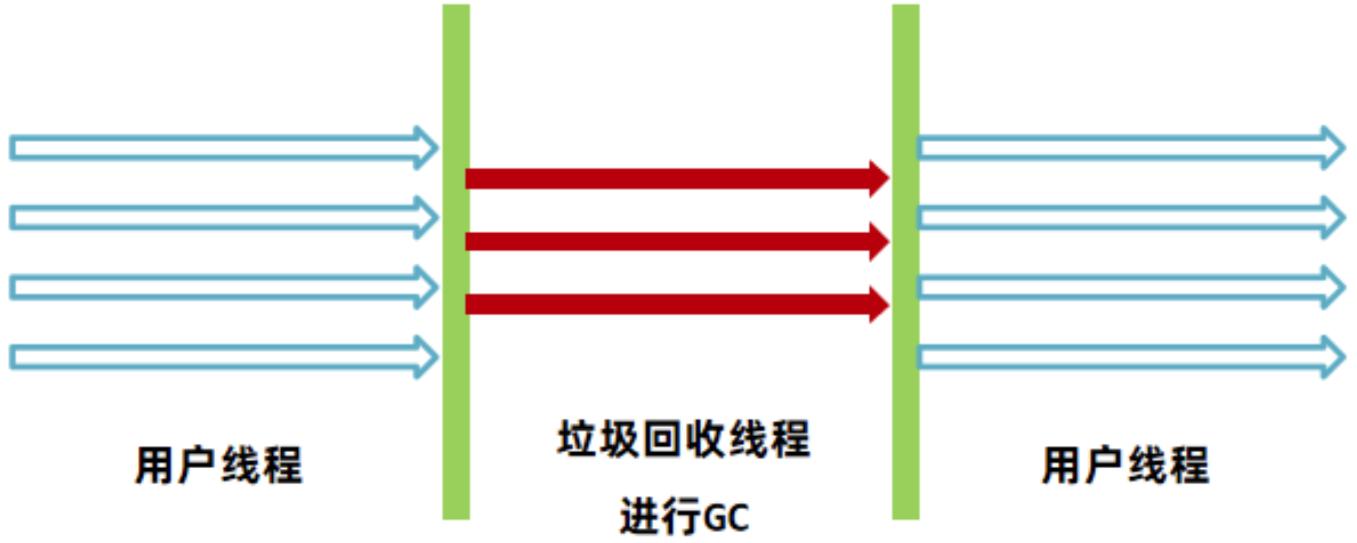

多线程多Reactor模型,也叫主从多线程Reactor模型。Main Reactor负责接收客户的连接请求,然后把接收的请求传递给Sub Reactor,Sub Reactorl我们可以配置多个,这样我们可以去进行灵活的扩容和缩容,具体的业务处理由Sub Reactor去完成,由它最终去绑定给对应的handler。Main Reactor扮演请求接收者,它会把接收的请求转发到Sub Reactor来处理,由Sub Reactor去进行真正意义上的分发。

Reactor模型有三个重要的组件:

Reactor负责将IO事件分派给对应的HandlerAcceptor处理客户端的连接请求handlers负责执行我们的业务逻辑的读写操作

高性能设计

- 非阻塞IO模型:Netty基于NIO实现,使用非阻塞IO模型,减少了线程的使用,从而减少了上下文切换的开销。

- 事件驱动:Netty采用了事件驱动的设计模式,当有IO事件发生时,才会被处理,这样可以有效地利用CPU资源。

- 零拷贝技术:Netty支持直接缓冲区(DirectByteBuffer),在数据传输中减少了数据的拷贝次数,提高了数据传输的效率。具体做法是:使用

FileChannel的transferTo()和transferFrom()等方法实现文件传输时,避免了将数据从用户空间复制到内核空间的过程,提高了性能。 - 线程模型:Netty提供了高效的线程模型,如Boss/Worker模型,使得任务的分配更加合理,充分利用多核CPU的计算能力。

Netty 中的设计模式

- 单例模式:如EventLoop。

- 观察者模式:事件的注册和触发。

- 责任链模式:通过ChannelPipeline处理多个ChannelHandler。

- 适配器模式:将不同的Handler统一处理。

处理粘包、拆包问题

在Netty中,粘包和拆包的问题通常通过消息编码器和解码器(如LengthFieldBasedFrameDecoder、DelimiterBasedFrameDecoder等)来解析数据流。

Netty提供了几种方式来处理这种情况:

- 定长消息:如果消息长度固定,可以直接读取固定长度的数据。

- 使用分隔符(Delimiters):对于文本协议,可以使用特定的分隔符(如’\n’)来分隔消息。

- 自定义协议头:在消息前加上长度字段,这样接收方可以根据长度字段读取完整的消息。

- 使用现成的编解码器:Netty提供了如LengthFieldBasedFrameDecoder这样的解码器,它可以根据消息长度字段自动处理粘包和拆包的问题。

异步非阻塞的IO操作

Netty通过使用Java NIO(非阻塞IO)技术实现了异步非阻塞的IO操作。具体来说:

- NIO:Netty基于Java NIO来实现非阻塞IO模型,使用

Selector来监听多个Channel的事件,当有事件发生时,Selector会通知相应的Channel进行处理。 - EventLoop:Netty中的

EventLoop是一个不断循环的线程,负责处理绑定在其上的Channel的所有IO操作。每个EventLoop都关联了一个Selector,用来监听Channel上的事件。 - Channel:每个

Channel都绑定了一个或多个ChannelHandler,用来处理读写事件。当有事件发生时,EventLoop会调用相应的ChannelHandler来处理事件。

示例代码如下:

1 | // 创建EventLoopGroup |

消息的有序发送

在Netty中实现消息的有序发送,可以通过以下几种方式:

- 单线程模型:如果业务逻辑要求消息必须按顺序发送,可以将所有消息的发送操作放在同一个线程中执行。这样可以保证消息的顺序性。

- ChannelPipeline:利用

ChannelPipeline中的ChannelHandler来控制消息的顺序。可以自定义ChannelHandler来实现消息的排队发送。 - ChannelFutureListener:使用

ChannelFutureListener来监听ChannelFuture的状态,确保前一个消息发送成功后再发送下一个消息。

示例代码如下:

1 | public class OrderedMessageHandler extends SimpleChannelInboundHandler<String> { |

异步任务的调度

Netty提供了ScheduledExecutorService来实现异步任务调度。ScheduledExecutorService可以用来安排定时任务,包括一次性任务和周期性任务。

示例代码如下:

1 | public class ScheduledTaskHandler extends SimpleChannelInboundHandler<String> { |

参考计数

Netty中的参考计数(Reference Counting)是Netty为了管理内存而采用的一种机制。它主要用于追踪ByteBuf的引用次数。每个ByteBuf都有一个内部的引用计数器,当ByteBuf被引用时,计数器加一;当引用被释放时,计数器减一。

当ByteBuf的引用计数降到0时,意味着没有引用再指向这个ByteBuf,此时Netty会自动释放这个ByteBuf所占的内存空间。这种方式可以防止内存泄漏,并且在多线程环境下确保内存的安全释放。

异常的处理方案

在Netty中,异常处理通常是通过ChannelFutureListener和ChannelInboundHandler来实现的。

- ChannelFutureListener:可以注册一个ChannelFutureListener来监听ChannelFuture的完成状态,当操作失败时,可以抛出异常或进行其他错误处理。

- ChannelInboundHandler:当ChannelPipeline中的某个Handler抛出异常时,可以通过实现ExceptionCaught()方法来捕获并处理这些异常。通常在这个方法中打印堆栈跟踪信息或采取其他补救措施。

此外,Netty还提供了全局异常处理机制,可以注册GlobalChannelInboundHandler来处理所有未捕获的异常。

Netty 如何解决 NIO 中的空轮询 Bug

Netty通过使用Selector的poll方法,并结合EventLoop进行优化,避免了空轮询的情况。它会在没有事件时进行适当的休眠,减少CPU资源的浪费。

Netty底层原理

Channel、ChannelHandlerContext

- Channel:表示一个连接,可以是服务器端或客户端的

SocketChannel,它负责数据的读写。 - ChannelHandlerContext:表示在ChannelPipeline中每个ChannelHandler的上下文,提供了访问Channel和其他Handler的功能,用于在Handler之间传递事件和数据。

ChannelPipeline是什么?它是如何工作的?

ChannelPipeline是Netty中的一个重要概念,它是一个责任链模式的具体实现。

在Netty中,每当有数据从网络到达或者需要发送数据时,数据会沿着ChannelPipeline中的处理器链进行传递。每个处理器(Handler)都可以对数据进行处理,比如编码、解码、日志记录等。ChannelPipeline使得我们可以方便地组织和管理这些处理器,按需插入、删除或替换处理器,从而实现了高度的灵活性。

ChannelPipeline是Netty中的一个责任链模式的实现,用于管理一系列的ChannelHandler。它的工作原理如下:

- 责任链:

ChannelPipeline中包含了一系列的ChannelHandler,这些ChannelHandler按照添加的顺序组成一个责任链。 - 消息传递:当有消息从网络到达或需要发送时,消息会沿着

ChannelPipeline中的ChannelHandler传递。 - 事件传播:除了消息外,

ChannelPipeline还可以传播各种事件,如连接建立、关闭等。 - 上下文管理:通过

ChannelHandlerContext来管理当前ChannelHandler的上下文信息。

示例代码如下:

1 | public class MyInitializer extends ChannelInitializer<SocketChannel> { |

ChannelHandler是什么?它们之间是如何通信的?

ChannelHandler是一个接口,它定义了处理网络事件的方法,如读取数据、写入数据等。我们通常会实现这个接口或者继承自AbstractChannelHandler来创建自定义的处理器。

ChannelHandler之间可以通过ChannelPipeline来通信。ChannelPipeline管理了一系列的ChannelHandler,并按照顺序处理消息。

- 消息传递:消息从一个ChannelHandler传递到另一个ChannelHandler时,会按照ChannelPipeline中定义的顺序依次处理。每个ChannelHandler可以对消息进行处理、修改或转发。

- Context传递:ChannelHandlerContext提供了与ChannelHandler相关的上下文信息,包括获取当前ChannelHandler的前后Handler,以及发送消息给当前Channel或者管道中的其他ChannelHandler。

- 事件传播:除了消息外,ChannelPipeline还可以传播各种事件,如连接建立、断开等。这些事件同样会按照顺序传递给ChannelPipeline中的各个ChannelHandler。

示例代码如下:

1 | public class MyHandler extends ChannelInboundHandlerAdapter { |

ChannelHandlerContext是什么?有什么作用?

ChannelHandlerContext则是ChannelHandler的上下文环境,它提供了与处理器相关的上下文信息,比如可以获取当前处理器的前一个和下一个处理器,以及用于发送消息、注册定时器等功能的方法。ChannelHandlerContext在处理器中非常关键,因为它让我们可以方便地与ChannelPipeline交互。

ChannelHandlerContext是Netty中的一个重要的上下文环境对象,它提供了与ChannelHandler相关的上下文信息。主要作用包括:

- 上下文信息:提供当前

ChannelHandler的上下文信息,如获取当前ChannelHandler的前后ChannelHandler。 - 消息传递:可以用来向当前

Channel或管道中的其他ChannelHandler发送消息。 - 事件传播:可以用来触发事件给当前

Channel或管道中的其他ChannelHandler。 - 访问Channel属性:提供了访问和修改

Channel属性的方法。

示例代码如下:

1 | public class MyHandler extends SimpleChannelInboundHandler<String> { |

Channel和ChannelHandlerContext的关系是什么?

在Netty中,Channel代表了网络连接的一个端点,它封装了网络连接的生命周期,包括连接、读取、写入等操。

ChannelHandlerContext则是Channel的一个上下文环境,它为ChannelHandler提供了执行上下文。

ChannelHandlerContext包含了当前ChannelHandler的信息,以及对ChannelPipeline的操作方法。通过ChannelHandlerContext,我们可以获取当前ChannelHandler的前后Handler,发送消息给当前Channel或者管道中的其他ChannelHandler,以及访问Channel的各种属性等。

Channel和ChannelFuture的区别是什么?

Channel和ChannelFuture`在Netty中有不同的作用:

- **

Channel**:代表了网络连接的一个端点,封装了网络连接的生命周期,包括连接、读取、写入等操作。Channel提供了执行这些操作的方法。 - **

ChannelFuture**:表示异步通道操作的结果,提供了方法来检查异步操作的状态,如是否完成、成功或失败等。ChannelFuture通常用于异步操作的同步等待和结果监听。

示例代码如下:

1 | public class MyServerInitializer extends ChannelInitializer<SocketChannel> { |

Selector机制是如何工作的?

Netty中的Selector机制主要用于处理网络连接的读写事件。在Java NIO中,Selector允许我们监听多个Channel的事件,如连接、读取、写入等。当有事件发生时,Selector会通知相应的Channel,这样我们就可以处理这些事件。

在Netty中,通常每个EventLoopGroup对应一个Selector,而每个EventLoop负责处理绑定到它的Channel的IO操作。当一个Channel上有事件发生时,EventLoop会轮询Selector,发现有事件就调用相应的Handler来处理。

EventLoop和EventLoopGroup有什么区别?

EventLoop和EventLoopGroup是Netty中用来处理IO操作的关键组件。

- EventLoop:它是Netty中的一个线程,负责处理绑定到它的Channel的IO操作,如读取、写入和连接等。每个EventLoop都有一个Selector,用来监听Channel上的事件。

- EventLoopGroup:它是一组EventLoop的集合,用于管理多个EventLoop。EventLoopGroup负责为新创建的Channel分配合适的EventLoop。Netty中有两种类型的EventLoopGroup:BossGroup和WorkerGroup。BossGroup负责接受客户端的连接请求,而WorkerGroup负责处理已经被接受的连接上的读写操作。

Future和Promise是什么?它们的作用是什么?

Netty中的Future和Promise是用于处理异步操作的结果和状态的。

- Future:表示异步操作的结果,它提供了一些方法来检查异步操作是否完成,以及获取操作的结果或抛出异常。使用Future可以很容易地实现异步编程模型。

- Promise:是一个特殊的Future,它还提供了一个方法来设置异步操作的结果。Promise通常用于Channel操作,如注册、连接、写入等,它允许在异步操作完成后设置结果或异常。

使用Future和Promise可以更好地控制异步操作的生命周期,处理异步回调中的异常,并且可以方便地进行链式调用。

—————————————

Java基础

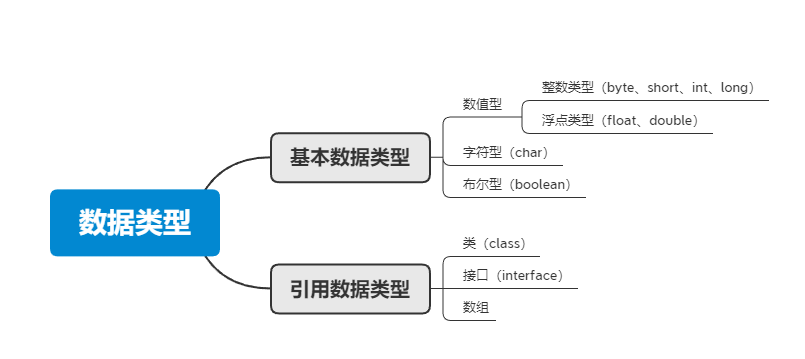

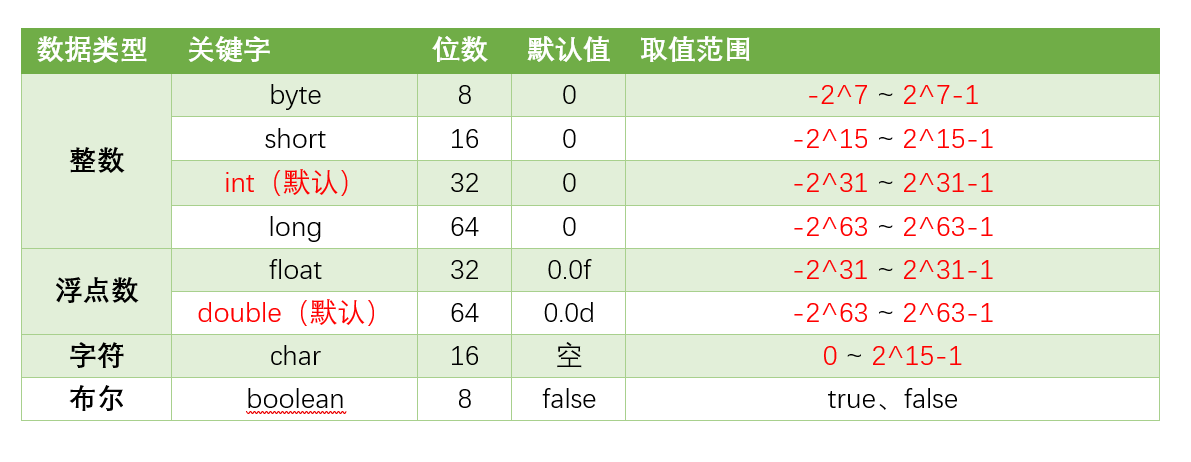

八种基本的数据类型

Java支持数据类型分为两类: 基本数据类型和引用数据类型。

基本数据类型共有8种,可以分为三类:

- 数值型:整数类型(byte、short、int、long)和浮点类型(float、double)

- 字符型:char

- 布尔型:boolean

8种基本数据类型的默认值、位数、取值范围,如下表所示:

String、StringBuffer 和 StringBuilder 的区别

- String:不可变,适合少量字符串操作。

- StringBuffer:可变且线程安全,适合多线程环境中的频繁字符串修改,,内部使用了

synchronized关键字来保证多线程环境下的安全性。 - StringBuilder:可变且非线程安全,适合单线程环境中的高性能字符串处理,性能比

StringBuffer更高。

接口和抽象类有什么区别?

接口的设计是自上而下的。我们知晓某一行为,于是基于这些行为约束定义了接口,一些类需要有这些行为,因此实现对应的接口。

抽象类的设计是自下而上的。我们写了很多类,发现它们之间有共性,通过代码复用将公共逻辑封装成一个抽象类,减少代码冗余。

所谓的 自上而下 指的是先约定接口,再实现。

而 自下而上的 是先有一些类,才抽象了共同父类(可能和学校教的不太一样,但是实战中很多时候都是因为重构才有的抽象)。

其他区别

1)方法实现

接口中的方法默认是 public 和 abstract(但在 Java8 之后可以设置 default 方法或者静态方法)。

抽象类可以包含 abstract 方法(没有实现)和具体方法(有实现)。它允许子类继承并重用抽象类中的方法实现。

2)构造函数和成员变量

接口不能包含构造函数,接口中的成员变量默认为常量。

抽象类可以包含构造函数,成员变量可以有不同的访问修饰符。

3)多继承

抽象类只能单继承,接口可以有多个实现。

注解原理是什么?

注解其实就是一个标记,是一种提供元数据的机制,用于给代码添加说明信息。

注解可以标记在类上、方法上、属性上等,标记自身也可以设置一些值。

注解本身不影响程序的逻辑执行,但可以通过工具或框架来利用这些信息进行特定的处理,如代码生成、编译时检查、运行时处理等。

Java 反射机制

反射机制提供了在运行时动态创建对象、调用方法、访问字段等功能,而无需在编译时知道这些类的具体信息。

反射机制的优点:

- 可以动态地获取类的信息,不需要在编译时就知道类的信息。

- 可以动态地创建对象,不需要在编译时就知道对象的类型。

- 可以动态地调用对象的属性和方法,在运行时动态地改变对象的行为。

反射机制的缺点:

- 性能损失。

- 安全风险。

反射机制的应用场景:

- 动态代理。

- 测试工具。

- ORM框架。

深拷贝和浅拷贝有什么区别?

深拷贝:深拷贝不仅复制对象本身,还递归复制对象中所有引用的对象。这样新对象与原对象完全独立,修改新对象不会影响到原对象。即包括基本类型和引用类型,堆内的引用对象也会复制一份。

浅拷贝:拷贝只复制对象的引用,而不复制引用指向的实际对象。也就是说,浅拷贝创建一个新对象,但它的字段(若是对象类型)指向的是原对象中的相同内存地。

深拷贝创建的新对象与原对象完全独立,任何一个对象的修改都不会影响另一个。而修改浅拷贝对象中引用类型的字段会影响到原对象,因为它们共享相同的引用。

网络通信协议名词解释

以一个点外卖的例子解释什么是IP地址、端口号、Socket和协议。

IP地址:对应的是我们上班所在的一个大楼。

端口号:对应我们所在大楼里的一个具体房间。

Socket:进行通信的一个工具。

协议:通信要遵循的规则。

例子:

IP地址:外卖员要送餐到的大楼(例如:腾讯大楼)。

端口号:外卖员要到大楼里的具体房间(例如:1001)。

Socket:外卖员通过手机(Socket)与我们通信,告知外卖已到。

协议:我们默认使用中文对话。

Java 访问修饰符

- public:完全公开,任何地方都可以访问。

- private:仅限于本类内部访问。

- protected:本类内部及子类可以访问。

- 默认(无修饰符):包内可见,同包下的其他类可以访问。

| 修饰符 | 当前类 | 同一包内 | 子类(不同包) | 其他包 |

|---|---|---|---|---|

| public | 是 | 是 | 是 | 是 |

| protected | 是 | 是 | 是 | 否 |

| 默认(default) | 是 | 是 | 否 | 否 |

| private | 是 | 否 | 否 | 否 |

适用范围区别

- **

public**:类、接口、字段、方法、构造函数。 - **

protected**:字段、方法、构造函数(没有类)。 - 默认(包级别):类、字段、方法、构造函数。

- **

private**:字段、方法、构造函数(没有类)。

访问修饰符的选择

- **

public**:适用于需要被外部类广泛访问的成员。过多使用public可能导致封装性降低。 - **

protected**:适用于需要在继承关系中使用的成员。它提供了比public更严格的访问控制,但允许子类访问。 - 默认(包级别):适用于仅在同一包内使用的类和成员。适当使用可以隐藏实现细节,减少类之间的耦合。

- **

private**:适用于内部实现细节,确保类的内部数据和方法不会被外部直接访问。最严格的访问控制,保护类的封装性。

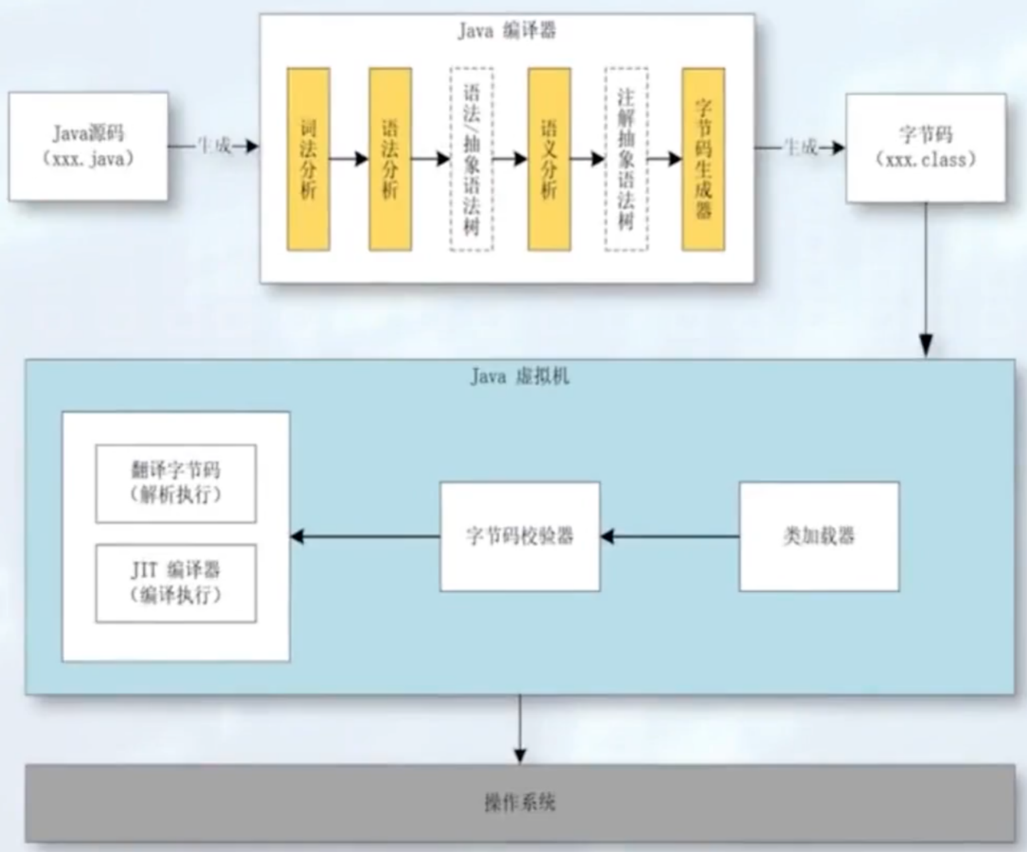

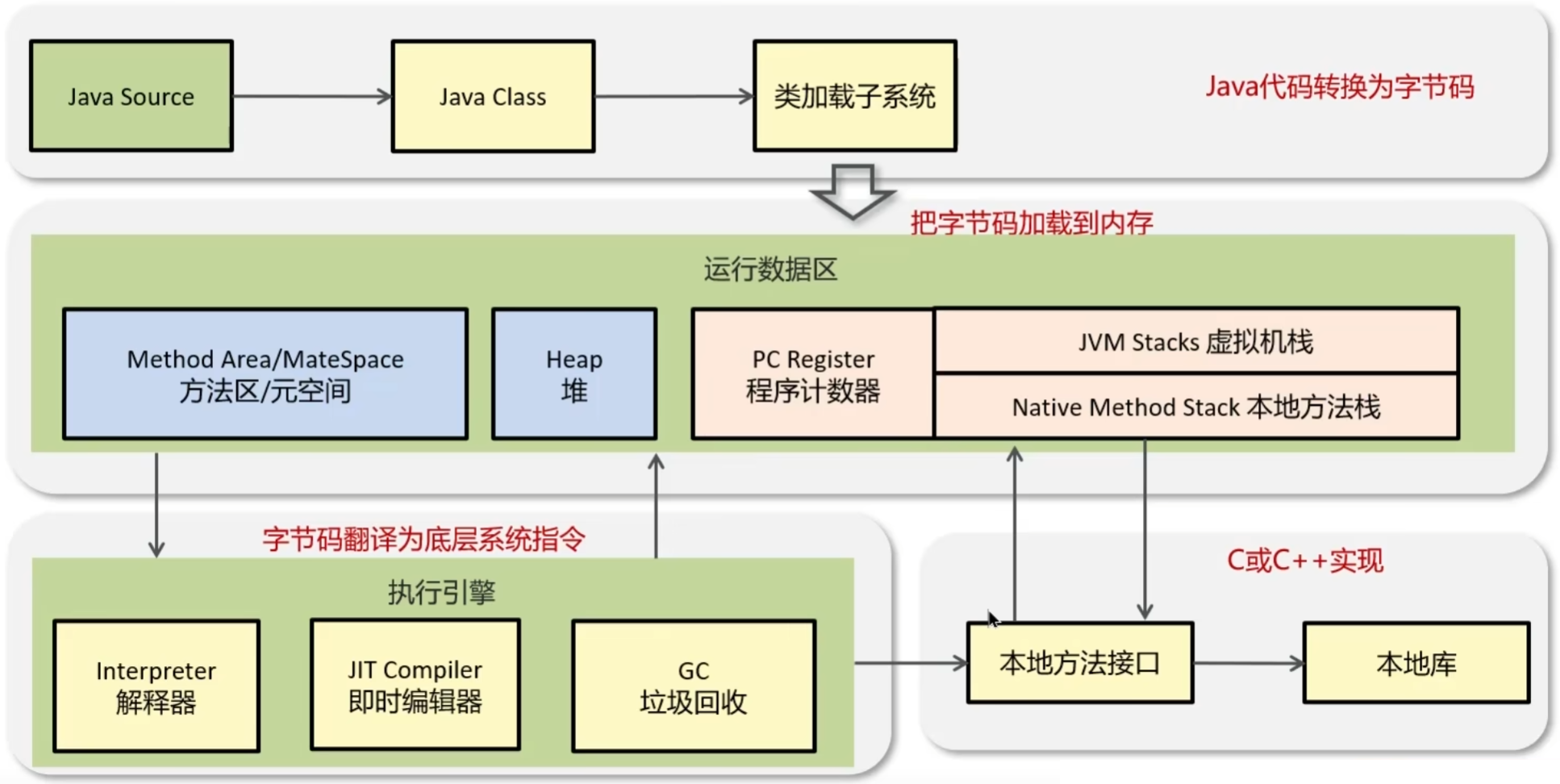

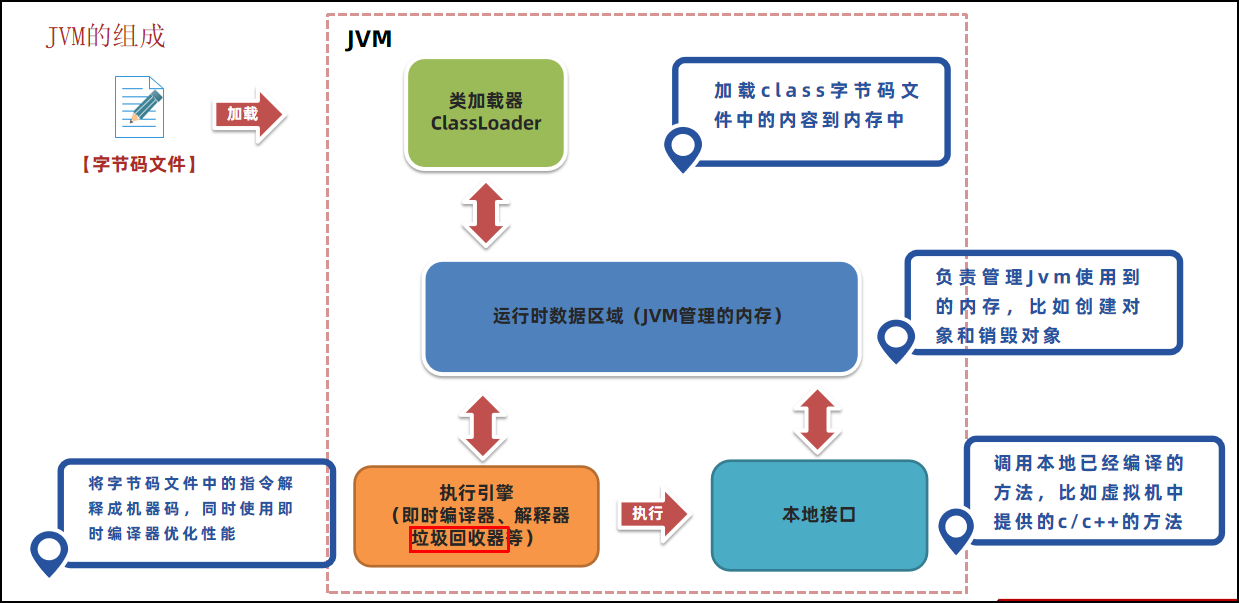

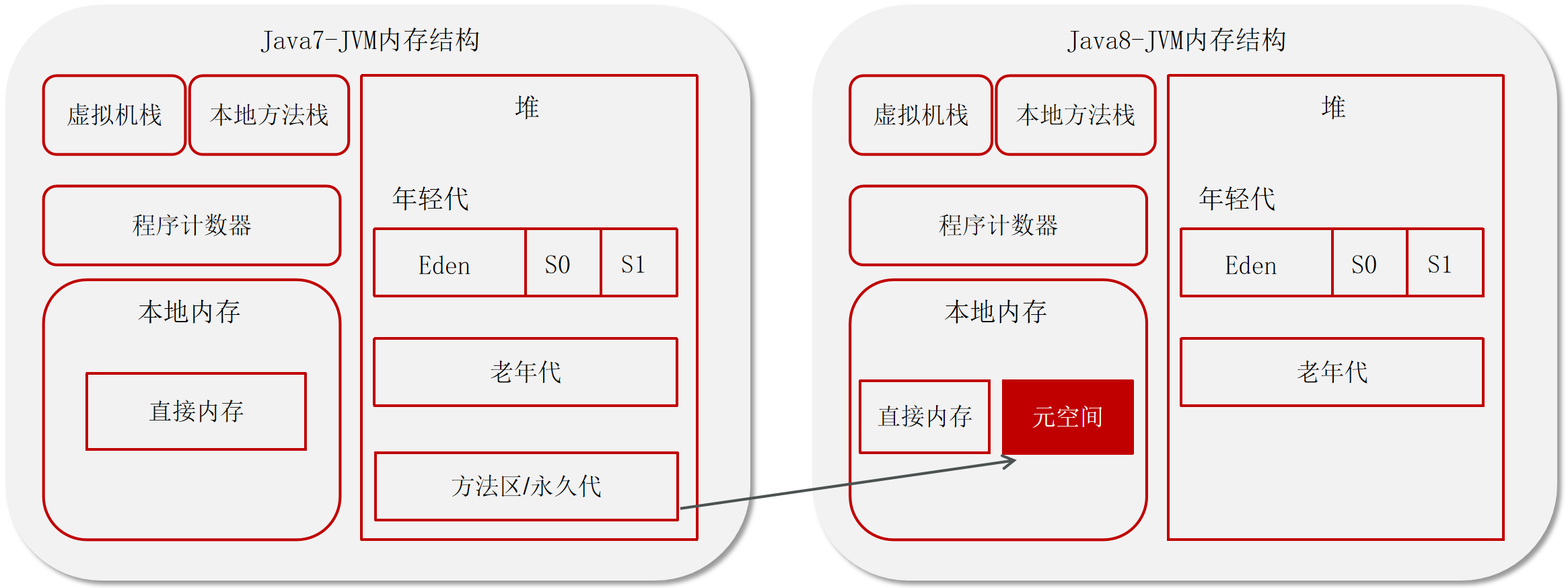

Java 字节码是什么?

字节码是编译器将源代码编译后生成的中间表示形式,位于源代码与 JVM 执行的机器码之间。

字节码由 JVM 解释或即时编译(JIT)为机器码执行。

字节码结构:

- Java 字节码是平台无关的指令集,存储在

.class文件中。每个.class文件包含类的定义信息、字段、方法,以及方法对应的字节码指令。

字节码指令集:

- Java 字节码包含一系列指令,如加载、存储、算术运算、类型转换、对象操作、控制流等。常见的指令包括

aload,iload,astore,iadd,if_icmpgt等。

执行过程:

- JVM 通过解释器逐条执行字节码,或通过 JIT 编译器将热点字节码片段即时编译为机器码,提高执行效率。

反射与动态代理:

- 通过 Java 反射 API,可以在运行时动态生成或修改字节码,从而创建代理对象或实现动态方法调用。

字节码增强与框架:

- 许多 Java 框架(如 Hibernate, Spring AOP)使用字节码增强技术,通过修改类的字节码来实现功能增强。常用工具包括 ASM、Javassist、CGLIB 等。

—————————————

数据库(MySQL、PostgreSql)

MySQL支持的存储引擎及其区别

存储引擎就是存储数据、建立索引、更新/查询数据等技术的实现方式 。存储引擎是基于表的,而不是基于库的,所以存储引擎也可被称为表类型。

在MySQL中提供了很多的存储引擎,比较常见有InnoDB、MyISAM、Memory

InnoDB:存储引擎是mysql5.5之后是默认的引擎,它支持事务、外键、表级锁和行级锁。DML操作遵循ACID模型,支持事务。有行级锁,提高并发访问性能。支持外键,保证数据的完整性和正确性。MyISAM:不支持事务、外键,只有表级锁,用的不多Memory:不支持事务、外键,只有表级锁,用的也不多,特点是能把数据存储在内存里

| 特性 | InnoDB | MyISAM | Memory |

|---|---|---|---|

| 事务安全 | 支持 | 不支持 | 不支持 |

| 锁机制 | 表锁/行锁 | 表锁 | 表锁 |

| 外键 | 支持 | 不支持 | 不支持 |

PostgreSQL 的唯一存储引擎:Heap

Heap 存储引擎是 PostgreSQL 的默认存储引擎,也是唯一内置的存储引擎。它具有以下特点:

- 事务支持:支持 ACID、MVCC,支持多种隔离级别,如读已提交(Read Committed)、可重复读(Repeatable Read)和序列化(Serializable)。

- 索引支持:支持 B-Tree、Hash、GiST(通用搜索树)、SP-GiST(空间分区通用搜索树)、GIN(通用倒排索引)和 BRIN(块范围索引)。

- 数据类型支持:支持自定义数据类型。支持整数、浮点数、字符串、日期时间、UUID、JSON、XML、数组、范围类型等。

- 扩展性:支持插件和扩展,可以添加新的功能和模块。支持外部表(Foreign Tables),可以访问其他数据源的数据。

- 备份和恢复:支持物理备份和逻辑备份。支持点-in-time 恢复(PITR)。

- 性能优化:支持查询优化器,可以生成高效的查询计划。支持分区表,可以将大表分成多个小表,提高查询性能。

PostgreSQL 的扩展和存储层

虽然 PostgreSQL 只有一种默认的存储引擎,但它通过扩展机制支持其他存储层和功能。以下是一些常见的扩展:

- TimescaleDB:

- 一个专门为时间序列数据设计的 PostgreSQL 扩展。

- 支持高效的时间序列数据存储和查询。

- Citus:

- 一个用于水平扩展 PostgreSQL 的扩展,支持分布式查询和数据分片。

- 适用于大数据和高并发场景。

- PostGIS:

- 一个用于地理空间数据的扩展,支持 GIS(地理信息系统)功能。

- 支持空间索引、空间操作和地理数据类型。

- pg_stat_statements:

- 一个用于收集和报告查询统计信息的扩展。

- 帮助优化查询性能和识别慢查询。

- pg_partman:

- 一个用于管理和维护分区表的扩展。

- 支持自动分区和维护分区表的生命周期。

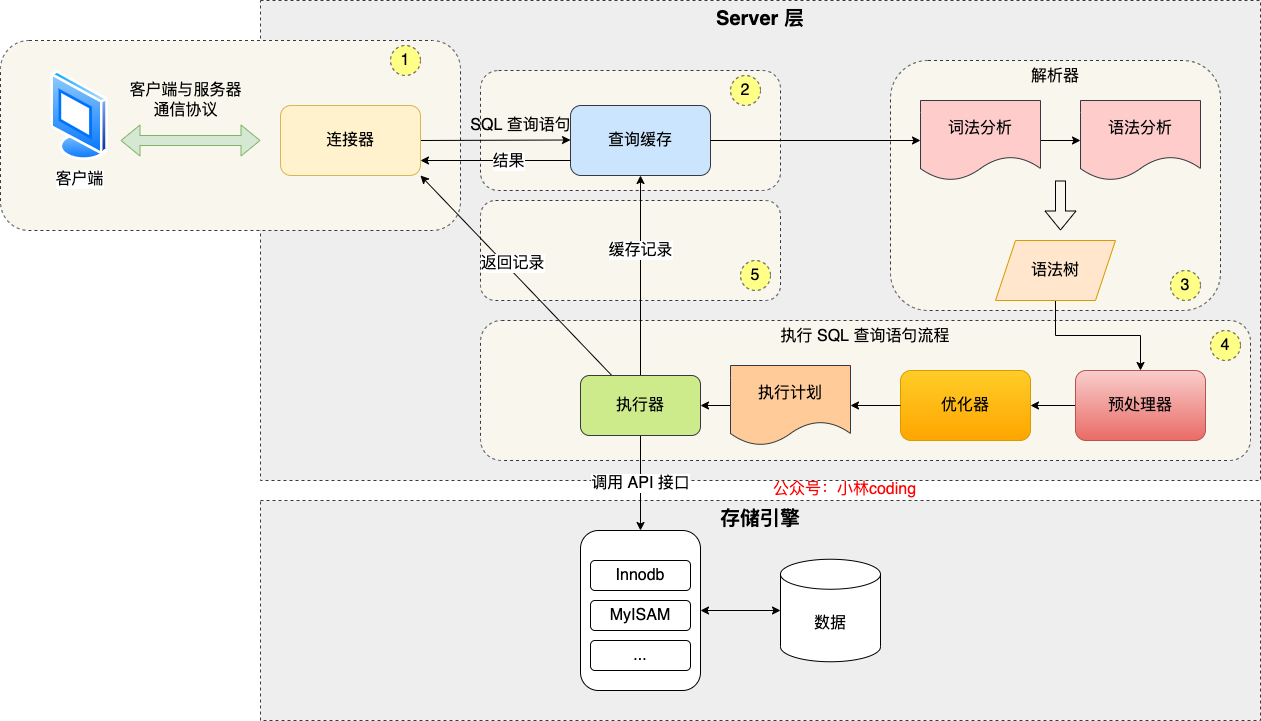

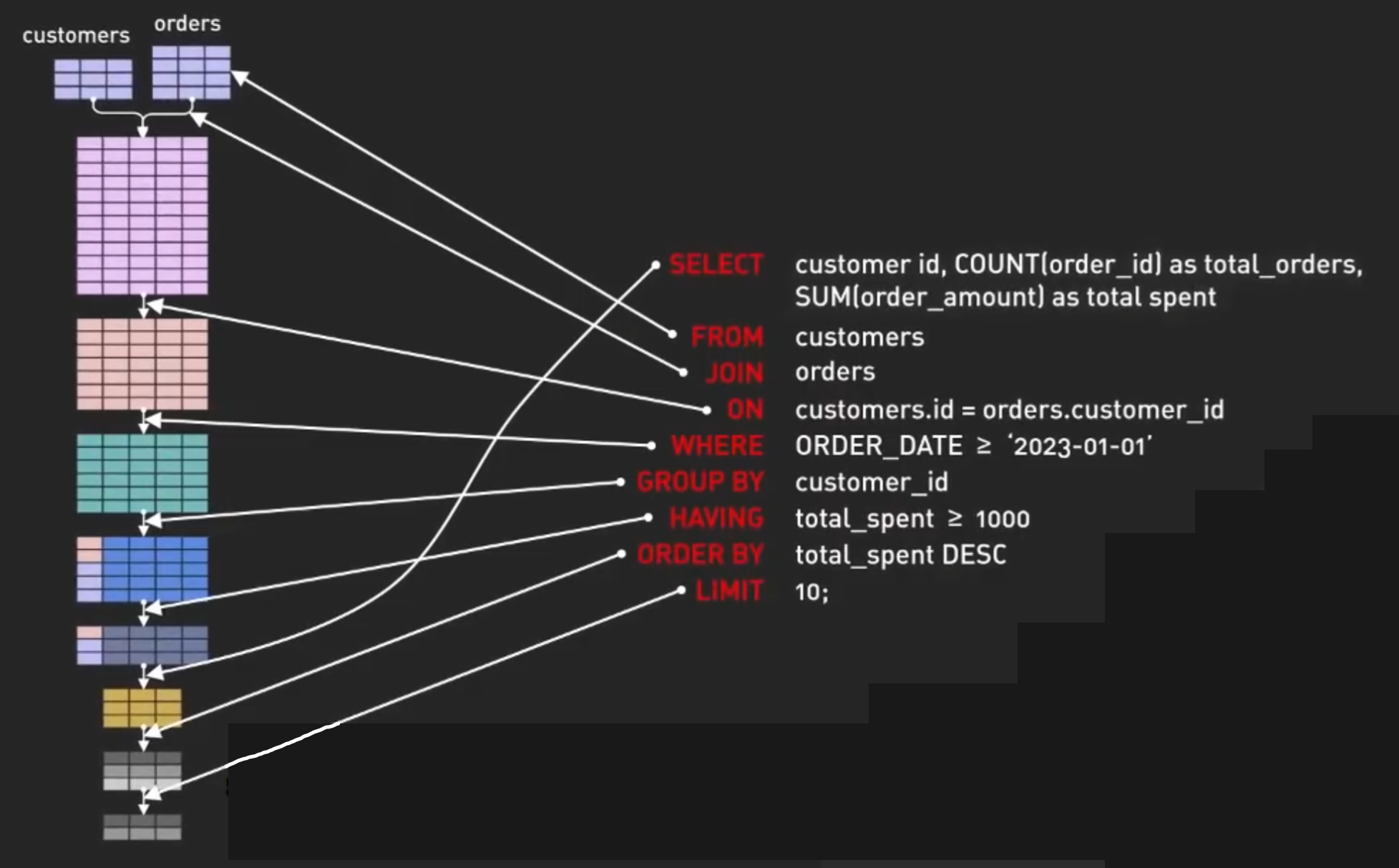

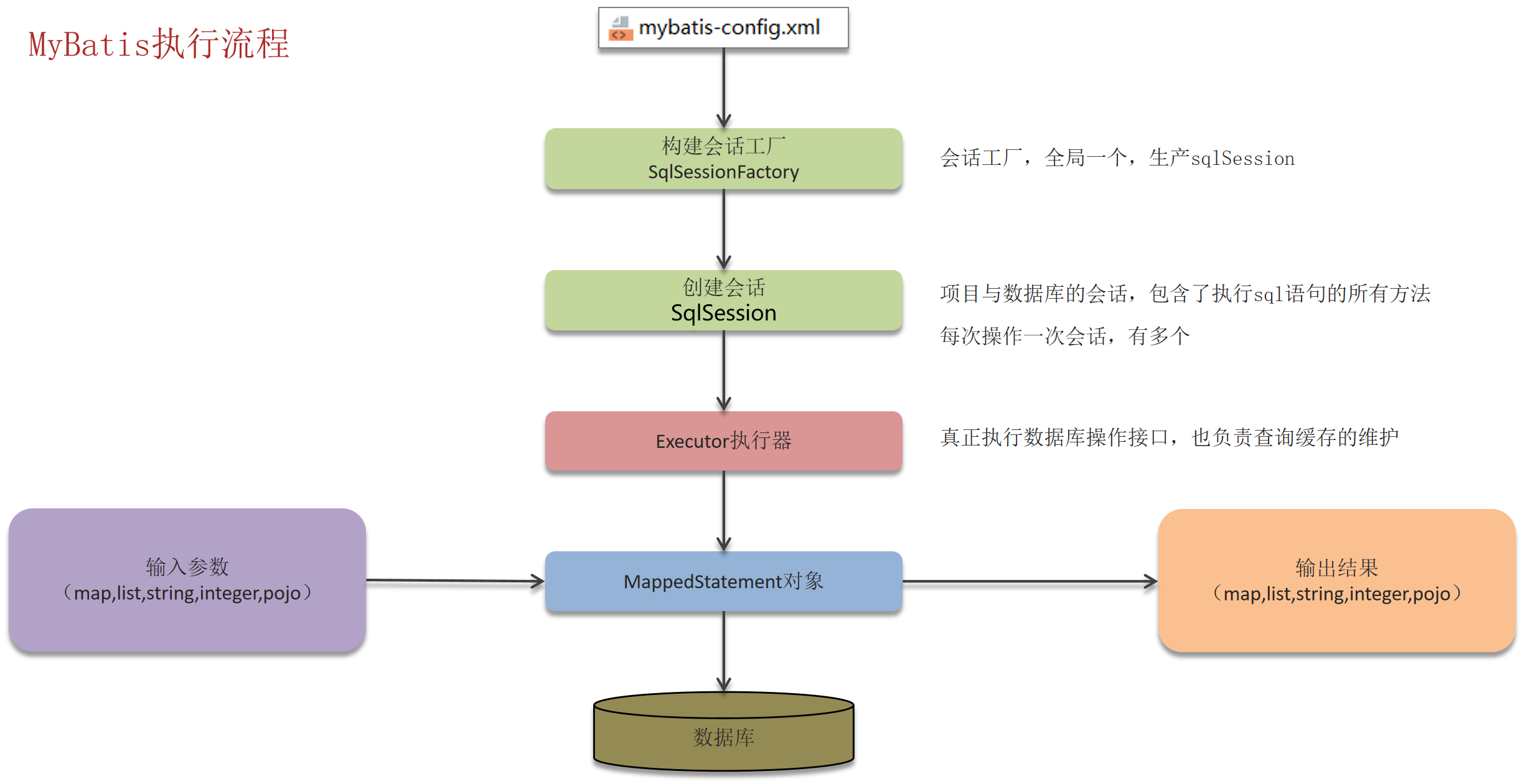

SQL语句在MySQL中的执行过程

(参数映射、sql解析、执行和结果处理)

- 连接器: 身份认证和权限相关(登录 MySQL 的时候)。

- 查询缓存: 执行查询语句的时候,会先查询缓存(MySQL 8.0 版本后移除,因为这个功能不太实用)。

- 分析器: 没有命中缓存的话,SQL 语句就会经过分析器,分析器说白了就是要先看你的 SQL 语句要干嘛,再检查你的 SQL 语句语法是否正确。

- 优化器: 按照 MySQL 认为最优的方案去执行。

- 执行器: 执行语句,然后从存储引擎返回数据。

终极SQL分析——Hikvision

1 | WITH Sales_Summary AS ( |

这段 SQL 语句是一个较为复杂的查询,使用了多个公共表表达式(Common Table Expressions,简称 CTE),主要用于汇总和分析不同产品类别的销售数据、产品数量以及客户满意度,并找出每个产品类别中销售额最高的地区。下面是对这段 SQL 的详细分析:

SQL 语句分析

这段 SQL 使用 CTE 可以使查询语句更加简洁、清晰,并且提高了可维护性和可读性。

1. Sales_Summary CTE

1 | WITH Sales_Summary AS ( |

- 作用:计算每个产品类别在不同地区的总销售额,并为每个地区分配一个排名。

- 字段说明:

Product_Category:产品类别。Region:地区。Total_Sales_Region:该地区内的总销售额。rn:在相同产品类别下,按总销售额降序排列的地区排名。

2. Product_Summary CTE

1 | Product_Summary AS ( |

- 作用:计算每个产品类别的销售总额和不同产品的数量。

- 字段说明:

Product_Category:产品类别。Total_Sales:该产品类别的总销售额。Number_of_Different_Product_IDs:该产品类别下不同产品的数量。

3. Satisfaction_Averages CTE

1 | Satisfaction_Averages AS ( |

- 作用:计算每个产品类别的平均客户满意度。

- 字段说明:

Product_Category:产品类别。Average_Satisfaction_Score:该产品类别的平均满意度得分(保留两位小数)。

4. 主查询

1 | SELECT |

- 作用:最终查询结果,展示每个产品类别的总销售额、不同产品的数量、平均满意度以及销售额最高的地区。

- 字段说明:

ps.Product_Category:产品类别。ps.Total_Sales:该产品类别的总销售额。ps.Number_of_Different_Product_IDs:该产品类别下不同产品的数量。sa.Average_Satisfaction_Score:该产品类别的平均满意度得分。ss.Region AS Top_Sales_Region:销售额最高的地区。

WITH ... AS 用法解释

WITH ... AS 是 SQL 中的一个构造,用于定义公共表表达式(CTE)。CTE 是一个临时的结果集,只存在于包含它的查询中。它可以简化复杂的查询语句,使其更易读和维护。

优点

- 提高可读性:通过将复杂的查询拆分为多个CTE,可以使查询更加模块化和清晰。

- 减少重复:可以多次引用同一个CTE,避免重复编写相同的子查询。

- 提高性能:CTE 只执行一次,并且只在主查询需要时才执行,可以减少不必要的计算。

语法

1 | WITH CTE_Name (Column1, Column2, ...) |

对思考 last_updated 字段的意义

- 数据同步和一致性。在主从同步中,从数据库同步主数据库时,通过对比本地的

last_updated和主节点的last_updated,可以知道需要同步哪些数据 - 审计和追踪。

last_updated字段可以帮助定位最后一次更新的时间,进而确定变动的来源和责任人。 - 并发控制(乐观锁)。不必单独设置一个字段

version,但需要手动维护last_updated - 数据备份和恢复。在数据备份和恢复过程中,

last_updated字段可以用来判断哪些数据是最新的,哪些数据需要恢复。特别是在系统发生故障或数据丢失时,备份数据可能并非实时更新,因此需要依赖last_updated字段来进行增量恢复。 - 数据预热。在处理定期批量更新操作时,系统只需要查询那些

last_updated字段在某个时间范围内的数据,而不必每次都处理所有数据,减少了不必要的查询负担。

SQL优化方案

总结

表的设计优化

根据实际情况选择合适的数值类型(tinyint、int、bigint)

根据实际情况选择合适的字符串类型(char、varchar)

索引优化

对数据量打的表创建索引

对常作为查询条件、排序、分组的字段创建索引

尽量创建联合索引

控制索引的数量

……

SQL语句优化

合理编写SQL语句(避免直接使用select *、用union all代替union、能用inner join 就不用left join、right join、避免在where子句中对字段进行表达式操作)

避免SQL语句造成索引失效的写法(使用函数或表达式处理索引列、隐式类型转换、使用不等于(<> 或 !=)操作……)

主从复制、读写分离

分库分表

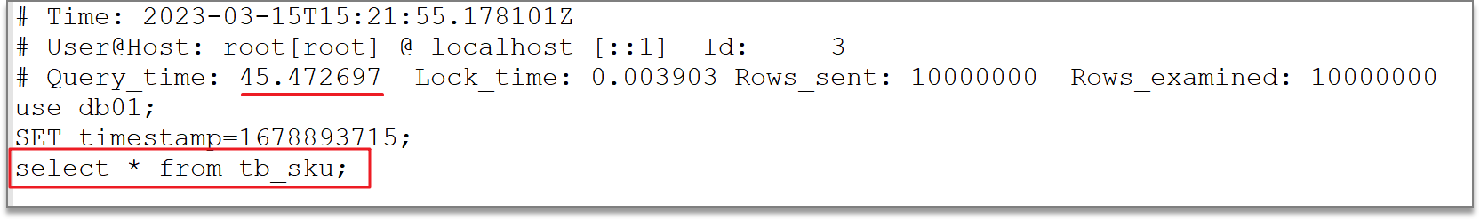

定位慢查询的方法

SQL执行很慢,可能有一下原因:聚合查询、多表查询、表数据量过大查询、深度分页查询

需要在MySQL的配置文件(/etc/my.cnf)中配置如下信息:

1 | # 开启MySQL慢日志查询开关 |

配置完毕之后,通过以下指令重新启动MySQL服务器进行测试,查看慢日志文件中记录的信息 /var/lib/mysql/localhost-slow.log

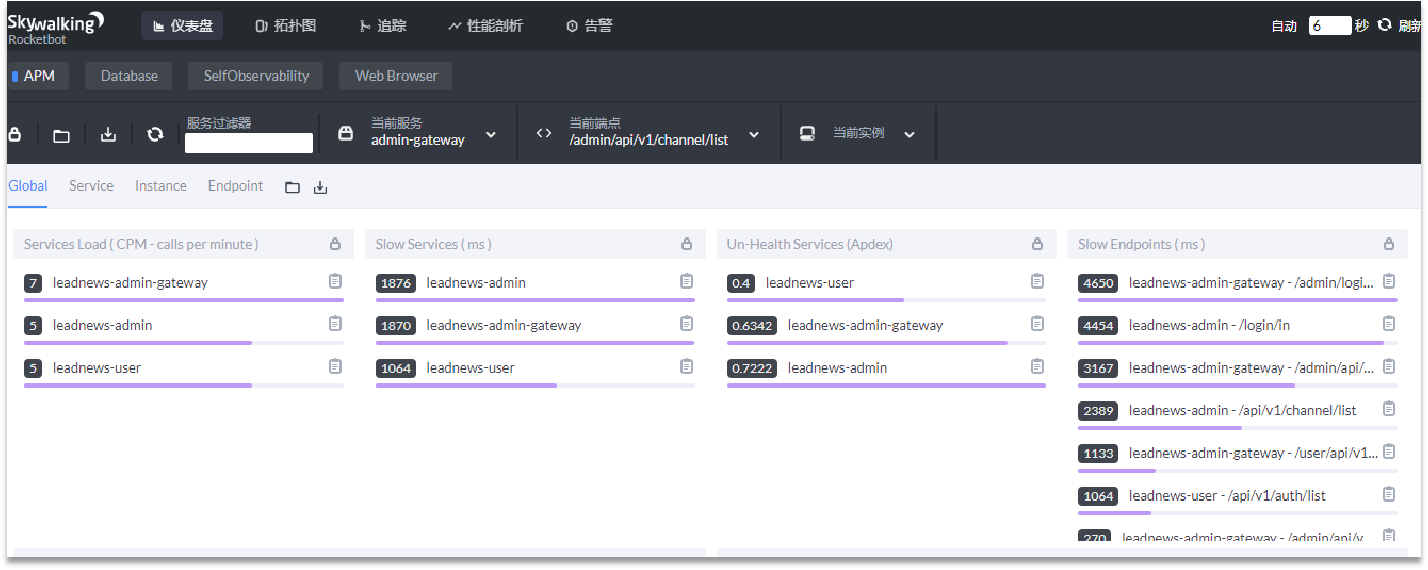

当然,也有相关的工具:

调试工具:Arthas

运维工具:Prometheus 、Skywalking

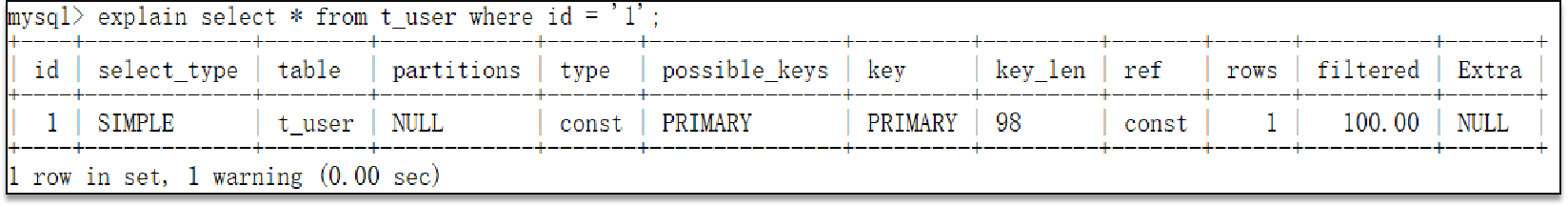

分析SQL语句

1 | - 直接在select语句之前加上关键字 explain / desc |

然后需要关注以下字段:

type:当前sql的连接的类型,性能由好到差为NULL、system、const、eq_ref、ref、range、 index、all

system:查询系统中的表

const:根据主键查询

eq_ref:主键索引查询或唯一索引查询

ref:索引查询

range:范围查询

index:索引树扫描

all:全盘扫描possible_key:当前sql可能会使用到的索引key:当前sql实际命中的索引key_len:索引占用的大小Extra:额外的优化建议Using where; Using Index:查找使用了索引,需要的数据都在索引列中能找到,不需要回表查询数据

Using index condition:查找使用了索引,但是需要回表查询数据

*例:给 JSON 类型字段添加虚拟列

eg. 以一张用户信息表为例

1 | CREATE TABLE `student` ( |

查询 json 类型的字段会走全表索引,耗时比较长,因此这时可以用虚拟列

1 | INSERT INTO student |

创建虚拟列及其索引,虚拟列的值会与 json字段中的指定的键值对匹配更新,如果没有就为null,非常省心

1 | ALTER TABLE student |

再分析sql性能,发现已经走虚拟列索引了(如果没走索引还是走全表,可能是数据量太少了)

1 | SELECT * |

—————————————

数据库-索引(MySQL)

索引

索引创建原则

- 数据量较大,且查询比较频繁的表

- 常作为查询条件、排序、分组的字段

- 字段内容区分度高

- 内容较长,使用前缀索引

- 尽量创建联合索引

- 控制索引的数量

- 如果索引列不能存储NULL值,请在创建表时使用NOT NULL约束它

索引失效情况

- 违反最左前缀法则

- 范围查询右边的列

- 在索引列上进行运算操作

- 字符串不加单引号

- 以%开头的Like模糊查询

索引不一定有效的原因

- 选择性差:如果索引列包含大量重复值(即选择性差),则查询优化器可能会决定全表扫描比使用索引更高效。

- 索引列少:如果查询涉及到多个条件,而索引只覆盖了部分条件,则可能不会被使用。

- 索引列顺序不当:对于复合索引,如果最左边的列不是查询中最常过滤的列,则索引可能不会被有效地利用。

- 数据范围广:如果查询返回的数据行接近整个表的大小,那么索引可能没有帮助,因为查询优化器可能会认为全表扫描更优。

- 未使用合适的访问类型:如使用

LIKE开头字符匹配或IN子句等,可能导致 MySQL 无法使用索引。 - 统计信息过时:MySQL 使用统计信息来决定是否使用索引,如果数据分布发生变化,需要更新统计信息。

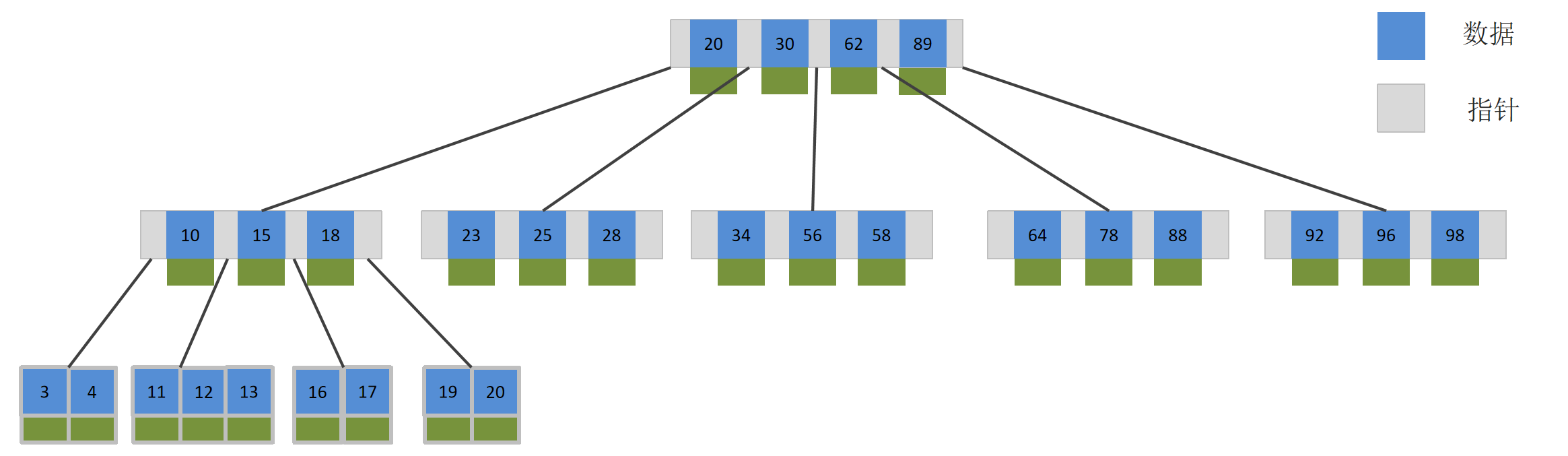

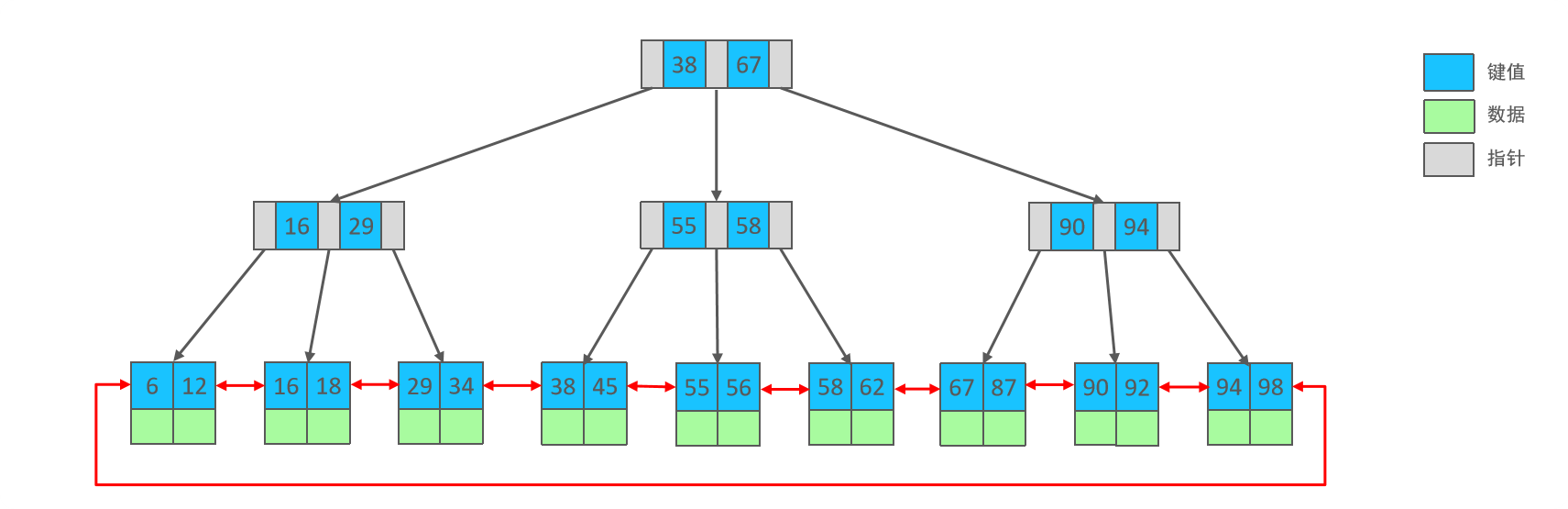

B+树索引

除了B+树类型的索引,还有全表索引、哈希索引……只是不太常用

索引是一种用于快速查询和检索数据的数据结构,其本质可以看成是一种排序好的数据结构。

特点:

- 索引是帮助MySQL高效获取数据的数据结构(有序)

- 提高数据检索的效率,降低数据库的IO成本(不需要全表扫描)

- 通过索引列对数据进行排序,降低数据排序的成本,降低了CPU的消耗

优点:

- 阶数更多,路径更短

- 磁盘读写代价B+树更低,非叶子节点只存储指针,叶子阶段存储数据

- B+树便于扫库和区间查询,叶子节点是一个双向链表

- 使用索引可以大大加快数据的检索速度(大大减少检索的数据量), 这也是创建索引的最主要的原因。

- 通过创建唯一性索引,可以保证数据库表中每一行数据的唯一性。

缺点:

- 创建、维护索引或对表进行操作需要重构索引。

- 索引需要使用物理文件存储,也会耗费一定空间。

B树与B+树的区别是什么?

B+树比B树查找效率更高的原因:

- B+树的所有的数据都会出现在叶子节点,所以查找时首先只需考虑如何找到索引值,而不需要比较值;

- B+树叶子节点是一个有序的双向链表,适合进行范围区间查询。

- B树

- B+树

聚索引 & 非聚集索引

聚集索引:非叶子节点存储主键id,叶子节点存放主键id和整行数据。一张表有且只有一个聚集索引。

非聚集索引:非叶子节点存放索引字段,叶子节点存放索引字段和主键id。一张表可以有多个非聚集索引。

聚集索引选取规则:

如果存在主键,主键索引就是聚集索引。

如果不存在主键,将使用第一个唯一(UNIQUE)索引作为聚集索引。

如果表没有主键,或没有合适的唯一索引,则InnoDB会自动生成一个rowid作为隐藏的聚集索引。

聚簇索引和非聚簇索引有的时候又称为主索引树和辅助索引树

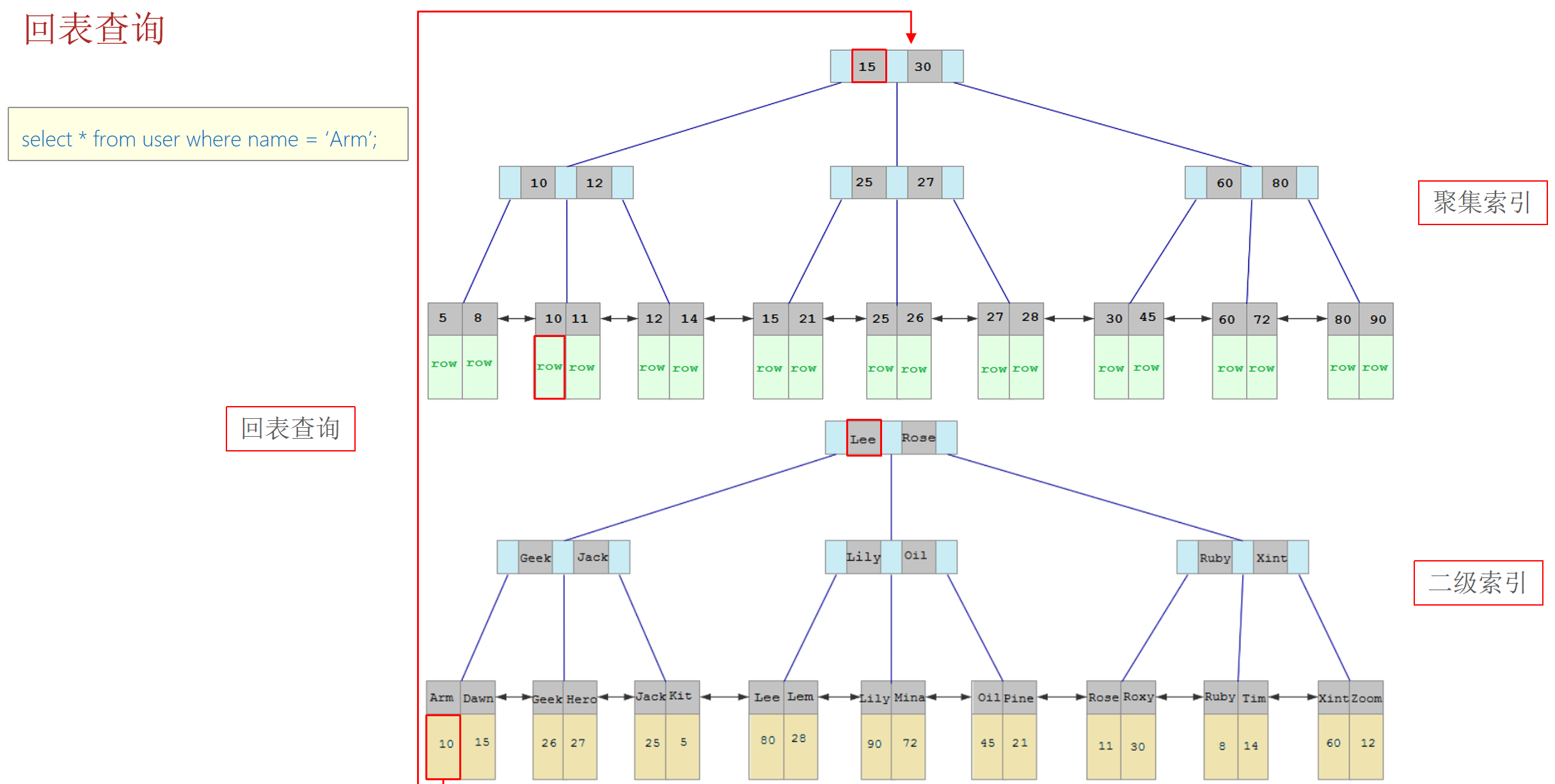

回表查询

回表查询:通过二级索引找到对应的主键值,到聚集索引中查找整行数据,这个过程就是回表。

覆盖索引

覆盖索引:是指二级索引中包含了查询所需的所有字段,从而使查询可以仅通过访问二级索引而不需要访问实际的表数据(主键索引)。

- 使用id查询,直接走聚集索引查询,一次索引扫描,直接返回数据,性能高。

- 如果返回的列中没有创建索引,有可能会触发回表查询,尽量避免使用

select *

超大分页处理方案

在数据量比较大时,limit分页查询,需要对数据进行排序,效率低,通过创建覆盖索引能够比较好地提高性能,可以通过覆盖索引+子查询形式进行优化。

例如,该查询语句可以这样优化:

2

3

(select id from user order by id limit 9000000,10) a

where u.id = a.id;解释:采用子查询通过主键索引查询到了第9000000行的数据,接着顺序读取10行得到10个id,然后将这10行id与外部sql做一个自连接,通过主键索引树查询直接得到了第9000000后的10行数据。

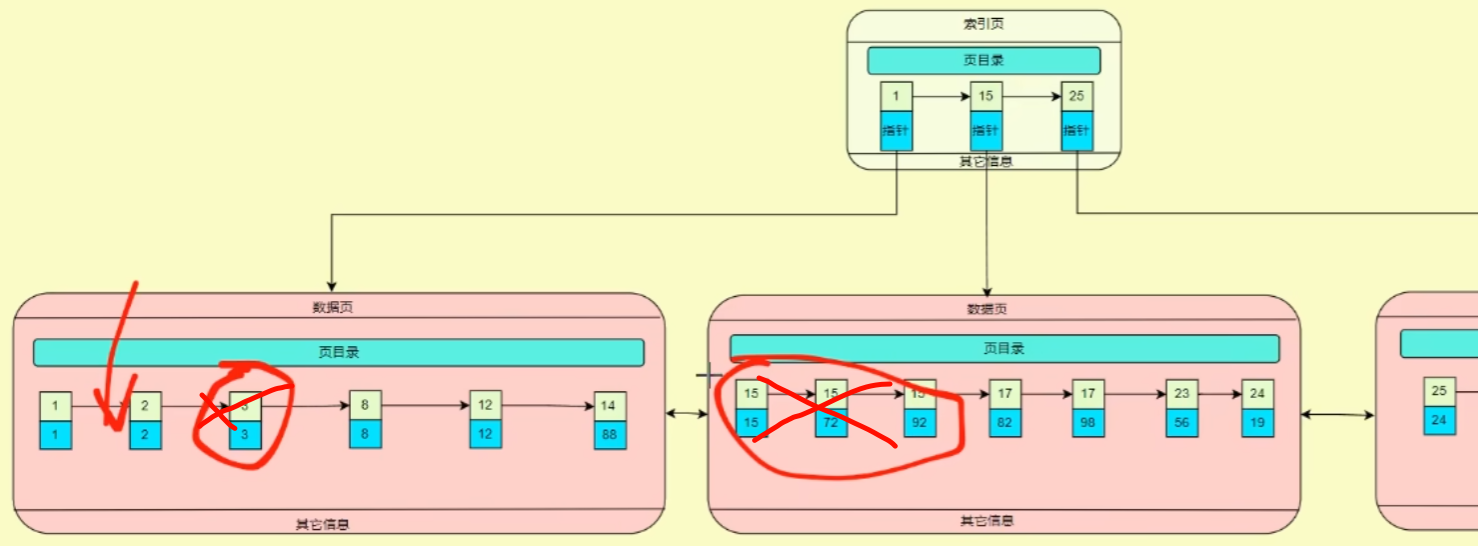

索引的维护

索引的数据结构

首先通过两个类实现B+树非叶子节点和叶子结点:

非叶子节点类

InternalNode:1

private List<AbstractTreeNode<K, V>> childrenNodes; // 孩子节点

叶子节点类

LeafNode1

2

3private List<K> keys; // 叶子节点中的键,即主键索引值

private List<V> values; // 叶子节点中的值,即整行数据

private LeafNode<K, V> next; // 下一个叶子节点的指针

B+树的增删查改操作

**查 (Search)**:从根节点开始二分查找,B+树中使用二分查找可能在一个节点中找不到对应的结点,所以需要根据键值去子节点的孩子节点中遍历查找,直到找到叶子节点中对应的key和整行数据。

**改 (Update)**:先去查询,如果键已存在,更新其值;如果键不存在,则修改失败。

**删 (Delete)**:先去查询,进行删除,可以用

逻辑删除或删除-合并:逻辑删除:只清空整行记录,不清除键,保持B+树的形状。删除-合并:删除后如果节点元素过少,需要进行合并。

**增 (Insert)**:先去查询,查找插入位置,插入后判断是否需要分裂。分裂算法:new一个新的叶子节点,将当前叶子节点一半的键和键对应的值移动到新的叶子节点,然后将新的叶子节点插入到原本的叶子节点链表中。之后更新父节点的索引,将新的叶子节点中最小 的 key 传递给父节点,父节点插入这个新的 key 作为索引。如果父节点也超出了最大容量,同样会进行分裂并向上传递。当一个非叶子节点分裂时,都需要将分裂产生的新的 key 上移到父节点。如果父节点也满了,继续分裂并将

key递归上传。

主键索引的维护

例如在执行下面这句话时:

1 | update user set id=id+1 where age=18; |

数据库会从 id 索引找到对应的数据行,然后更新 id 值。对于主键索引来说,更新主键值可能导致数据页移动,因为主键值是数据页的物理位置标识。

非主键索引的维护

非聚集索引的叶子节点存储了指向实际数据行的指针,如果修改了索引列的值,那么非聚集索引对应的叶子节点也会相应更新。

例如在执行下面这句话时:

1 | update user set money=1000 where age=18; |

- 根据

age主键索引去查询符合条件的的记录,对找到的行上排他锁 (X lock),保证并发事务的安全性和一致性,避免脏读、不可重复读等问题; - 对找到的行进行更新操作,去

money的非主键索引树修改money的数据。数据库会先删除原来的数据,然后按序将之前修改删除的索引结点插入在某个叶子结点后面; - 更新完成后,会释放所持有的锁,并提交事务。

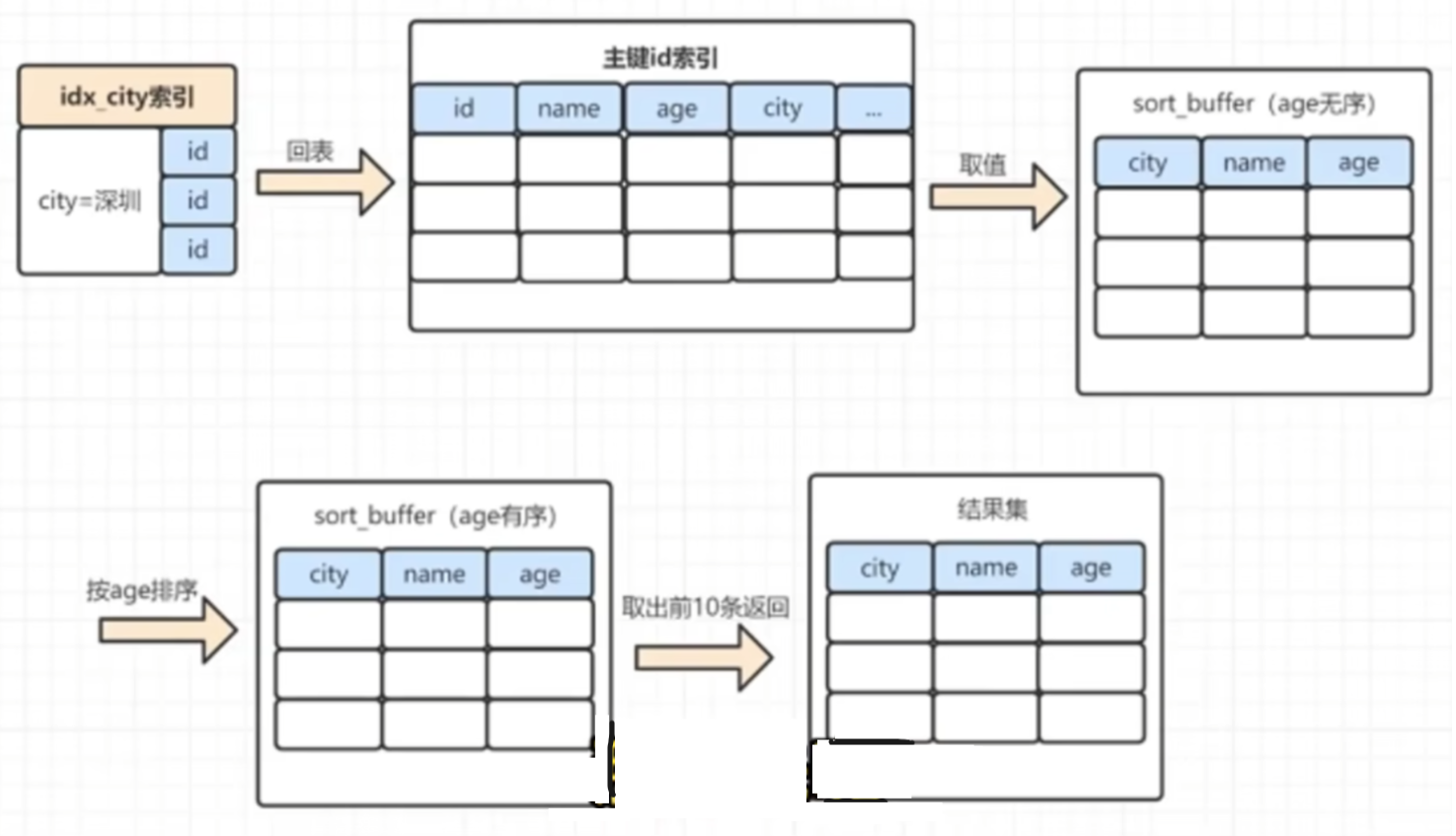

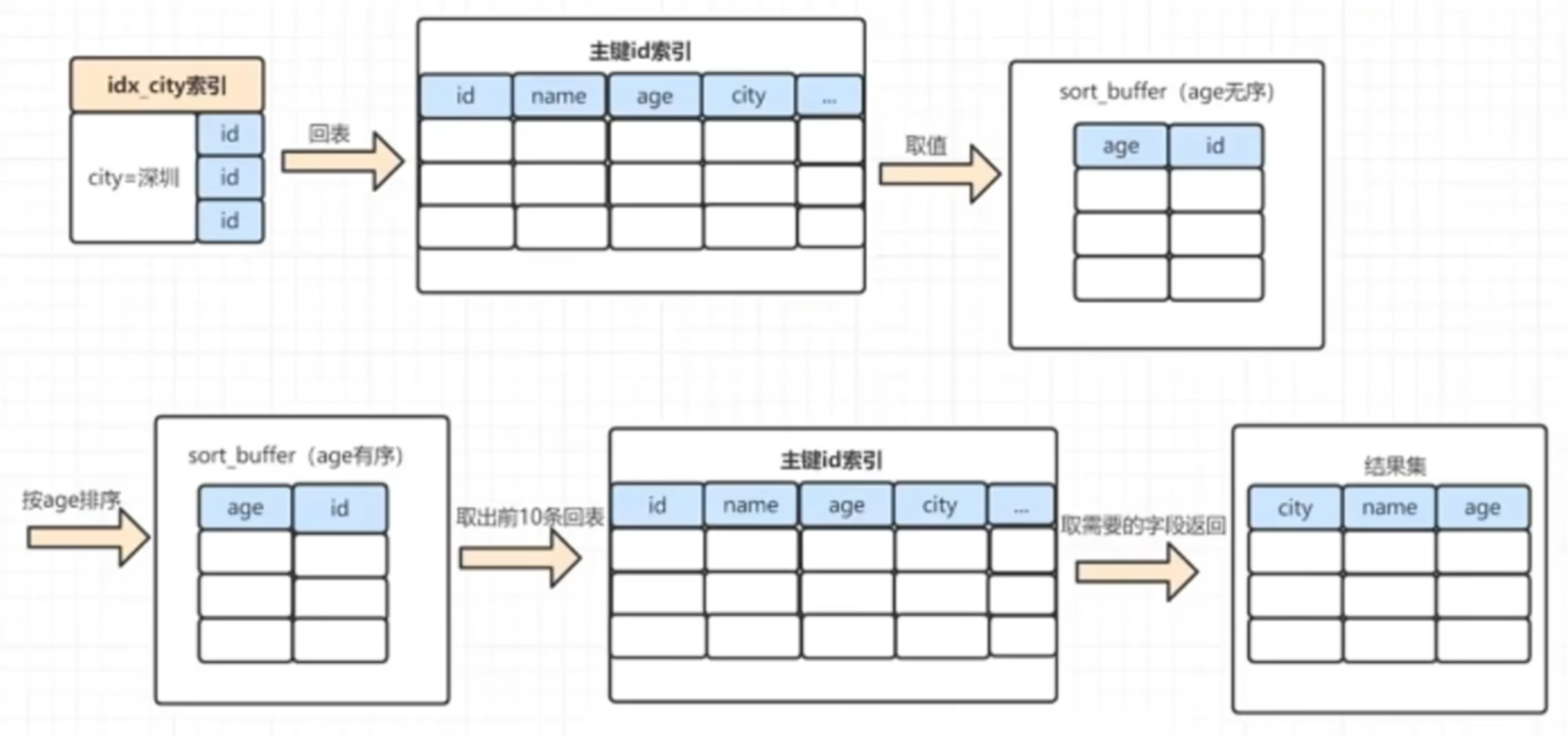

底层原理:order by 的实现原理(MySQL 5.7)

这涉及到两种排序规则:

- 全字段排序(有主键的情况走这种,几乎所有情况都是这样的)

- row id排序(没有主键的情况走这种,不太常见)

假设有以下SQL语句,

1 | SELECT name,age,city |

全字段排序加载过程

最普遍的情况,有主键的情况下采用全字段排序

- 根据索引从聚集索引树中找到对应的ID;

- 在聚集索引树找到对应的整行数据;

- 将查询字段(很多人会用

*,导致内存消耗很大)和排序字段加载到sort buff; - 在sort buff中根据关键字进行排序;

- 取出前10条数据,返回结果集。

row id排序加载过程

row id排序比全字段排序多了一次回表,但是比全排序占用更少的内存

- 根据索引从非聚集索引树中找到对应的ID;

- 在聚集索引树找到对应的整行数据;

- 将数据的主键(省内存的原因)和排序字段加载到sort buff;

- 在sort buff中根据关键字进行排序;

- 取出前10条数据,再去进行一次回表查询得到整行数据;

- 根据查询的字段值,返回结果集。

拓展:sort buffer

sort buffer的作用

sort buffer 指的是用于排序操作的内存缓冲区。当执行排序操作时,例如使用 ORDER BY 子句对结果集进行排序,数据库可能会使用一个或多个排序缓冲区来存储数据。

- 减少I/O操作:通过在内存中暂存要排序的数据,可以减少从磁盘读取数据的次数,从而提高排序速度。

- 提高排序效率:在内存中进行排序通常比在磁盘上进行排序更高效。因此,使用

sort buffer可以帮助加快排序过程。

sort buffer的工作原理

- 数据加载:当数据库需要对查询结果进行排序时,它首先会将部分数据加载到

sort buffer中。 - 排序操作:数据加载完成后,数据库会在

sort buffer内执行排序算法。如果数据量超过了sort buffer的容量,则可能需要将部分数据写入临时文件,并进行外部排序。 - 结果输出;排序完成后,数据库会将排好序的数据返回给客户端或用于进一步处理。

如何配置 sort buffer

在MySQL中,sort_buffer_size是一个全局或会话级别的系统变量,用于控制每个客户端连接可用的 sort buffer 的大小。

可以通过以下命令查看或修改该参数:

1 | SHOW VARIABLES LIKE 'sort_buffer_size'; |

调整 sort_buffer_size 可以影响排序操作的性能。如果设置得过小,可能导致频繁地将数据写入磁盘,从而降低性能;如果设置得过大,则可能消耗过多内存资源。

—————————————

数据库-事务(InnoDB)

锁

表锁

表级锁是最粗粒度的锁,会对整个表进行锁定,导致并发性能较差。MyISAM 支持以下两种类型的锁:

- 读锁(READ LOCK):当 SELECT 语句执行时,会自动获得读锁,此时其他事务可以读取数据,但不能修改数据。

- 写锁(WRITE LOCK):当 INSERT、UPDATE 或 DELETE 语句执行时,会自动获得写锁,此时其他事务既不能读也不能写。

由于 MyISAM 已经不再推荐使用,并且在新版本的 MySQL 中逐渐被淘汰,因此表级锁的使用也逐渐减少。

行锁

行级锁对表中的行进行锁定,而不是整个表,这样可以大大提高并发性能。InnoDB 支持以下几种类型的锁:

- 共享锁(Shared Locks, S-Locks):当 SELECT 语句带有 FOR SHARE 或者事务处于可重复读隔离级别时,会请求共享锁。共享锁允许其他事务读取数据,但阻止其他事务修改同一行数据。

- 排他锁(Exclusive Locks, X-Locks):当事务需要写入数据时,会请求排他锁。排他锁不允许其他事务读取或修改同一行数据。

其他类型的锁

除了上述的锁类型外,InnoDB 还有一些特殊的锁机制:

- 意向锁(Intention Locks):这是一种元锁,它并不锁住具体的行,而是表明事务打算对表中的行加锁。例如,意向共享锁(IS)表明事务打算对某行加共享锁,意向排他锁(IX)表明事务打算对某行加排他锁。

- 间隙锁(Gap Locks):间隙锁锁定的是索引项之间的“间隙”,防止其他事务插入新的行到这个间隙中。在可重复读RR隔离级别下,InnoDB 默认会使用间隙锁。

- Next-Key Locks:Next-Key 锁是 InnoDB 默认使用的锁类型,它是共享锁或排他锁与间隙锁的组合。它不仅锁住索引项本身,还会锁住索引项之间的间隙,以防止幻读现象。

死锁检测的基本原理

- 定时检测:使用定时检测。如果发现等待队列(Wait Queue)增长到一定长度时,就会触发一次死锁检测。

- 图算法:使用图算法。它构建了一个等待图(Wait-for Graph),在等待图中,节点代表事务,边表示事务间的等待关系。如果有环路(Cycle)存在,那么就表示发生了死锁。

死锁解决机制

一旦检测到死锁,InnoDB 就会采取措施来解决它。具体做法如下:

- 选择牺牲者:当检测到死锁时,InnoDB 会选择一个或多个事务作为“牺牲者”,这些事务将被回滚,以解除死锁。

- 选择标准:InnoDB 根据一定的标准来选择牺牲者。一般情况下,InnoDB 会选取一个最小的事务作为牺牲者。这个最小事务通常是基于事务的开始时间、事务的大小(即所持有的锁的数量)等因素来决定的。

- 通知用户:InnoDB 在回滚了某个事务后,会生成一条错误信息(如 Error 1213 Deadlock found when trying to get lock),并通过客户端 API 返回给应用程序。应用程序可以根据这个错误信息来进行相应的处理。

事务

事务的ACID特性?事务的并发解决方案?

- 事务的特性:

- 原子性(Atomicity):事务是不可分割的最小操作单元,要么全部成功,要么全部失败。

- 一致性(Consistency):事务完成时,必须使所有的数据都保持一致状态。

- 隔离性(Isolation):保证事务在不受外部并发操作影响的独立环境下运行。

- 持久性(Durability):事务一旦提交或回滚,它对数据库中的数据的改变就是永久的。

- 事务并发的问题:

| 问题 | 描述 |

|---|---|

| 脏读 | 一个事务读到另外一个事务还没有提交的数据。 |

| 不可重复读 | 并发更新时,另一个事务前后查询相同数据时的数据不符合预期。 |

| 幻读 | 并发新增、删除这种会产生数量变化的操作时,另一个事务前后查询相同数据时的不符合预期 |

- 事务的并发解决方案:对事务进行隔离

| 隔离级别 | 脏读 | 不可重复读 | 幻读 |

|---|---|---|---|

| Read Uncommitted 读未提交:可以直接读取到其他事务未提交的事务 | × | × | × |

| Read Committed 读已提交:要等待其他事务提交后才能读取 | √ | × | × |

| Read Repeatable 可重复读 (默认) :通过MVCC机制确保一个事务内多次执行相同的查询会得到相同的结果 | √ | √ | × |

| Serializable 串行化:加入读锁,阻塞式处理事务 | √ | √ | √ |

长事务可能会导致哪些问题?

会有性能问题,具体如下:

- 锁定资源:可能会占用大量的锁资源。

- 死锁(Deadlock):存在两个或更多事务互相等待对方释放资源。

- 内存消耗:长事务占用较多的内存资源,特别是回滚段(undo segment)的空间,从而影响系统的性能。

- 日志文件增长:长事务会导致日志文件快速增长,这需要更多的磁盘空间,并且在恢复时需要更多的时间。

底层原理:TRANSACTION语法的意义

START TRANSACTION;

当执行 START TRANSACTION; 命令时,MySQL 将当前的会话设置为非自动提交模式。这意味着任何随后的 SQL 操作都不会自动持久化到磁盘上,而是保存在事务的内存缓冲区中。在这个阶段,数据库会记录每一步操作的日志到redo log和undo log中,以备提交或回滚。

底层原理:

- 事务开启:创建一个事务记录,并初始化事务的状态为活动状态。

- 非自动提交模式:**设置会话的自动提交标志为

false**,这样后续的 SQL 操作不会立即生效。 - 记录日志:对于每一个 SQL 操作,都会记录对应的重做日志(Redo Log),用于事务提交时的数据恢复。

COMMIT;

执行 COMMIT; 命令表示事务已经成功完成,所有的事务操作都应该被永久地保存到数据库中。此时,数据库将确保所有事务中的更改都已正确地应用,并且任何后续的操作都不能影响到这些更改。

底层原理:

- 事务提交:事务进入提交阶段,数据库系统会将事务中的所有更改标记为永久有效。

- 写入磁盘:将事务期间记录的所有重做日志(redo Log)写入到磁盘上的日志文件中,确保即使在系统崩溃的情况下也能恢复数据。

- 释放资源:事务完成后,释放事务期间占用的资源,如锁定的行或表等。

- 通知监听器:事务提交后,可能会通知正在等待该事务完成的其他事务或监听器。

ROLLBACK;

执行 ROLLBACK; 命令表示事务中的所有操作都将被撤销,数据库将回到事务开始前的状态。这意味着事务中所做的任何更改都不会被保存到数据库中。

底层原理:

- 事务回滚:事务进入回滚阶段,数据库系统会恢复到事务开始前的状态。

- 撤销更改:通过事务日志(undo Log)来撤销事务期间所做的更改。

- 释放资源:事务回滚后,同样会释放事务期间占用的资源,如锁定的行或表等。

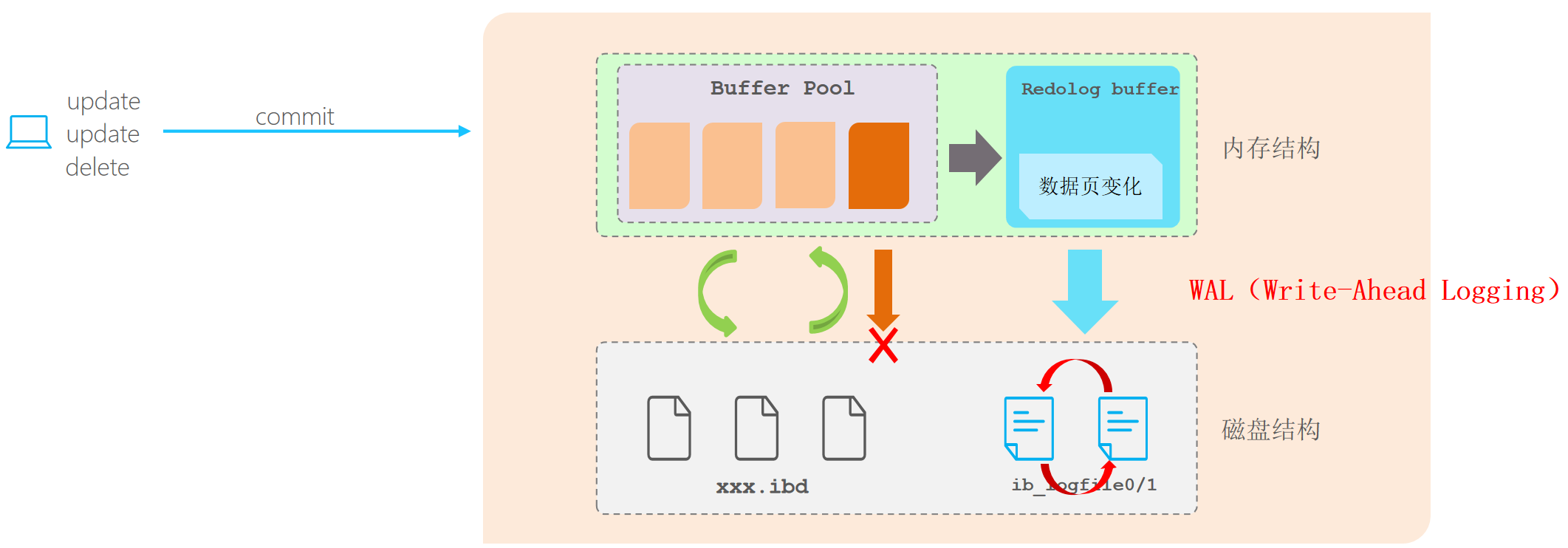

WAL

WAL(预写日志,Write-Ahead Logging)是一种数据保护机制,它在对数据进行实际写操作之前,先将这些操作记录到日志文件中,确保在数据库对外部变化(如崩溃、电源中断等)进行恢复时,数据的一致性和持久性。

WAL 的工作过程

- 日志条目的写入:当数据库要进行更改时,不是直接更改数据文件,而是先将这些更改记录到 WAL 文件中。只有在这些日志条目已经安全地存储到磁盘之后,数据库才会开始更新实际的数据。这种方法允许数据库在意外崩溃之后,通过查阅 WAL 文件来恢复所有未完成的事务,进而恢复到一致的状态。

- 检查点机制:为了保障 WAL 文件不会无限制地增长,数据库会定期创建检查点。这些检查点允许删除旧的 WAL 文件,并减少恢复所需的时间。

WAL 的优点

- 数据恢复:WAL 是保证数据一致性的重要手段。它提供了一种在出现故障时快速恢复数据库的方法。通过读取 WAL 文件,数据库可以重做(redo)在崩溃前进行的所有操作,从而恢复到崩溃时的状态。

- 写性能优化:由于可以将多个更改合并成一个大块进行写入,WAL 有助于优化磁盘写入性能。这减少了对磁盘的频繁小量写操作。

- 异步备份:WAL 文件可以用于进行异步日志传输,提供了数据库的备份和恢复方案,支持只读副本和灾难恢复。

WAL 与 MVCC

- MVCC 机制用来管理并发事务,

- WAL 文件则用来记录事务的更改历史。

在故障恢复时,先使用 WAL 恢复未提交的事务,然后根据 MVCC 的版本控制进行数据的回滚。

MVCC

MVCC是如何保证数据的可恢复性的?

MVCC需要保障如下两条原则:

正在进行的事务不会读取未提交的事务产生的数据。

正在进行的事务不会修改未提交的事务修改或产生的数据。

于是,MVCC就通过如下步骤实现了数据回滚:

MVCC通过维护每个事务的开始时间和版本号来判断是否需要回滚。当事务试图读取或修改数据时,系统会比较当前数据版本与事务的开始时间。如果事务尝试访问的版本在其开始时间之后已被其他事务提交,那么该事务会被标记为需要回滚,因为它基于过时的数据进行操作。这种机制确保了数据的一致性和隔离性。

行的可见性判定

每一行都有两个特殊的字段:

xmin:创建这个行的事务 IDxmax:删除/更新它的事务 ID

当一个事务读取数据时,它会根据 xmin 和xmax 判断当前事务的可见性。

那么一条记录什么时候是可见的呢?

满足如下两个条件:

xmin对应的事务已经提交xmax对应的事务未提交或未开始

什么是事务日志 / redo log,undo log?

总结:

1 | redo log: 记录的是数据页的物理变化,服务宕机可用来同步数据 |

redo log:重做日志,确保了已提交的事务在数据库崩溃重启后,能够保持数据的持久性和一致性。redo log是物理日志,它包含以下两种类型的信息:

- 物理页的变化:某些数据库系统(如Oracle)可能直接记录数据页变化后的状态。这意味着在重做日志中,你会看到一个数据页在某次操作之后的样子。

- 操作的描述:另一些数据库系统(如MySQL的InnoDB存储引擎)则记录了如何重做某个特定操作的信息,即记录了需要对哪些页进行什么样的更新才能重现这些页在事务提交后的状态。

undo log:回滚日志,确保了未提交的事务在数据库崩溃重启后,不会对数据库的数据造成影响,实现隔离性。此外在可重复读取隔离等级下,undo log 还可以维持读取视图的一致性,即保证同一个查询在事务内多次执行时返回相同的结果。undo log是逻辑日志,它的基本结构特点如下:

- 版本链(Version Chain):

- 在 InnoDB 存储引擎中,每个数据页都有一个版本链,其中包含了该页上所有行的多个版本。这些版本信息是由 Undo Log 维护的。

- 重做片段(Undo Segments):

- Undo Log 通常被组织成 Undo Segments,每一个 Undo Segment 包含一个或多个 Undo Records。Undo Segments 可以进一步分为两类:Insert Undo Segments 和 General Undo Segments。

- Insert Undo Segments 主要用于插入操作的事务,当事务只包含插入操作时,可以使用 Insert Undo Segments。一旦事务提交,这部分 Undo Log 就不再需要,可以被重用。

- General Undo Segments 用于包含删除、更新等操作的事务,这类事务提交后,Undo Log 需要保留一段时间,直到不再有活跃事务需要访问这些旧版本。

- Undo Log 通常被组织成 Undo Segments,每一个 Undo Segment 包含一个或多个 Undo Records。Undo Segments 可以进一步分为两类:Insert Undo Segments 和 General Undo Segments。

- 重做记录(Undo Records):

- 每个 Undo Record 包含了数据项在某个时间点的值,以及指向其前后版本的指针。这样可以构建出一个版本链,用于追踪数据项的历史版本。

- 回滚指针(Rollback Pointer):

- 每个事务都有一个 Rollback Pointer 指向 Undo Log 中的一个位置,这个位置标识了事务开始时的数据状态。当事务需要回滚时,系统可以根据 Rollback Pointer 从该位置开始恢复数据到事务开始前的状态。

- 时间戳(Timestamps):

- Undo Log 中还包括时间戳信息,这有助于判断版本的有效性,特别是在 MVCC 环境下,用于决定哪个版本对于给定的查询是可见的。

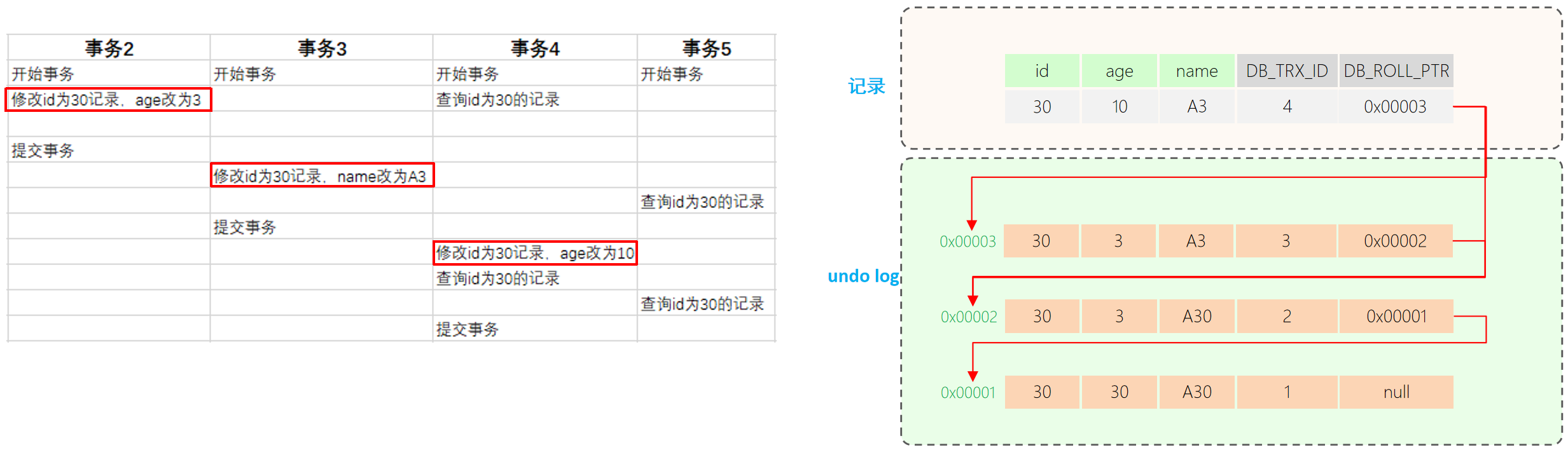

MVCC 实现一致性和隔离性的原理

MVCC机制下一条记录会有多个版本,每次修改记录都会存储这条记录被修改之前的版本。多版本之间串联起来就形成了一条版本链,这样不同时刻启动的事务可以无锁地获得不同版本的数据(普通读)。此时读(普通读)写操作不会阻塞,写操作可以继续写,无非就是多加了一个版本,历史版本记录可供已经启动的事务读取。

这一切的实现主要依赖于每条记录中的隐式字段、undo log日志、ReadView。

1. 隐式字段

| 隐藏字段 | 含义 |

|---|---|

| DB_TRX_ID | 最近修改事务ID,记录插入这条记录或最后一次修改该记录的事务ID。 |

| DB_ROLL_PTR | 回滚指针,指向这条记录的上一个版本,用于配合undo log,指向上一个版本。 |

| (DB_ROW_ID) | (隐藏主键,如果表结构没有指定主键,将会生成该隐藏字段。) |

2. undo log

回滚日志,在insert、update、delete的时候产生的便于数据回滚的日志。

undo log版本链:不同事务或相同事务对同一条记录进行修改,会导致该记录的undo log生成一条记录版本链表,链表的头部是最新的旧记录,链表尾部是最早的旧记录

3. ReadView 读取视图

ReadView解决了一个事务查询选择版本的问题,根据ReadView的匹配规则和当前的一些事务id判断该访问那个版本的数据。

ReadView是一个事务在开始时可见的数据快照。每当一个事务启动时,系统会创建一个ReadView,记录当前活跃事务的列表和事务的时间戳。通过这个视图,事务可以访问在其开始时已经提交的版本,而忽略后续提交的变更。这确保了事务的隔离性,使得它在执行过程中看到的数据始终保持一致,避免了幻读和脏读问题。

不同的隔离级别快照读:RC(读已提交):每一次执行快照读时生成ReadView、RR(可重复读):仅在事务中第一次执行快照读时生成ReadView,后续复用。

工作过程:快照读SQL执行时MVCC提取数据的依据,记录并维护系统当前活跃的事务(未提交的)id。

当前读:写操作时(update、insert、delete(排他锁),select … lock in share mode(共享锁),select … for update),读取的是记录的最新版本,读取时会对读取的记录进行加锁,保证其他并发事务不能修改当前记录。

快照读:select时,非阻塞式地读取记录数据的可见版本,有可能是历史数据。

- Read Committed:每次执行select,都生成一个快照读,这个新生成的快照读可能会造成不可重复读。

- Repeatable Read(默认):仅在事务开始时生成ReadView,后续复用。

ReadView是一个数据结构,包含了四个核心字段:

字段 含义 m_ids 当前活跃的事务ID集合 min_trx_id 最小活跃事务ID max_trx_id 预分配的事务ID,当前最大事务ID+1 creator_trx_id ReadView创建者的事务ID

—————————————

分布式数据库

数据库集群

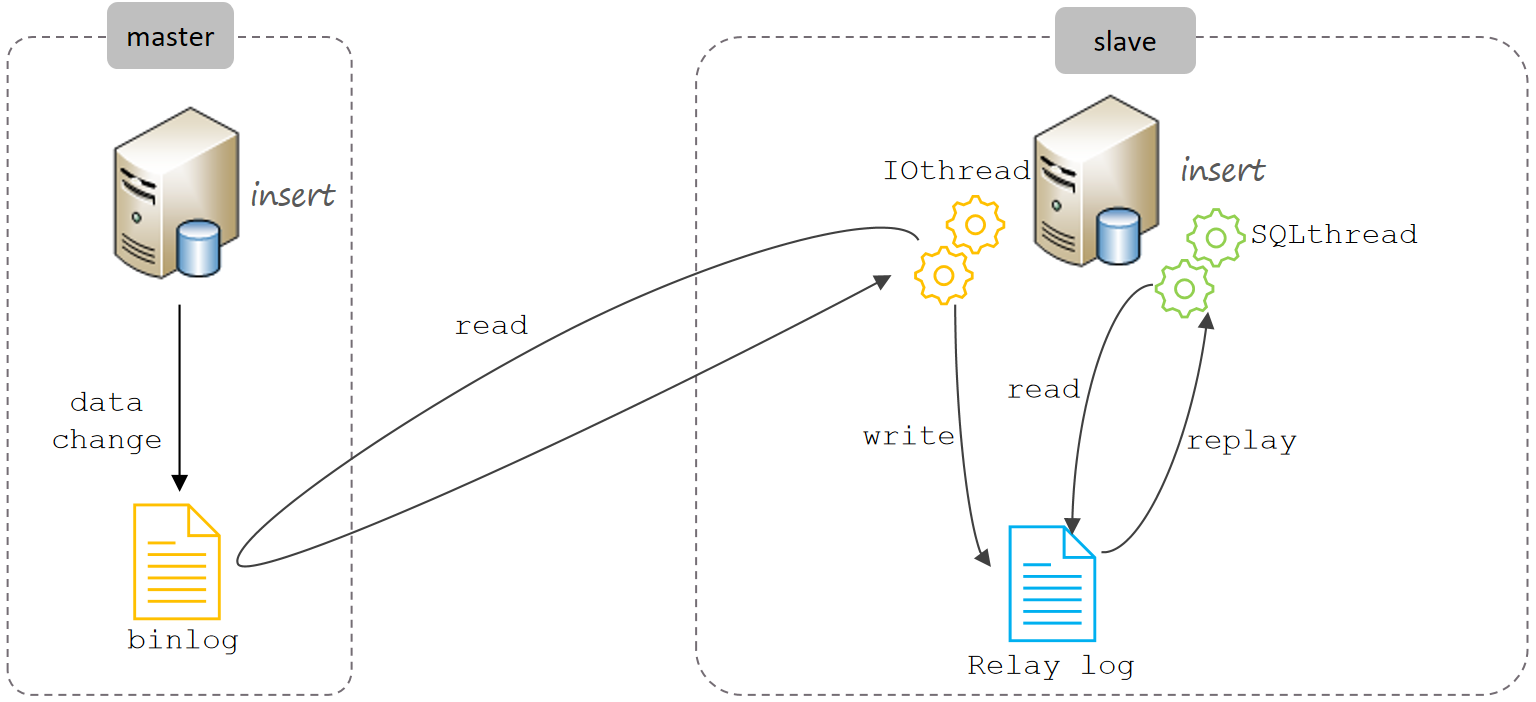

主从同步的原理

主从复制的核心就是二进制日志

主从复制步骤:

- Master 主库在事务提交时,会把数据变更记录在二进制日志文件Binlog中。

- 从库读取主库的二进制日志文件Binlog,写入到从库的中继日志Relay Log。

- Slave重做中继日志中的事件,将改变反映它自己的数据。

如何保证主从的数据一致性?

- 利用读写分离框架特性,如ShardingJDBC可以要求下一条SELECT强制走主库。但会增大主库压力,可能出现性能瓶颈。

- 采用MGR(MySQL Group Replication)全同步复制,强一致数据同步没完成主从同步之前,jdbc.insert()方法无法得到结果新项目推荐:无需改代码,真正的一致性方案,老项目不推荐,传统应用集群向MGR迁移成本高、风险大

分库分表时机

- 项目业务数据逐渐增多,或业务发展比较迅速

- 优化已解决不了性能问题(主从读写分离、查询索引…)

- IO瓶颈(磁盘IO、网络IO)、CPU瓶颈(聚合查询、连接数太多)

分表分库策略

- 垂直分库,根据业务进行拆分,高并发下提高磁盘IO和网络连接数

- 垂直分表,冷热数据分离,多表互不影响

- 水平分库,将一个库的数据拆分到多个库中,解决海量数据存储和高并发的问题

- 水平分表,解决单表存储和性能的问题

分库

分库(Database Sharding)是指将一个大的数据库拆分成多个小的数据库,每个数据库称为一个“分片”(Shard)。每个分片包含部分数据,通过某种策略将数据分布到不同的分片中。

分库策略

- 范围分片:根据某个字段的值范围进行分片,例如按用户 ID 的范围。

- 哈希分片:根据某个字段的哈希值进行分片,例如按用户 ID 的哈希值。

- 列表分片:根据某个字段的具体值进行分片,例如按城市名称。

分库的实现方式

- 应用层分片:在应用层实现分片逻辑,通过路由算法将请求分发到不同的数据库分片。

- 中间件分片:使用数据库中间件(如 MyCAT、ShardingSphere)来管理分片,提供透明的分片和路由功能。

优点、缺点

提高性能:通过将数据分散到多个数据库中,可以减少单个数据库的负载,提高查询和写入性能。

增加可伸缩性:可以轻松地通过增加更多的分片来扩展系统。

提高可用性:即使某个分片出现故障,其他分片仍然可以正常工作,提高了系统的可用性。

复杂性增加:需要管理多个数据库实例,增加了系统的复杂性。

跨分片查询:跨分片的查询和事务管理更加复杂,可能需要额外的中间件支持。

数据迁移:随着数据量的增长,可能需要重新分片,数据迁移和维护成本较高。

分表

分表(Table Partitioning)是指将一个大的表拆分成多个小的表,每个小表称为一个“分区”(Partition)。每个分区包含部分数据,通过某种策略将数据分布到不同的分区中。

分表策略

- 范围分区:根据某个字段的值范围进行分区,例如按日期范围。

- 列表分区:根据某个字段的具体值进行分区,例如按地区代码。

- 哈希分区:根据某个字段的哈希值进行分区,例如按用户 ID 的哈希值。

- 复合分区:结合多种分区策略,例如先按日期范围分区,再按地区代码分区。

分表的实现方式

- 物理分区:在数据库中创建多个物理表,每个表存储部分数据。

- 逻辑分区:使用数据库的分区功能(如 PostgreSQL 的表分区、MySQL 的分区表)来创建逻辑分区。

优点、缺点

提高查询性能:通过将数据分散到多个分区中,可以减少单个分区的数据量,提高查询性能。

优化存储:可以将冷数据和热数据分开存储,优化存储空间和访问效率。

简化维护:可以单独对某个分区进行维护操作,如备份、索引重建等。

复杂性增加:需要管理多个表分区,增加了系统的复杂性。

跨分区查询:跨分区的查询和事务管理更加复杂,可能需要额外的优化和索引支持。

分区管理:需要定期维护分区,例如添加新的分区、删除旧的分区等。

分片

分片(Database Sharding)涵盖了分库和分表的概念。分片是指将数据分散到多个节点或分区中,每个节点或分区包含部分数据,通过某种策略将数据分布到不同的节点或分区中。

分片的类型

- 水平分割:数据库分片是指将数据库中的数据水平地分割成多个部分,并将这些部分分布到不同的物理数据库服务器上。这意味着每台服务器上只存储一部分数据,而不是全部数据。

- 垂直分割:与水平分割相对的是垂直分割(Vertical Partitioning),即将不同的表分割到不同的服务器上。然而,垂直分割通常不是我们讨论的“分片”的主要内容,而是另一种优化策略。

分片的目的

- 提高性能:通过将数据分布在多个服务器上,可以并行处理更多的请求,从而提高整体性能。

- 负载均衡:分片可以将负载均衡到多个服务器上,避免单点过载。

- 提高可用性:如果一个分片服务器宕机,其他分片服务器仍然可以继续提供服务,提高了系统的可用性。

- 数据地理分布:分片还允许将数据存储在不同的地理位置,以减少延迟并满足数据驻留法规要求。

分片的实现方式

- 应用层分片:在应用层实现分片逻辑,通过路由算法将请求分发到不同的节点或分区。

- 中间件分片:使用数据库中间件(如 MyCAT、ShardingSphere)来管理分片,提供透明的分片和路由功能。

分片带来的挑战

- 数据一致性:在分布式环境中,保持数据的一致性是一个挑战,需要使用如分布式事务、分布式锁等技术来保证。

- 数据迁移:当需要增加或移除分片时,涉及到大量的数据迁移工作。

- 查询复杂性:跨分片的查询变得复杂,可能需要在多个分片上执行查询并合并结果。

- 故障恢复:分片系统需要设计有效的故障恢复机制,以确保在某个分片失效时系统仍然可以正常运行。

分库、分表、分片的示例

分库示例

假设你有一个电商系统,用户分布在不同的城市。可以按城市进行分库:

- 数据库1:北京用户

- 数据库2:上海用户

- 数据库3:广州用户

分表示例

假设你有一个订单表,订单数据按日期进行分表:

- 订单表1:2023年1月的数据

- 订单表2:2023年2月的数据

- 订单表3:2023年3月的数据

分片示例

假设你有一个全球用户系统,用户分布在不同的国家和地区。可以按国家和城市进行分片:

- 分片1:中国北京用户

- 分片2:中国上海用户

- 分片3:美国纽约用户

- 分片4:英国伦敦用户

总结

- 分库:适用于大规模数据和高并发场景,通过将数据分散到多个数据库中,提高系统的可伸缩性和性能。

- 分表:适用于单个表数据量过大的场景,通过将数据分散到多个表中,提高查询性能和存储效率。

- 分片:涵盖了分库和分表的概念,通过将数据分散到多个节点或分区中,提高系统的性能和可伸缩性。

怎么设计数据库分片?

分片键

确定分片键(Sharding Key),这将决定数据如何分配到不同分片。

常见的分片键包括:

- 用户ID:适用于社交网络、电子商务等场景。

- 地理位置:适用于需要根据地理位置存储数据的应用。

- 时间戳:适用于日志记录、历史数据存储等场景。

分片算法

根据选定的分片键,设计分片算法。

常见的分片算法包括:

范围分片:根据某个字段的值范围进行分片,例如按用户 ID 的范围。

- 数据根据某个字段(如用户ID)的值范围分配到不同的分片上。

- 优点是可以根据数据的自然分布来进行分片,易于理解和实现。

- 缺点是如果数据分布不均,可能导致某些分片负载过高。

哈希分片:根据某个字段的哈希值进行分片,例如按用户 ID 的哈希值。

- 数据根据一个或多个字段的哈希值分配到不同的分片上。

- 优点是哈希值的均匀分布可以较好地平衡各分片的负载。

- 缺点是当增加或移除分片时,需要重新哈希分配数据,可能导致大规模的数据迁移。

列表分片:根据某个字段的具体值进行分片,例如按城市名称。

复合分片:结合多种分片策略,例如先按日期范围分片,再按地区代码分片。

一致性哈希算法

一种特殊的哈希分片算法,用于解决哈希分片在动态调整分片数量时的问题。

通过虚拟节点来模拟环形拓扑结构,使得在添加或移除分片时,只需要重新分配受影响的数据部分。

如何保证数据的分布一致性?

数据映射规则

需要定义一个映射规则,将数据映射到具体的分片上。

例如,可以使用模运算来实现哈希分片:

1 | int shardId = userId.hashCode() % numberOfShards; |

分片存储

每个分片存储在不同的数据库实例上,需要确保每个实例上的数据是相互独立的。可以使用如下方法来实现:

- 使用不同的数据库实例:每个分片对应一个数据库实例。

- 使用同一个数据库实例的不同表或Schema:适合数据量不大,且对性能要求不高的场景。

如何保证分片数据的一致性?

分布式事务

分片后,跨分片的事务处理变得更加复杂。需要使用分布式事务来保证数据的一致性。常用的方法包括:

- 两阶段提交(Two-Phase Commit, 2PC):协调多个分片上的事务。

- 三阶段提交(Three-Phase Commit, 3PC):在2PC的基础上增加了预准备阶段,提高了可靠性。

- 最终一致性(Eventual Consistency):通过消息队列或事件驱动的方式,在事务完成后异步同步数据。

分布式锁

在并发场景下,需要使用分布式锁来保证数据的一致性。常用的技术包括:

- ZooKeeper:提供分布式锁服务。

- Redis:使用Redis的SETNX等命令实现分布式锁。

数据同步

对于需要实时同步的数据,可以使用以下方法:

- 主从复制(Master-Slave Replication):将数据从主分片复制到其他分片。

- 异步消息队列:使用Kafka、RabbitMQ等消息队列进行数据同步。

————————————

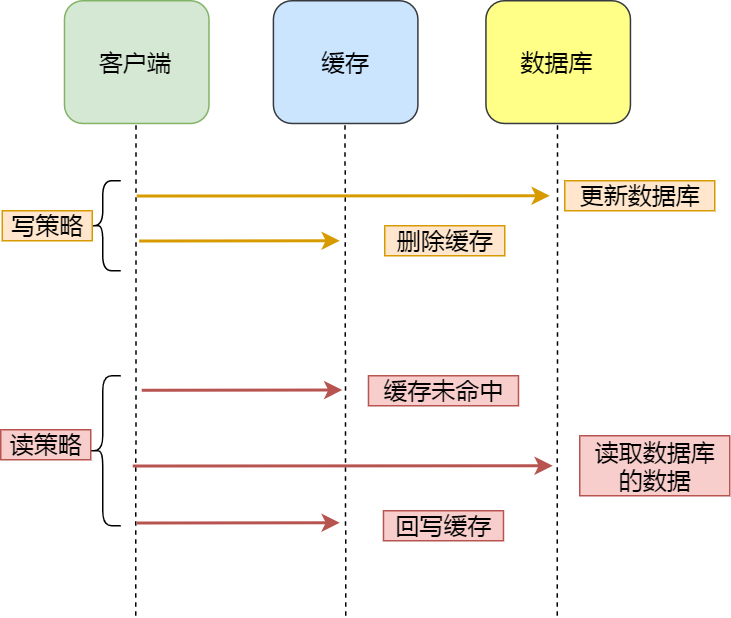

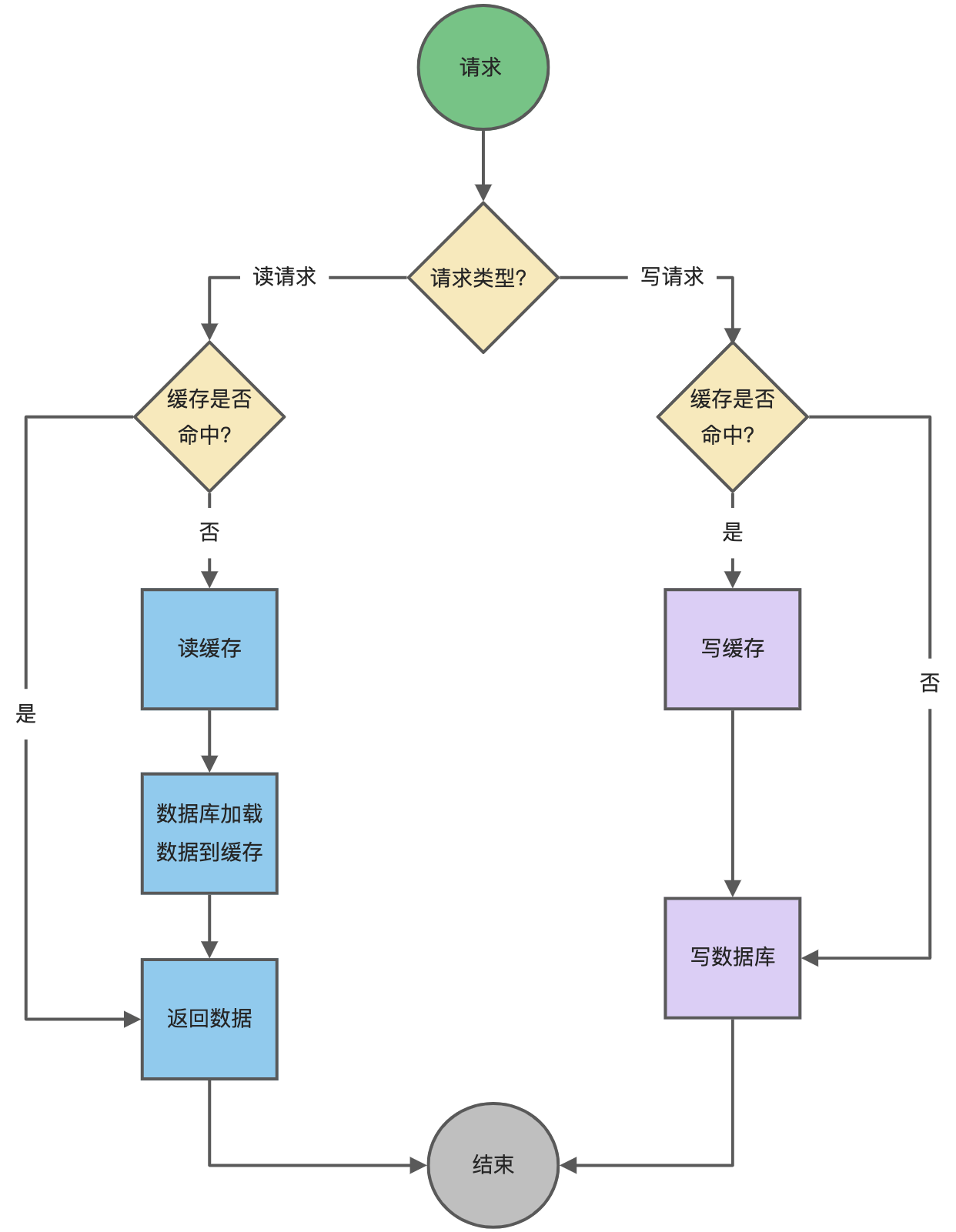

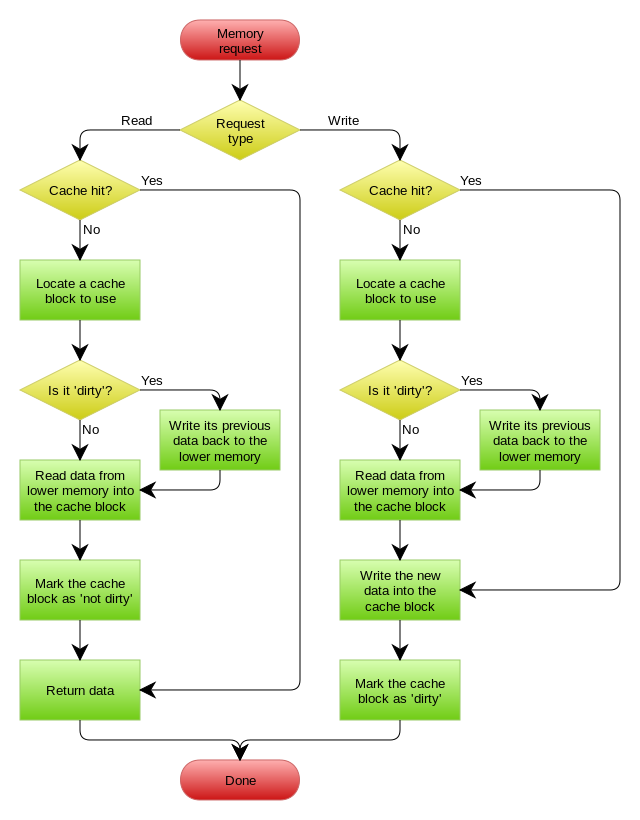

#缓存

缓存是一种用于提高数据访问速度和系统性能的技术。通过将频繁访问的数据存储在内存或其他快速访问介质中,缓存可以显著减少数据访问的延迟和减轻后端系统的负载。

常见的缓存类型

内存缓存

- Redis:一个高性能的键值存储系统,支持多种数据结构(如字符串、哈希、列表、集合等),广泛用于缓存和会话管理。

- Memcached:一个高性能的分布式内存对象缓存系统,主要用于加速动态Web应用程序。

文件缓存

- 本地文件系统:将数据缓存到本地文件系统中,适用于静态内容的缓存。

- 分布式文件系统:如 HDFS(Hadoop Distributed File System),用于大规模数据存储和缓存。

数据库缓存

- 查询缓存:数据库系统内部的缓存机制,用于缓存查询结果,减少对磁盘的访问。

- 结果集缓存:将查询结果缓存到内存中,减少对数据库的访问次数。

应用程序缓存

- 本地缓存:应用程序内部的缓存,通常使用 HashMap 或其他数据结构实现。

- 分布式缓存:使用分布式缓存系统(如 Redis、Memcached)在多个应用程序实例之间共享缓存数据。

更新策略

- 写穿策略:每次写操作都同时更新缓存和后端数据源。

- 读穿策略:每次读操作都先检查缓存,如果未命中则从后端数据源获取数据并更新缓存。

- 写回策略:写操作只更新缓存,定期或在某些条件下将缓存中的数据同步到后端数据源。

- 刷新策略:定期或在某些条件下清空缓存,强制从后端数据源重新加载数据。

失效策略

- 时间失效:设置缓存数据的有效时间,超过时间后自动失效。

- 容量失效:当缓存达到最大容量时,使用 LRU(最近最少使用)、LFU(最不经常使用)等算法移除一些数据。

- 显式失效:应用程序显式地从缓存中移除数据,通常在数据更新时使用。

应用场景

- 网页缓存:缓存静态内容(如 HTML、CSS、JavaScript 文件),减少服务器负载,提高页面加载速度。

- 数据库查询缓存:缓存数据库查询结果,减少对数据库的访问次数,提高查询性能。

- API 响应缓存:缓存 API 响应,减少后端服务的调用次数,提高 API 响应速度。

- 会话缓存:缓存用户会话信息,提高用户会话管理的性能。

- 全文搜索缓存:缓存搜索结果,提高搜索性能。

最佳实践

- 合理设置缓存时间:根据数据的更新频率和重要性,合理设置缓存的有效时间。

- 使用缓存预热:在系统启动或高峰期前,预先加载常用数据到缓存中。

- 缓存降级:在缓存失效或不可用时,提供合理的降级策略,确保系统仍能正常运行。

- 监控和告警:监控缓存系统的状态,设置告警机制,及时发现和处理问题。

- 数据一致性管理:使用合理的缓存更新和失效策略,确保缓存数据和后端数据源的一致性。

优点、缺点

提高性能:通过减少对后端系统的访问次数,提高数据访问速度和系统性能。

减轻负载:减少后端系统的负载,提高系统的可用性和稳定性。

提高用户体验:加快数据访问速度,提升用户的使用体验。

节省资源:减少对计算和网络资源的消耗,降低运营成本。

数据一致性问题:缓存数据和后端数据源之间的数据一致性难以保证,可能导致数据不一致的问题。

复杂性增加:引入缓存机制会增加系统的复杂性,需要管理和维护缓存系统。

内存占用:缓存数据占用内存,如果管理不当可能导致内存溢出等问题。

缓存击穿:大量请求同时访问同一个缓存数据,导致缓存失效后的瞬间大量请求涌入后端系统,造成后端系统压力过大。

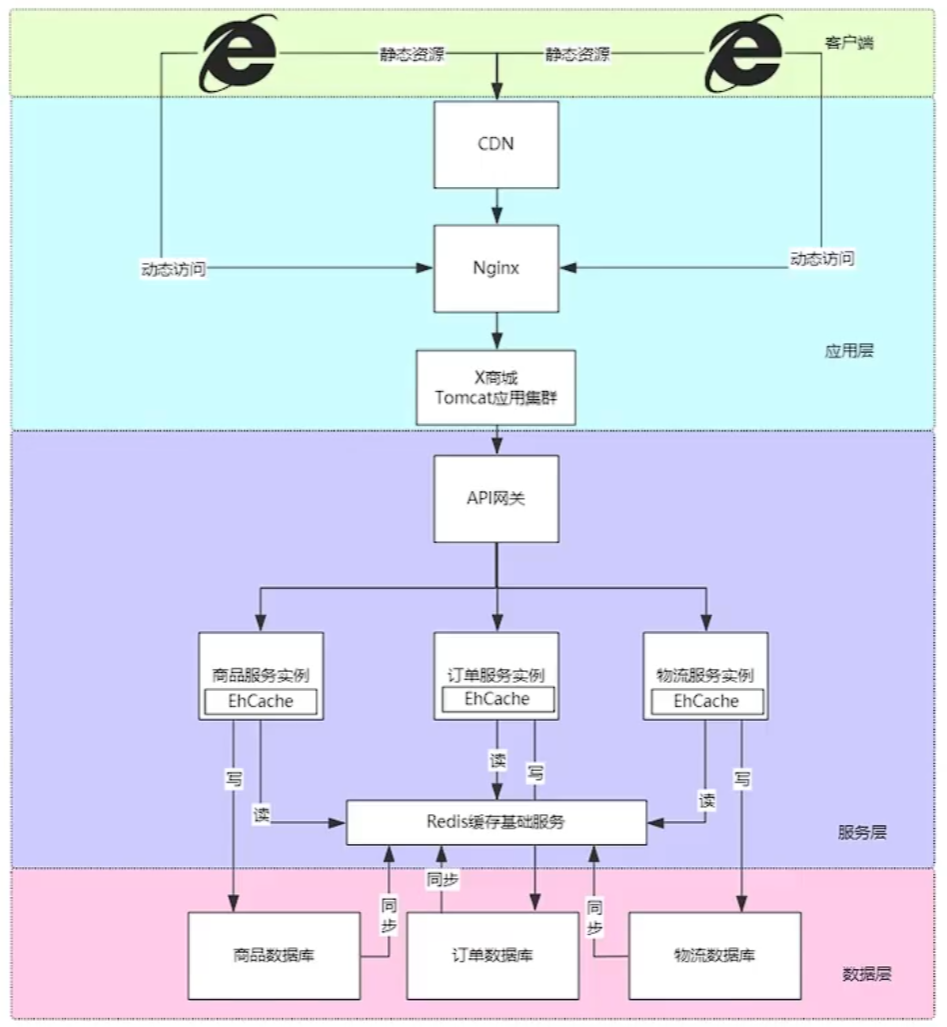

多级缓存架构

缓存是提升性能最直接的方法 多级缓存分为:客户端,应用层,服务层,数据层

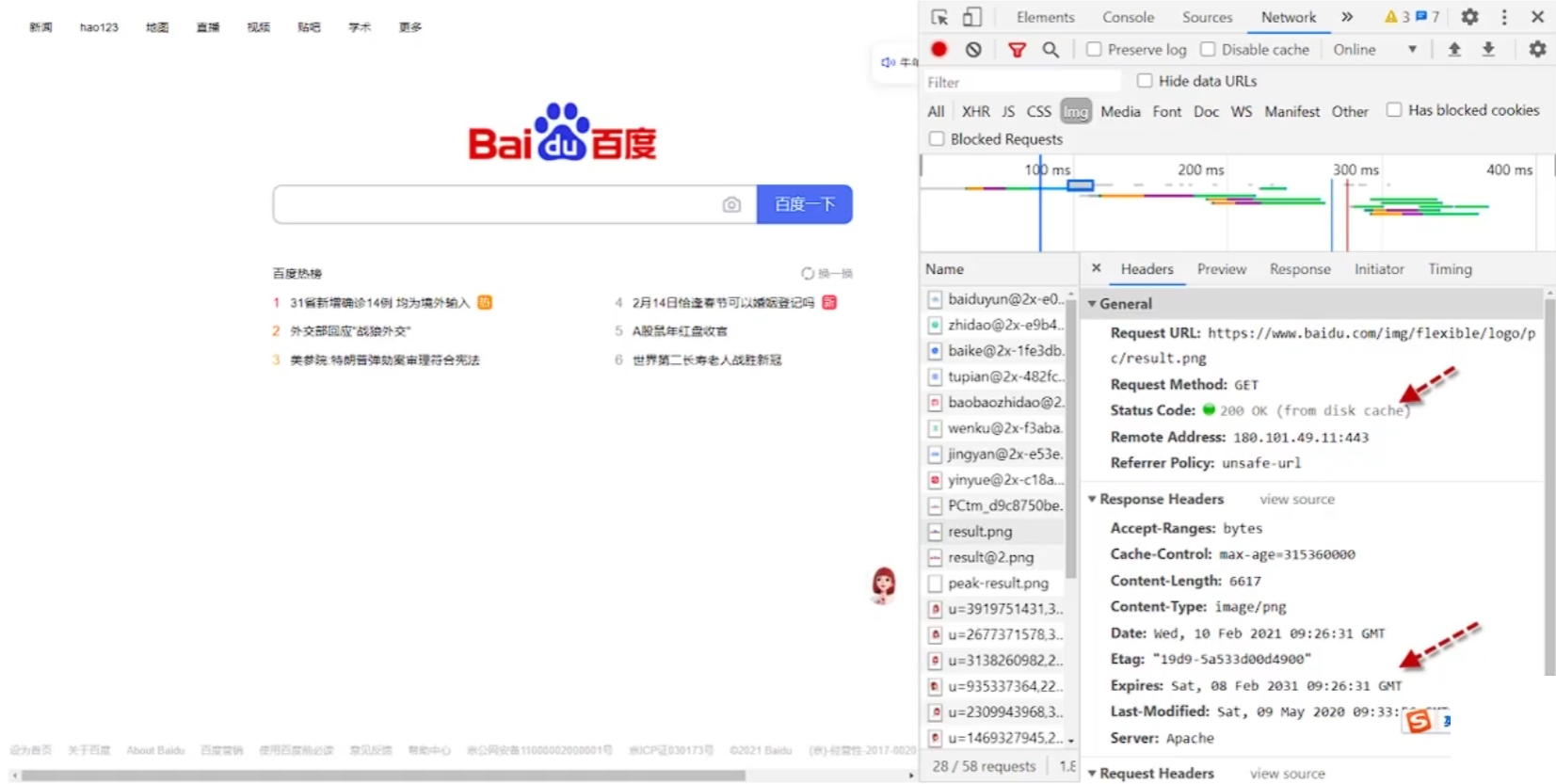

客户端缓存

客户端缓存:主要对浏览器的静态资源进行缓存 通过在浏览器设置Expires,时间段内以文件形式把图片保存在本地,减少多次请求静态资源带来的带宽损耗(解决并发手段) 。

例如:百度的logo,可以给logo设置一个过期时间,第一次请求时缓存logo图片和过期时间,之后每次请求时都查看过期时间,如果还没过期就从磁盘读取。

应用层缓存

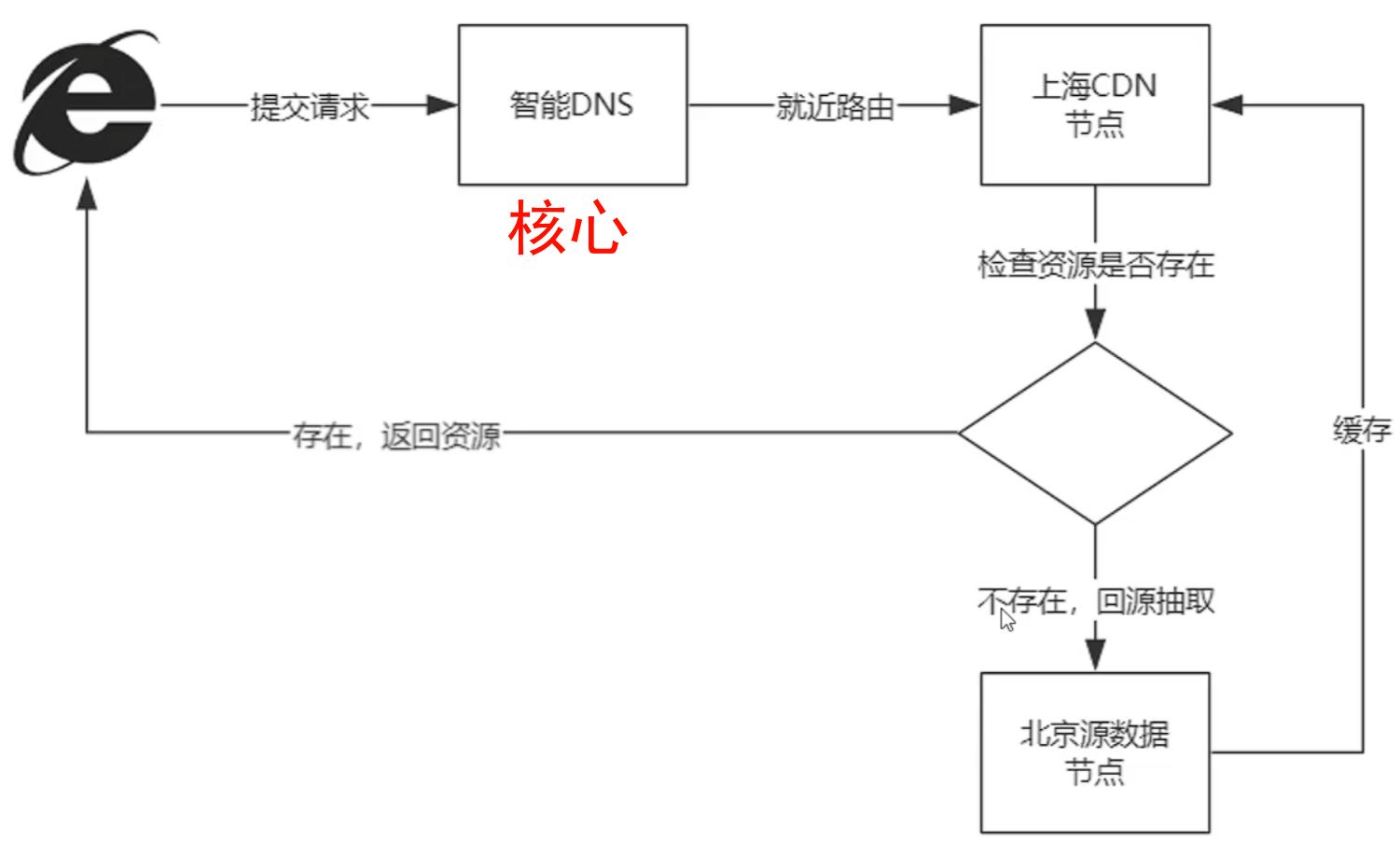

CDN(重量级)

CDN内容分发网络是静态资源分发的主要技术手段,有效解决带宽集中占用以及数据分发问。

CDN是一项基础设施,一般由云服务厂商提供。

CDN的核心技术: 根据请求访问DNS节点, 自动转发到就近CDN节点,检查资源是否被缓存,若已缓存则返回资源否则回源数据节点提取,并缓存到就近CDN节点,再由就近CDN节点进行返回。

CDN的使用(aliyun):

响应头Expires和Cache-control的区别:

- 均为通知浏览器进行文件缓存

Expires指在缓存的过期时间Cache-control指缓存的有效期

响应头的设置:Expires 设置时间,Cache-Control 设置时长。

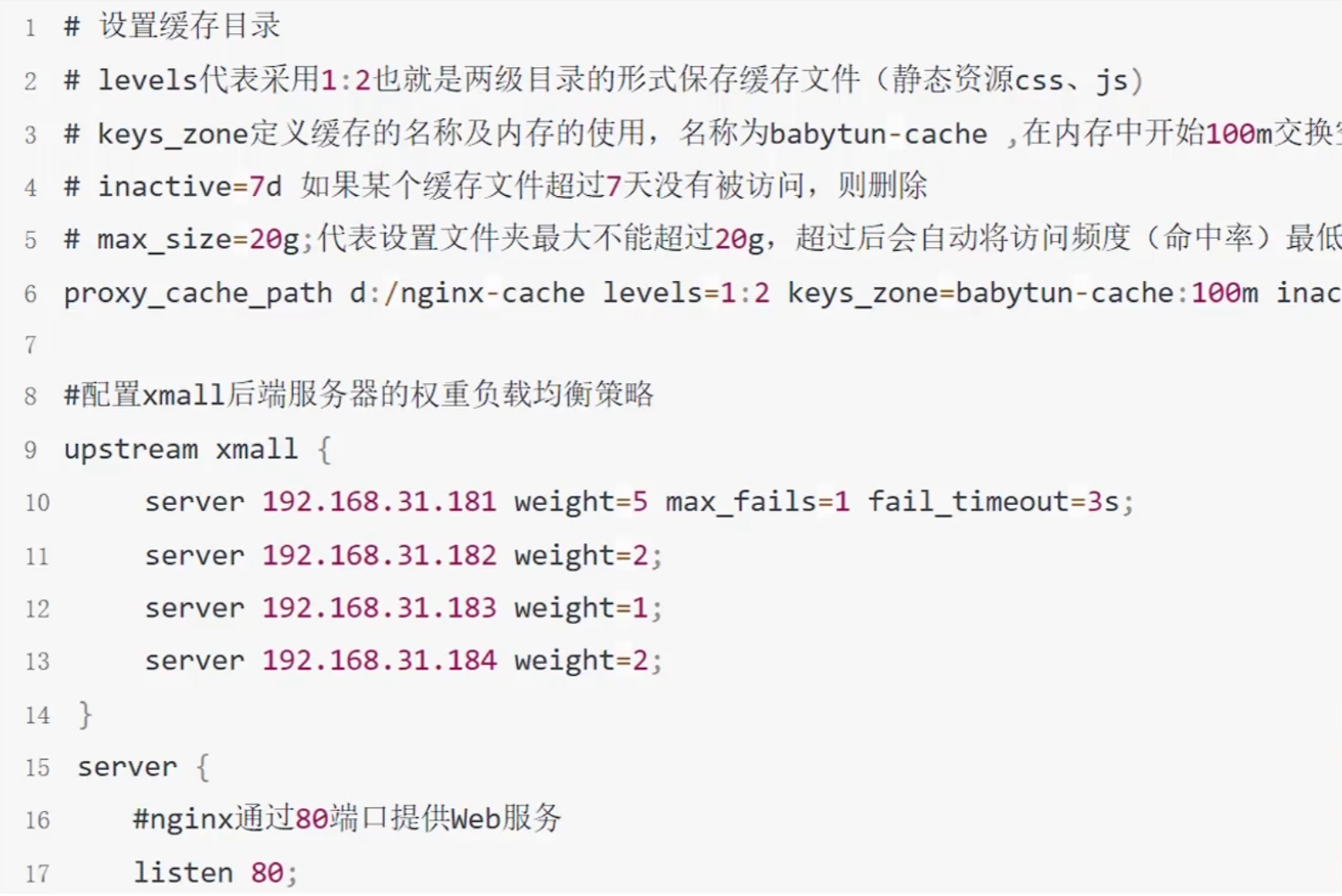

Nginx(轻量级)

Nginx对Tomcat集群做软负载均衡,提供高可用性。有静态资源缓存和压缩功能(在本地缓存文件)

服务层缓存

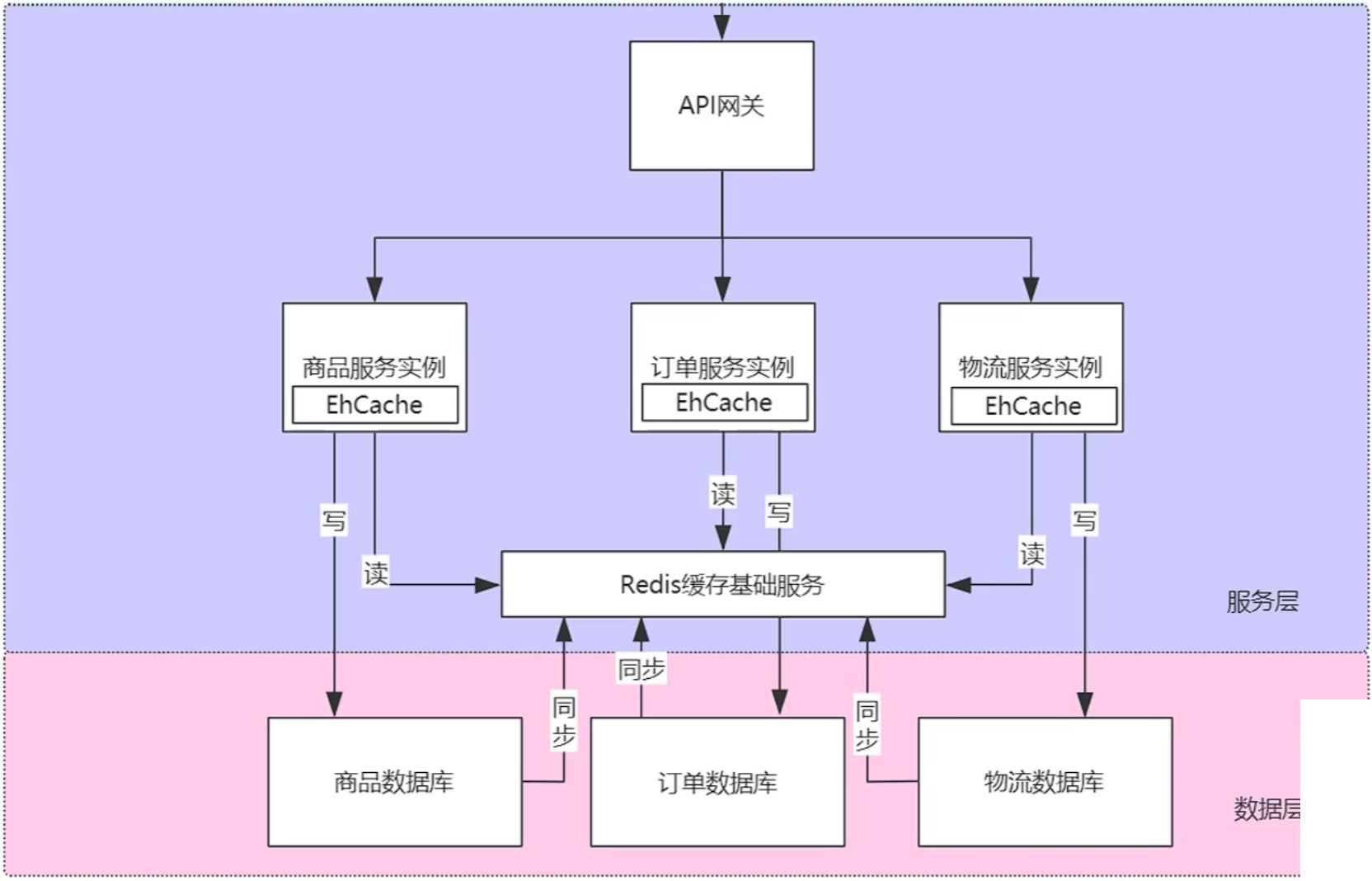

服务层缓存:进程内缓存和进程外缓存

- 进程内缓存:在应用程序的内存中,数据运行时载入程序开辟的缓存,存储在应用程序进程内部,访问速度非常快,因为它不需要通过网络或其他进程间通信机制来访问数据。

- 开源实现:HashMap、EhCache、Caffeine、Hibernate一二级缓存、Mybatis一二级缓存,SpringMVC页面缓存

- 进程外缓存:独立于应用程序运行,存储在应用程序进程之外的缓存系统,具备更好的持久性、更高的并发性和更好的伸缩性。进程外缓存可以跨越多个服务器,提供分布式的服务,从而支持更大规模的应用程序。

- 开源实现:Redis、Memcached、Ignite、Hazelcast、Voldemort

数据层缓存

第一种情况,缓存的数据是稳定的。例如:邮政编码、地域区块、归档数据……

第二种情况,瞬时可能会产生极高并发的场景。例如:股市开盘、商品秒杀……

第三种情况,一定程度上允许数据不一致。例如:网站公告……

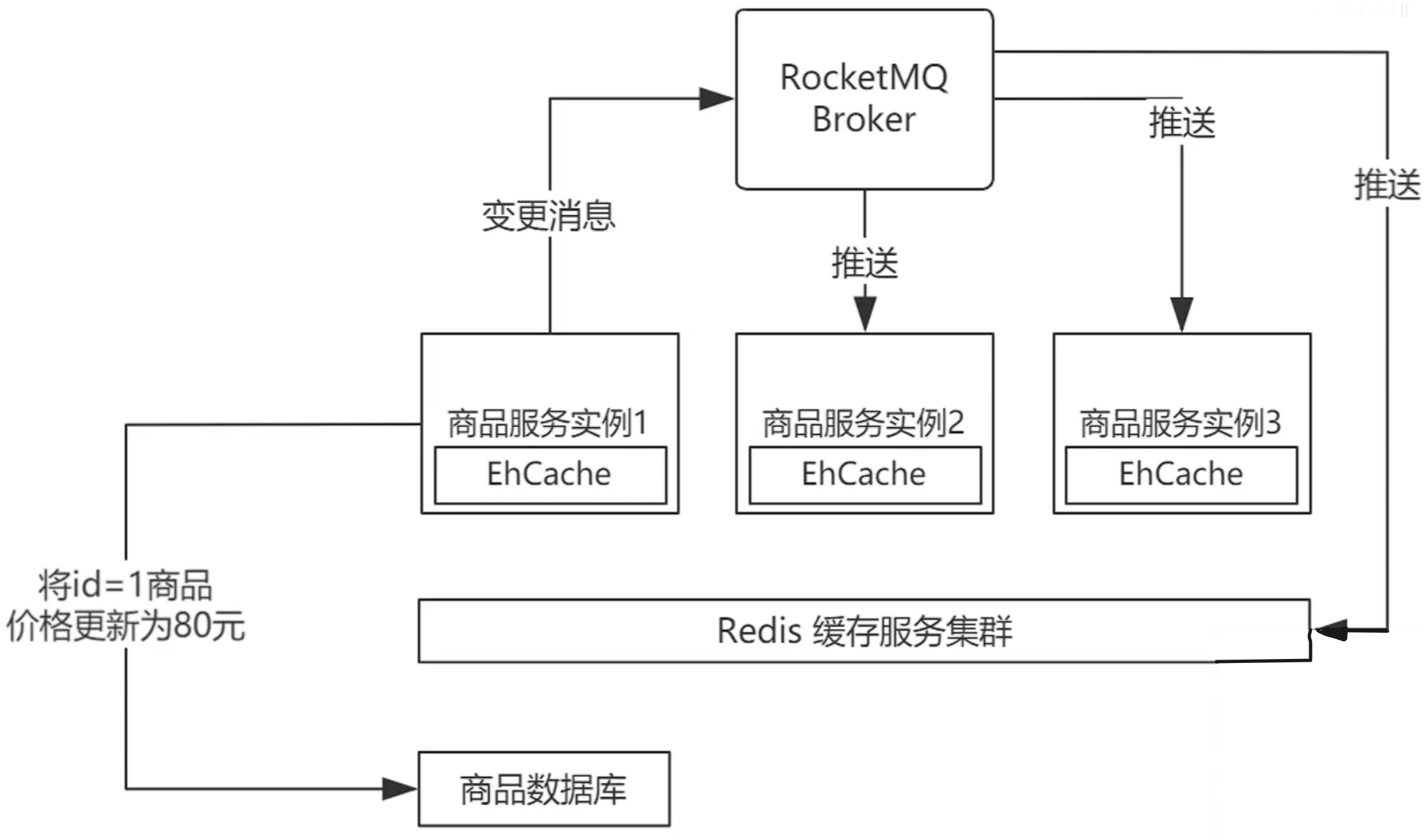

一种数据同步方案:

进程外缓存(SpringCache)

只适合单体项目,遇到分布式,一碰就碎!纯FW!

SpringCache

Spring Cache 是 Spring 框架提供的一个抽象层,用于简化缓存的使用。它提供了一种声明式的方式,在方法调用时自动管理缓存。

特点:

- 声明式缓存:通过注解(如

@Cacheable、@CachePut、@CacheEvict)来管理缓存,无需手动编写缓存逻辑。 - 多种缓存提供商支持:支持多种缓存提供商,如 Redis、Caffeine、EhCache 等。

- 灵活的缓存策略:可以通过配置文件或注解来定义缓存策略,如缓存键生成、缓存失效等。

Caffeine

Caffeine 专注于本地缓存,继承了 Google Guava 缓存的优点,并进行了优化,提供了更好的性能和灵活性。

特点:

- 高性能:使用高效的并发数据结构和算法,提供极高的吞吐量和低延迟。

- 自动内存管理:支持自动清除未使用的缓存项,避免内存泄漏。

- 丰富的缓存策略:支持多种缓存策略,如 LRU(最近最少使用)、LFU(最不经常使用)、TTL(生存时间)等。

EhCache

EhCache 支持本地缓存和分布式缓存,广泛应用于各种企业级应用中,提供高性能的缓存解决方案。

特点:

- 本地缓存:支持内存和磁盘存储,可以灵活配置缓存策略。

- 分布式缓存:支持多种分布式缓存模式,如 RMI、JGroups、Terracotta 等。

- 丰富的配置选项:提供详细的配置选项,如缓存大小、缓存过期时间、缓存策略等。

- 集成广泛:可以与多种框架和工具集成,如 Spring、Hibernate、MyBatis 等。

对比

| 特性/功能 | Caffeine | EhCache |

|---|---|---|

| 类型 | 本地缓存 | 本地缓存 + 分布式缓存 |

| 缓存提供商 | 本地缓存 | 本地缓存 + 分布式缓存 |

| 性能 | 高性能 | 高性能 |

| 配置方式 | 代码 + 配置文件 | 配置文件 |

| 缓存策略 | 多种策略(LRU、LFU、TTL等) | 多种策略(LRU、LFU、TTL等) |

| 集成 | 易于与 Spring 集成 | 广泛集成(Spring、Hibernate等) |

| 分布式支持 | 不支持分布式缓存 | 支持多种分布式缓存模式 |

| 内存管理 | 自动内存管理 | 手动配置内存管理 |

总结

- Caffeine:高性能的本地缓存库,适合对性能要求较高的场景,特别是单机应用。

- EhCache:支持本地缓存和分布式缓存,适合需要分布式缓存支持的企业级应用。

进程内缓存(Redis)

缓存的使用场景

缓存:穿透、击穿、雪崩、双写一致、持久化、数据过期策略,数据淘汰策略

分布式锁:setnx、redisson

消息队列、延迟队列

常见数据类型的应用场景

- String 类型的应用场景:缓存对象、常规计数、分布式锁、共享 session 信息等。

- List 类型的应用场景:消息队列(但是有两个问题:1. 生产者需要自行实现全局唯一 ID;2. 不能以消费组形式消费数据)等。

- Hash 类型:缓存对象、购物车等。

- Set 类型:聚合计算(并集、交集、差集)场景,比如点赞、共同关注、抽奖活动等。

- Zset 类型:排序场景,比如排行榜、电话和姓名排序等。

Redis 后续版本又支持四种数据类型,它们的应用场景如下:

- BitMap(2.2 版新增):二值状态统计的场景,比如签到、判断用户登陆状态、连续签到用户总数等;

- HyperLogLog(2.8 版新增):海量数据基数统计的场景,比如百万级网页 UV 计数等;

- GEO(3.2 版新增):存储地理位置信息的场景,比如滴滴叫车;

- Stream(5.0 版新增):消息队列,相比于基于 List 类型实现的消息队列,有这两个特有的特性:自动生成全局唯一消息ID,支持以消费组形式消费数据。

Redis 的I/O多路复用模型

简单来说有以下几个原因:

- 完全基于内存的,C语言编写

- 采用单线程,避免不必要的上下文切换可竞争条件

- 使用多路I/O复用模型,非阻塞IO

例如:bgsave 和 bgrewriteaof 都是在后台执行操作,不影响主线程的正常使用,不会产生阻塞

详细的说有以下几个原因

- Redis 的大部分操作都在内存中完成,并且采用了高效的数据结构,因此 Redis 瓶颈可能是机器的内存或者网络带宽,而并非 CPU,既然 CPU 不是瓶颈,那么自然就采用单线程的解决方案了;

- Redis 采用单线程模型可以避免了多线程之间的竞争,省去了多线程切换带来的时间和性能上的开销,而且也不会导致死锁问题。

- Redis 采用了I/O 多路复用机制处理大量的客户端 Socket 请求,IO 多路复用机制是指一个线程处理多个 IO 流,就是我们经常听到的 select/epoll 机制。简单来说,在 Redis 只运行单线程的情况下,该机制允许内核中,同时存在多个监听 Socket 和已连接 Socket。内核会一直监听这些 Socket 上的连接请求或数据请求。一旦有请求到达,就会交给 Redis 线程处理,这就实现了一个 Redis 线程处理多个 IO 流的效果。

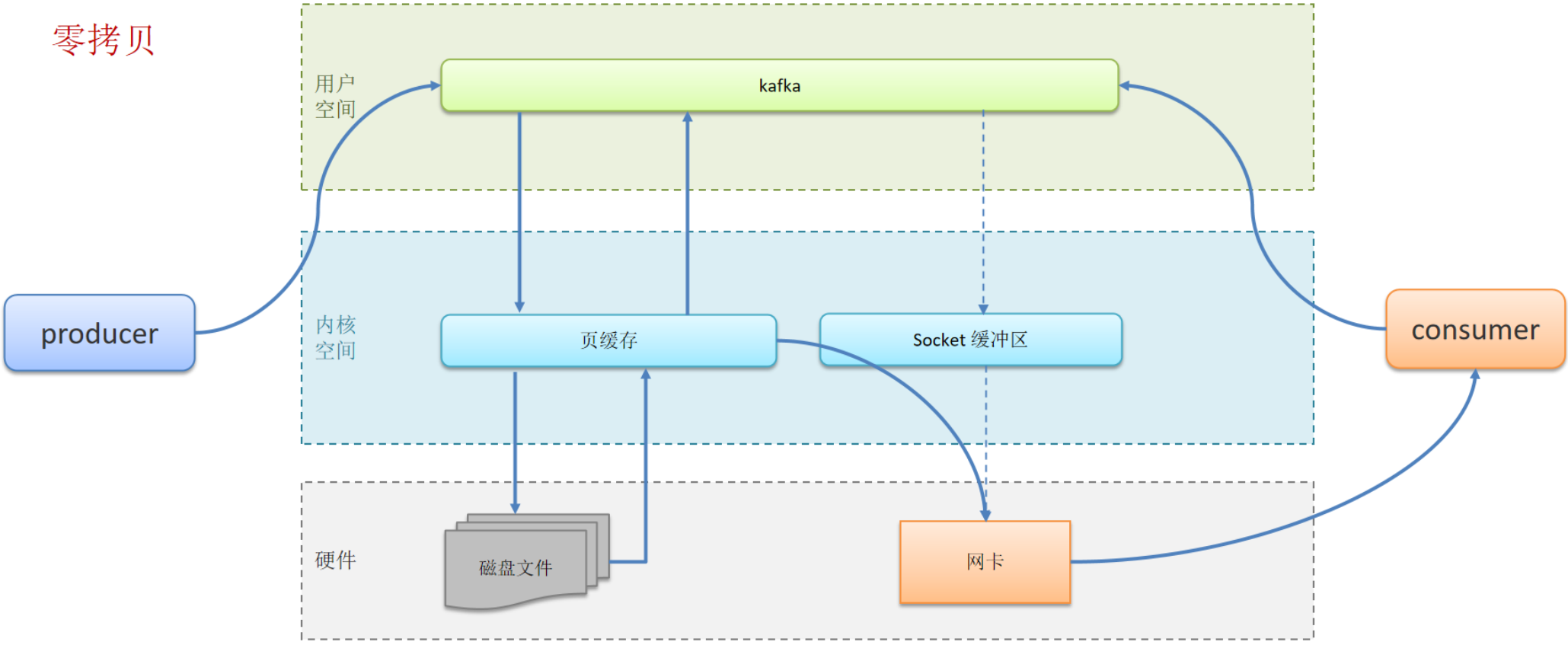

I/O多路复用是指利用单个线程来同时监听多个Socket ,并在某个Socket可读、可写时得到通知,从而避免无效的等待,充分利用CPU资源。目前的I/O多路复用都是采用的epoll模式实现,它会在通知用户进程Socket就绪的同时,把已就绪的Socket写入用户空间,不需要挨个遍历Socket来判断是否就绪,提升了性能。

I/O多路复用模型是Redis的网络模型,它结合事件的处理器来应对多个Socket请求,比如,提供了连接应答处理器、命令回复处理器,命令请求处理器;

在Redis6.0之后,为了提升更好的性能,在命令回复处理器使用了多线程来处理回复事件,在命令请求处理器中,将命令的转换使用了多线程,增加命令转换速度,在命令执行的时候,依然是单线程

Redis 的两种数据持久化

RDB(Redis Database Backup file:Redis数据备份文件)

RDB:是一个二进制的快照文件,它是把Redis内存存储的数据写到磁盘上,当Redis实例宕机恢复数据的时候,方便从RDB的快照文件中恢复数据

开启RDB:在redis.conf文件中找到,格式如下:

1

2

3save 900 1 # 900秒内,如果至少有1个key被修改,则执行bgsave

save 300 10 # 原理同上

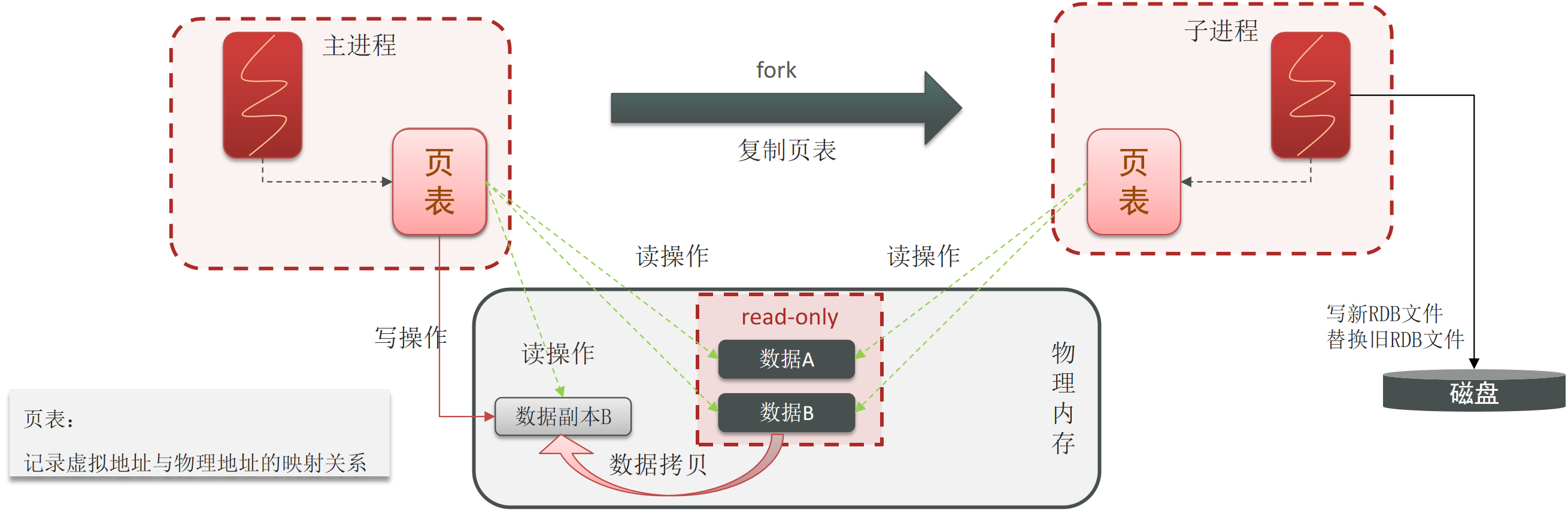

save 60 10000 # 原理同上RDB执行原理:bgsave开始时会fork主进程得到子进程,子进程共享主进程的内存数据。完成fork后读取内存数据并写入 RDB 文件。

AOF(Append Only File:追加文件)

AOF:Redis处理的每一个写命令都会记录在AOF文件,可以看做是命令日志文件

开启AOF:

1

2

3

4# 是否开启AOF功能,默认是no

appendonly yes

# AOF文件的名称

appendfilename "appendonly.aof"修改AOF的记录频率:

1

2

3

4

5

6# 表示每执行一次写命令,立即记录到AOF文件

appendfsync always

# 写命令执行完先放入AOF缓冲区,然后表示每隔1秒将缓冲区数据写到AOF文件,是默认方案

appendfsync everysec

# 写命令执行完先放入AOF缓冲区,由操作系统决定何时将缓冲区内容写回磁盘

appendfsync no配置项 刷盘时机 优点 缺点 always 同步刷盘 可靠性高,几乎不丢数据 性能影响大 everysec 每秒刷盘 性能适中 最多丢失1秒数据 no 操作系统控制 性能最好 可靠性较差,可能丢失大量数据 修改AOF的自动去重写阈值:

1

2

3

4

5

6# 表示每执行一次写命令,立即记录到AOF文件

appendfsync always

# 写命令执行完先放入AOF缓冲区,然后表示每隔1秒将缓冲区数据写到AOF文件,是默认方案

appendfsync everysec

# 写命令执行完先放入AOF缓冲区,由操作系统决定何时将缓冲区内容写回磁盘

appendfsync noRDB与AOF对比:

** ** RDB AOF 持久化方式 定时对整个内存做快照 记录每一次执行的命令 数据完整性 不完整,两次备份之间会丢失 相对完整,取决于刷盘策略 文件大小 会有压缩,文件体积小 记录命令,文件体积很大 宕机恢复速度 很快 慢 数据恢复优先级 低,因为数据完整性不如AOF 高,因为数据完整性更高 系统资源占用 高,大量CPU和内存消耗 低,主要是磁盘IO资源但AOF重写时会占用大量CPU和内存资源 使用场景 可以容忍数分钟的数据丢失,追求更快的启动速度 对数据安全性要求较高常见

Redis 的 Pipeline 功能是什么?

pipeline(管道)使得客户端可以一次性将要执行的多条命令封装成块一起发送给服务端

优点:

- 减少网络往返次数:

- Pipeline 可以将多次网络往返减少为一次,显著提高了执行效率。

- 提高吞吐量:

- 对于批量操作,使用 Pipeline 可以显著提高吞吐量,尤其是在高延迟网络环境中。

- 简化代码逻辑:

- 对于批量操作,使用 Pipeline 可以简化客户端代码,避免频繁地打开和关闭连接。

缓存的常见问题

缓存穿透

缓存穿透:查询一个不存在的数据,mysql查询不到数据也不会直接写入缓存,就会导致每次请求都查数据库

解决方案:

- 缓存空数据,查询返回的数据为空,仍把这个空结果进行缓存(简单,但是消耗内存,且可能会发生不一致的问题)

- 布隆过滤器(内存占用较少,没有多余key,但是实现复杂,存在误判)

布隆过滤器原理:布隆过滤器是一个以(bit)位为单位的很长的数组,数组中每个单元只能存储二进制数0或1。当一个key来了之后经过3次hash计算,模于数组长度找到数据的下标然后把数组中原来的0改为1,这样一来,三个数组的位置就能标明一个key的存在。

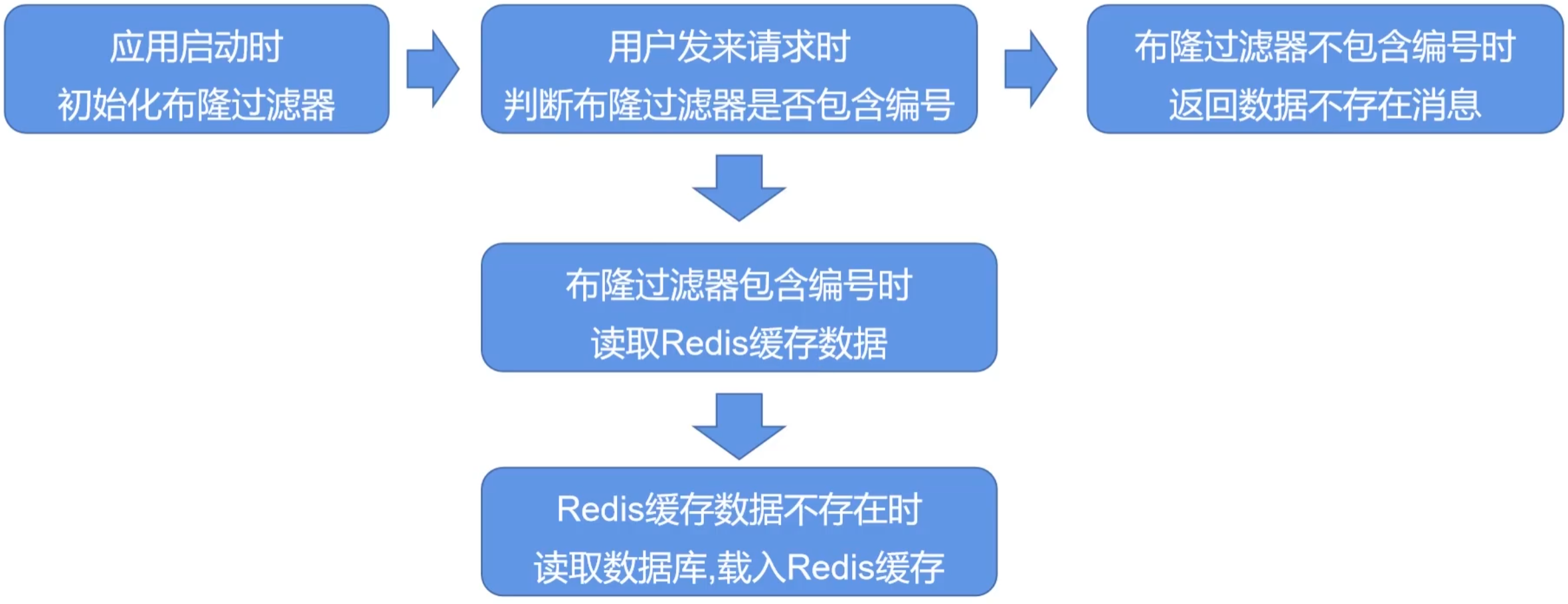

布隆过滤器在项目中的使用流程:

如果数据被删除了怎么办?1). 定时异步重建布隆过滤器;2). 换用“计数型布隆过滤器”

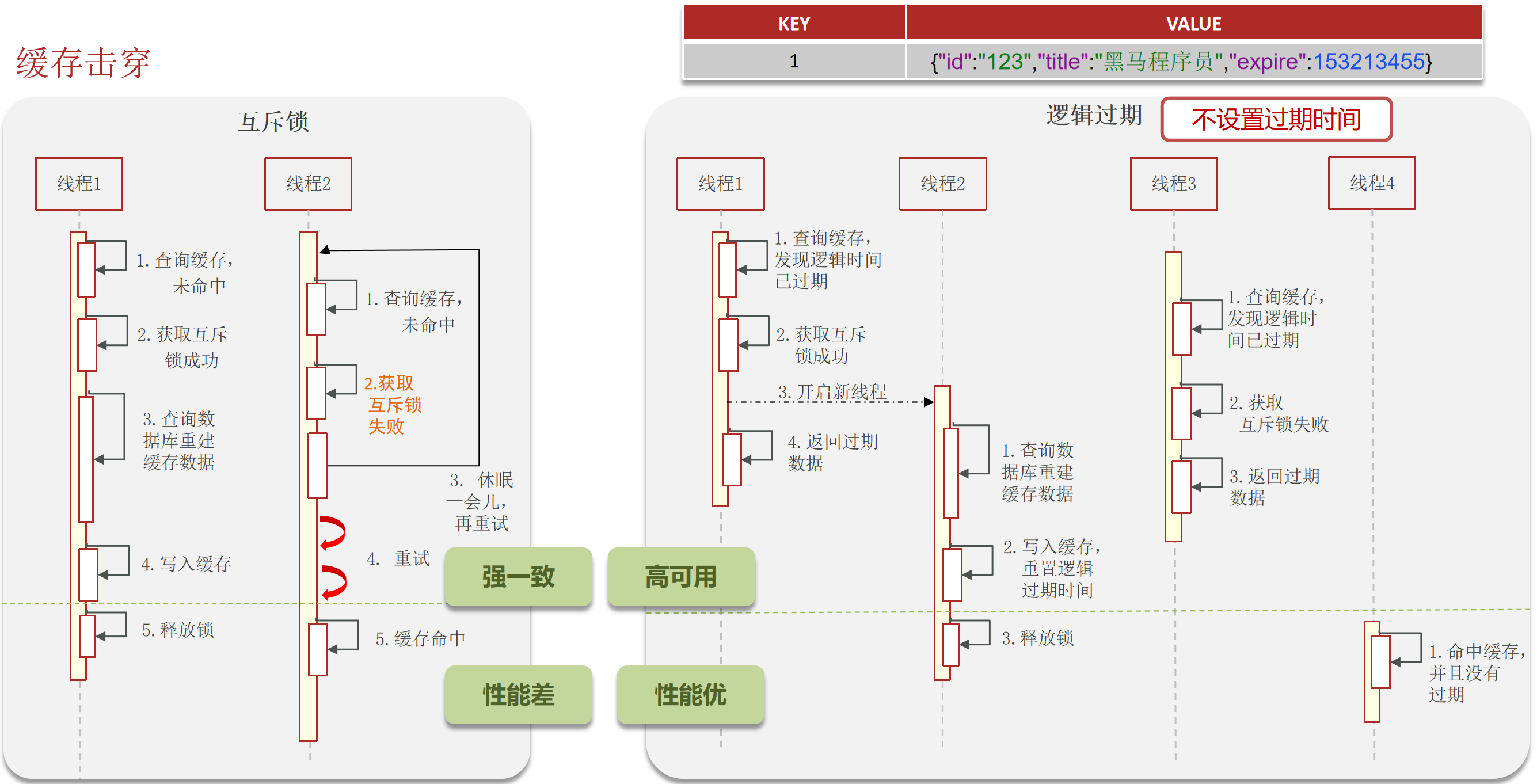

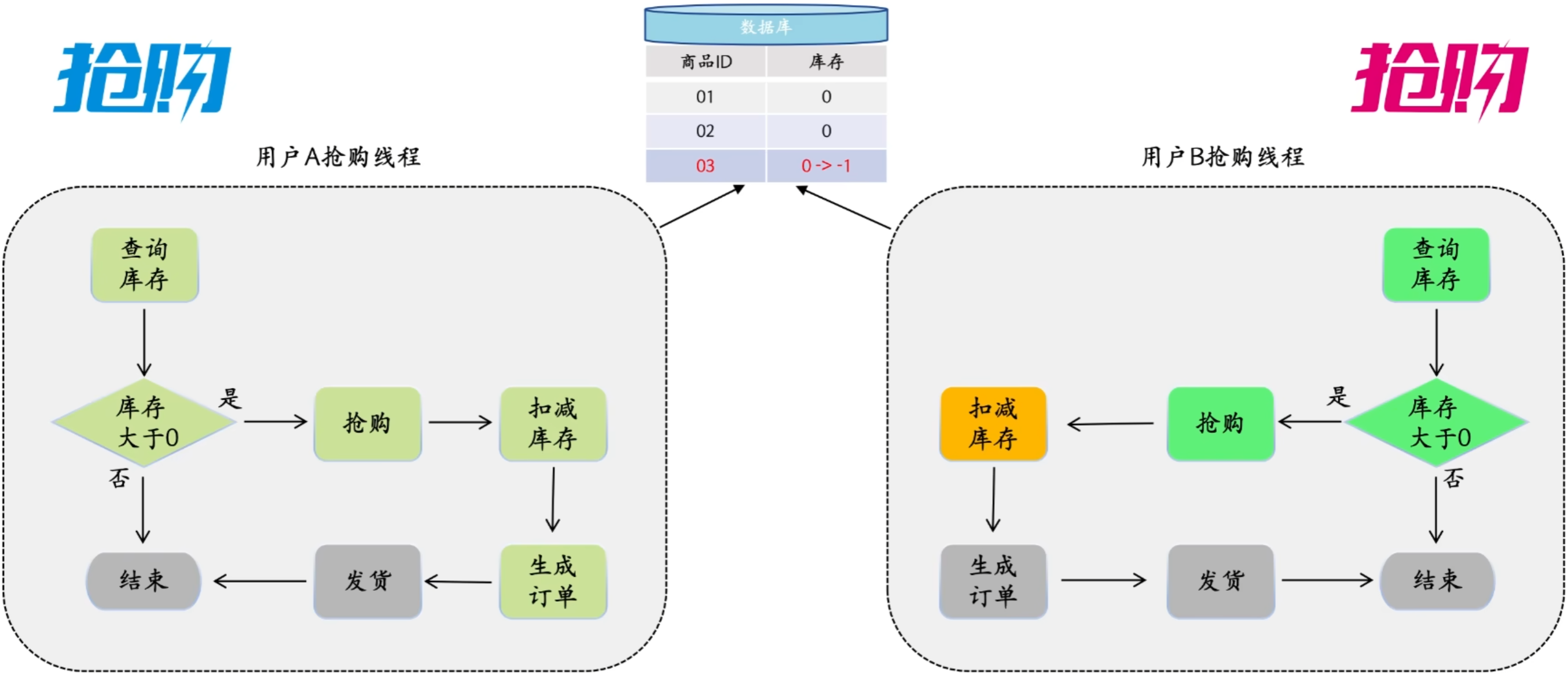

缓存击穿

缓存击穿:key过期的时候,恰好这时间点对这个key有大量的并发请求过来,这些并发的请求可能会瞬间把DB压垮

解决方案:

- 互斥锁(强一致性,但是性能差)

- 逻辑过期(高可用性、性能优,但是有一致性问题)

缓存雪崩

缓存雪崩:是指在同一时段大量的缓存key同时效或者Redis服务宕机,导致大量请求到达数据库,带来巨大压力。

解决方案:

- 给不同的Key的TTL添加随机值

- 利用Redis集群提高服务的可用性(哨兵模式、集群模式)

- 给缓存业务添加降级限流策略(ngxin或spring cloud gateway)

- 给业务添加多级缓存(Guava或Caffeine)

大Key问题

什么是 大 key?

- String 类型的值大于 10 KB;

- Hash、List、Set、ZSet 类型的元素的个数超过 5000个;

大 key 带来的问题

- 客户端超时阻塞。由于 Redis 执行命令是单线程处理,然后在操作大 key 时会比较耗时,那么就会阻塞 Redis,从客户端这一视角看,就是很久很久都没有响应。

- 引发网络阻塞。每次获取大 key 产生的网络流量较大,如果一个 key 的大小是 1 MB,每秒访问量为 1000,那么每秒会产生 1000MB 的流量,这对于普通千兆网卡的服务器来说是灾难性的。

- 阻塞工作线程。如果使用 del 删除大 key 时,会阻塞工作线程,这样就没办法处理后续的命令。

- 内存分布不均。集群模型在 slot 分片均匀情况下,会出现数据和查询倾斜情况,部分有大 key 的 Redis 节点占用内存多,QPS 也会比较大。

如何找到大 key ?

1、–bigkeys 查找大key

可以通过 redis-cli –bigkeys 命令查找大 key:

1 | redis-cli -h 127.0.0.1 -p 6379 |

使用的时候注意事项:

- 最好选择在从节点上执行该命令。因为主节点上执行时,会阻塞主节点;

- 如果没有从节点,那么可以选择在 Redis 实例业务压力的低峰阶段进行扫描查询,以免影响到实例的正常运行;或者可以使用 -i 参数控制扫描间隔,避免长时间扫描降低 Redis 实例的性能。

该方式的不足之处:

- 这个方法只能返回每种类型中最大的那个 bigkey,无法得到大小排在前 N 位的 bigkey;

- 对于集合类型来说,这个方法只统计集合元素个数的多少,而不是实际占用的内存量。但是,一个集合中的元素个数多,并不一定占用的内存就多。因为,有可能每个元素占用的内存很小,这样的话,即使元素个数有很多,总内存开销也不大;

2、使用 SCAN 命令查找大 key

使用 SCAN 命令对数据库扫描,然后用 TYPE 命令获取返回的每一个 key 的类型。

对于 String 类型,可以直接使用 STRLEN 命令获取字符串的长度,也就是占用的内存空间字节数。